Evaluaciones del supervisor de estado del modelo

Puede configurar las evaluaciones del monitor de estado del modelo para ayudarle a comprender su comportamiento y rendimiento. Puede utilizar las métricas de estado del modelo para determinar la eficacia con la que el despliegue del modelo procesa las transacciones.

Cuando se activan las evaluaciones del estado del modelo, se crea un conjunto de datos de estado del modelo en el mercado de datos. El conjunto de datos de salud del modelo almacena detalles sobre sus solicitudes de puntuación que se utilizan para calcular las métricas de salud del modelo.

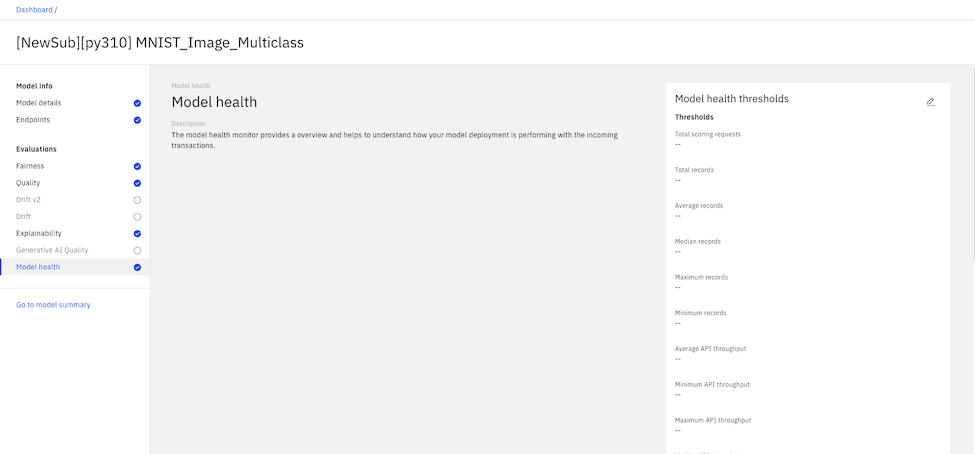

Para configurar evaluaciones de supervisión de estado de modelo, puede establecer valores de umbral para cada métrica tal como se muestra en el ejemplo siguiente:

Las evaluaciones del estado del modelo no son compatibles con las implantaciones previas a la producción.