Model health monitor evaluations

Last updated: Mar 14, 2025

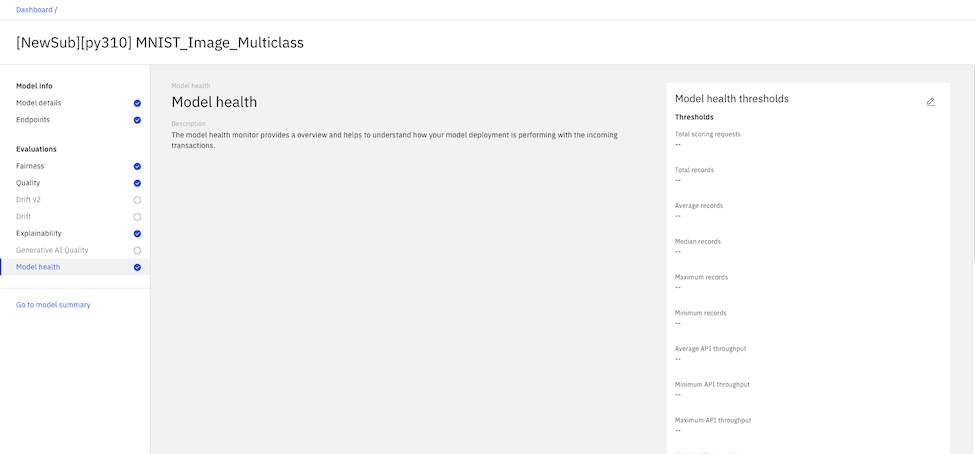

You can configure model health monitor evaluations to help you understand your model behavior and performance. You can use model health metrics to determine how efficiently your model deployment processes your transactions.

When model health evaluations are enabled, a model health data set is created in the data mart. The model health data set stores details about your scoring requests that are used to calculate model health metrics.

To configure model health monitor evaluations, you can set threshold values for each metric as shown in the following example:

Model health evaluations are not supported for pre-production deployments.

Learn more

Was the topic helpful?

0/1000