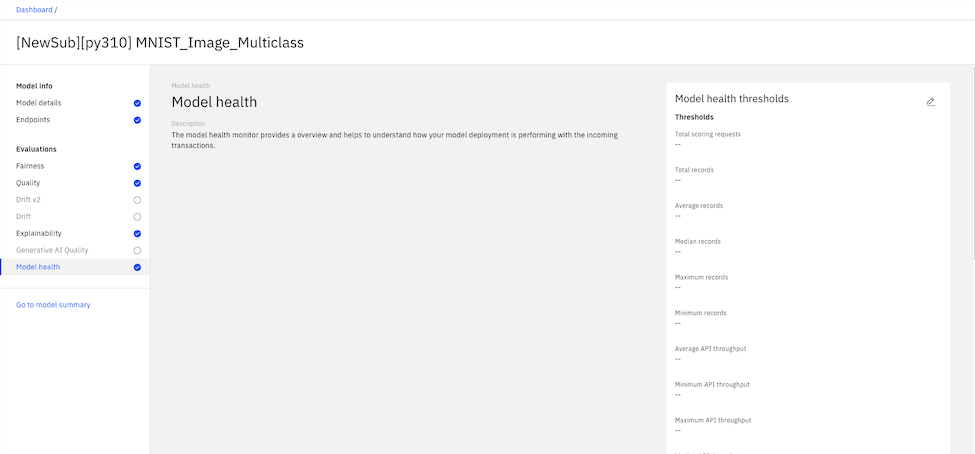

Évaluations du moniteur de santé de modèle

Vous pouvez configurer les évaluations du moniteur de santé du modèle pour vous aider à comprendre le comportement et les performances de votre modèle. Vous pouvez utiliser des métriques de santé de modèle pour déterminer l'efficacité avec laquelle votre déploiement de modèle traite vos transactions.

Lorsque les évaluations de l'état du modèle sont activées, un ensemble de données sur l'état du modèle est créé dans le datamart. L'ensemble de données sur la santé du modèle stocke les détails de vos demandes de notation qui sont utilisés pour calculer les mesures de santé du modèle.

Pour configurer les évaluations du moniteur de santé de modèle, vous pouvez définir des valeurs de seuil pour chaque métrique, comme illustré dans l'exemple suivant:

Les évaluations de l'état des modèles ne sont pas prises en charge pour les déploiements de pré-production.