評価スタジオを使用すると、使用ケースに合った定量的な指標とカスタマイズ可能な基準で、ジェネレーティブAI資産を評価および比較できます。 複数の資産のパフォーマンスを同時に評価し、結果の比較分析を見て、最適なソリューションを特定します。

評価スタジオを使用すると、さまざまなタスクタイプに対して複数のAI資産を評価するプロセスを自動化することで、ジェネレーティブAI開発プロセスを合理化できます。 各プロンプトテンプレートを個別にレビューし、パフォーマンスを手動で比較する代わりに、1つの実験を構成して複数のプロンプトテンプレートを同時に評価できるため、開発中の時間を節約できます。

評価スタジオには以下の機能があり、プロンプトテンプレートを評価および比較して、ニーズに最適なアセットを特定するのに役立ちます:

カスタマイズ可能な実験セットアップ

- お客様のニーズに合わせて、さまざまなタスクタイプからお選びいただけます。

- プロジェクト資産を選択してテストデータをアップロードする。

- 最大5つのプロンプト・テンプレートを選択し、評価・比較することができます。

- 評価ディメンジョンを選択して、タスク固有のメトリクスを構成します。

柔軟な結果分析

- 結果を表やグラフで表示することで、洞察力を高めることができます。

- リファレンス・プロンプト・テンプレートを選択し、比較を容易にする

- 特定のメトリクスまたは値で結果をフィルタリングまたはソートします。

- 評価結果の範囲を指定して検索する。

- チャートで複数のプロンプト・テンプレートを並べて比較。

- AI Factsheetsに評価の詳細を自動的に記録し、AIユースケース全体のパフォーマンスを追跡。

- カスタムランキングを作成して、ユースケースにとって最も重要な結果に優先順位を付けます。

- 実験からプロンプト・テンプレートを追加または削除し、評価を再実行して新たな比較を行う。

要件

以下の条件を満たせば、評価スタジオでAI資産を比較できます:

必須ロール

評価スタジオを使用するには、 watsonx.governance で サービスへのアクセスリーダー ロールが割り当てられている必要があります。 また、プロジェクトの Admin または Editor ロールと、プロジェクトで使用する Cloud Object Storage バケットの Writer ロールが割り当てられている必要があります。

サービス・プラン

評価スタジオは、特定のサービスプランおよびデータセンターに限定されています。 詳細については、 watsonx.ai Studio のサービスプランと、 サービスおよび機能の地域別提供状況をご覧ください。

プロンプト・テンプレート

現在、評価スタジオでプロンプトテンプレートを評価および比較する場合、次の制限が適用されます:

- プロンプト・テンプレート評価は、プロジェクト内でのみ実行できます。

- プロンプトテンプレートの評価結果には、実行した最新の評価の詳細が常に表示されます。

- 同じプロンプトテンプレートの評価が実行中の場合は、プロンプトテンプレートの評価を実行できない。

- 少なくとも2つのプロンプトテンプレートを評価しなければならない。

- 切り離されたプロンプトテンプレートは評価できない。

- プロンプトテンプレートは、同じプロジェクト内になければなりません。

- プロンプト・テンプレートは、変数の数と名前が同じでなければなりません。

- プロンプト・テンプレートは、テスト・データの同じカラム名にマッピングする必要があります。

- プロンプトテンプレートは、どのタイプのモデルでもインポートまたはエクスポートすることはできません。

- 同じタスクタイプが各プロンプトテンプレートに関連付けられなければならない。

- プロンプトテンプレートでは、以下のタスクタイプがサポートされている:

- 機密区分

- 要約

- 生成

- 質問への回答

- エンティティー抽出

- 取得の拡張生成

各プロンプトテンプレートは、同じまたは異なるファンデーションモデルに関連付けることができる。

テスト・データ

アップロードするテストデータには、各プロンプト変数の参照出力列と参照入力列が含まれている必要があります。 参照出力列は、ROUGEやBLEUなどの参照ベースのメトリクスを計算するために使用される。 詳細は 、「モデル評価のためのデータの管理 」を参照してください。

リソース使用量

Evaluation Studioを使用するために必要なリソースは、実験ごとに計算されます。 実行した各評価は、1つの実験として計算される。 プロンプトテンプレート、評価記録、モニタリングの次元の数が多ければ多いほど、1回の実験により多くのリソースが必要となる。

次のセクションでは、評価スタジオを使用してAI資産を評価および比較する方法について説明します:

複数のAI資産の比較と評価

評価スタジオを使用して資産を評価および比較するには、次の手順を実行します:

- 評価タスクを選択する。

- watsonx.governance プロジェクトの [Assets] タブで、[ New asset ] を選択します。

- 何をしますか ]ウィンドウで、 [プロンプトの評価と比較] タスクタイルを選択します。

- 評価を設定する。 プロンプトの評価と比較ウィザードが開き、評価に使用できるタスクタイプが表示されたら、評価名を指定し、評価するプロンプトテンプレートに関連付けられているタスクタイプを選択します。

- 評価および比較するプロンプトテンプレートをプロジェクトから選択します。

- メトリックを選択してください。

Watsonx.governance は、プロンプト テンプレートのタスク タイプで使用可能なメトリックを自動的に選択し、各メトリックのデフォルト設定を構成する。 メトリックの選択を変更したり、 構成を選択してカスタマイズされた設定で評価を構成することができます。 - プロジェクトからアセットを選択してテストデータを選択します。

テストデータを選択すると、 watsonx.governance自動的にプロンプト変数にマッピングされたカラムを検出します。 - 評価を見直し、実行する。

- プロンプト テンプレートの評価を実行する前に、タスク タイプ、アップロードされたテスト データ、メトリックス、および実行される評価のタイプの選択を確認できます。

- 評価を実行した後、「 ジョブの表示 」を選択すると、進行中の評価のステータスや、あなたが完了した過去の評価を表示するリストを見ることができます。

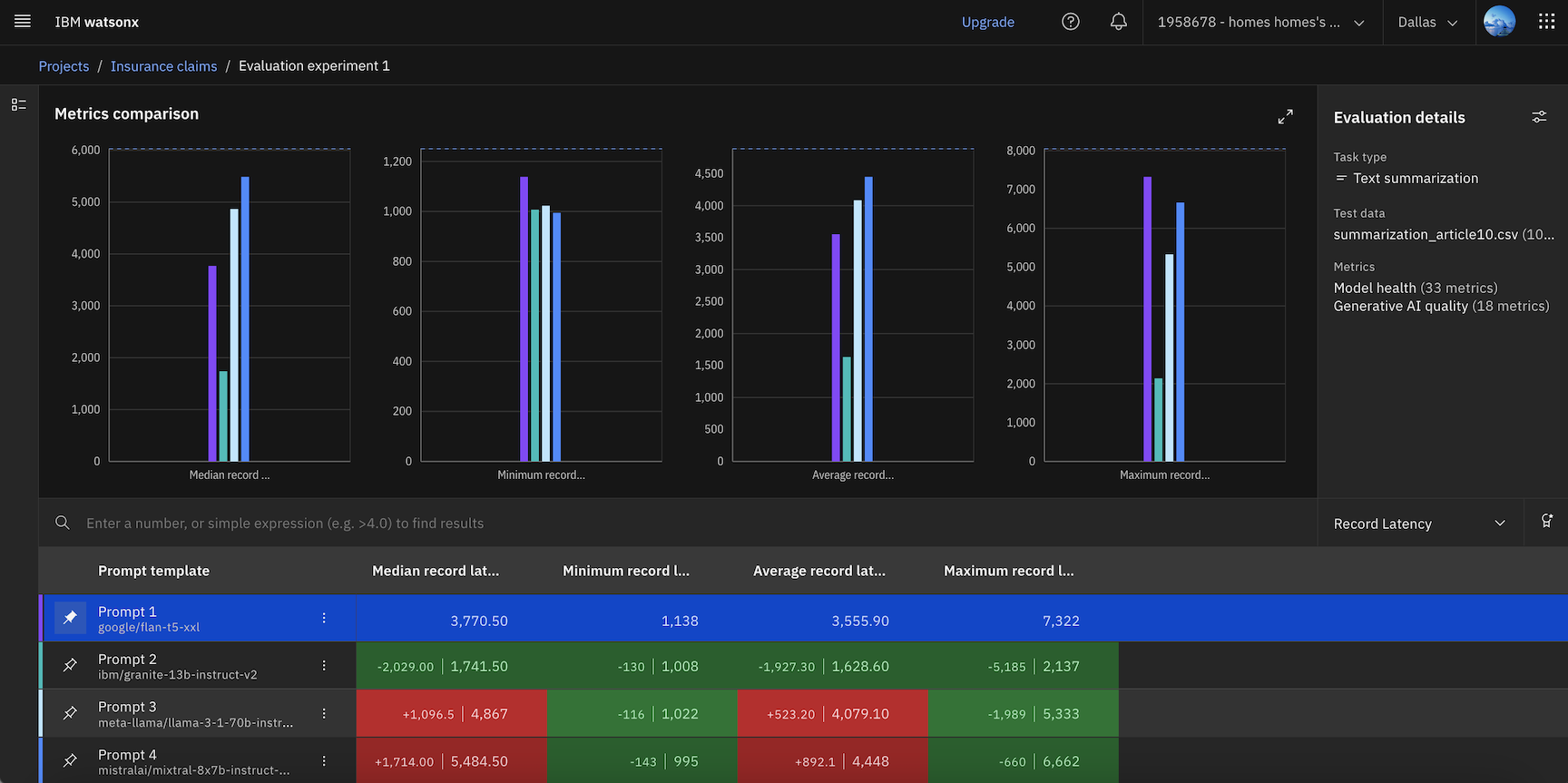

- メトリクスの比較を見直す。

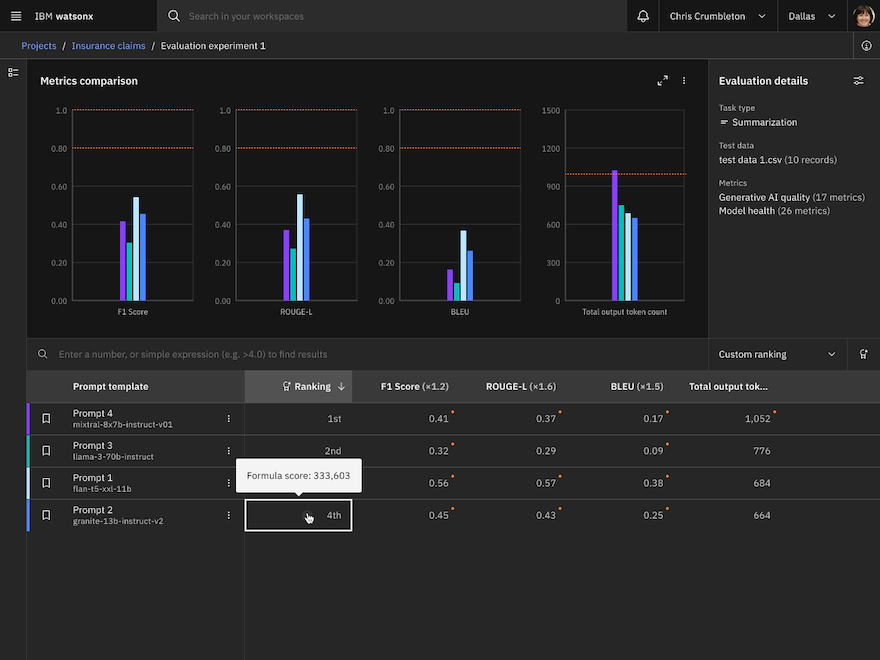

- 評価が完了すると、選択した各プロンプトテンプレートの結果を比較するデータビジュアライゼーションを表示できます。 スコアが各指標のしきい値に違反しているかどうかが視覚化される。 また、結果は表に表示され、アセットについて表示したいメトリクスを選択、フィルタリング、またはランク付けすることによって、結果を分析するために使用できます。

- 比較を行うには、参照アセットを選択すると、表の列が強調表示され、他のアセットが選択したアセットよりもパフォーマンスが良いか悪いかが示されます。

- 結果を分析するために、重み係数とランキング式を指定して、異なるグループ間のメトリクスのカスタム・ランキングを作成し、どのプロンプト・テンプレートが最高のパフォーマンスを持つかを決定することもできます。

- 評価を再実行する場合は、 評価詳細ペインの Adjust settings

をクリックして、テスト データの更新やメトリクスの再設定を行います。

をクリックして、テスト データの更新やメトリクスの再設定を行います。 - 実験を編集したい場合は、 Edit Assets

をクリックし、評価にアセットを削除または追加して比較を変更します。

をクリックし、評価にアセットを削除または追加して比較を変更します。

今後のステップ

これで、プロジェクトに新しいAI評価アセットが作成されました。 アセットをプロジェクトで再度開いて、編集したり、新しい実験を実行することができます。

詳細情報

親トピック AIモデルの評価