Vous pouvez créer un déploiement détaché pour évaluer les modèles d'invite pour les modèles de base qui ne sont pas créés ou hébergés par IBM.

Pour évaluer les modèles de base externes dans watsonx.governance, vous pouvez créer un déploiement détaché dans un espace de déploiement pour vous connecter à votre modèle d'invite externe. Lorsque vous évaluez un déploiement détaché, vous pouvez mesurer l'efficacité avec laquelle votre modèle externe génère des réponses pour les types de tâche suivants:

- Synthèse de texte

- Classification de texte

- Réponse aux questions

- Extraction d'entités

- Génération de contenu

- Génération augmentée de recherche (RAG)

Avant de commencer

Droits requis

Vous devez disposer des rôles Admin ou Editeur pour évaluer les déploiements détachés dans un espace de déploiement.

Dans votre projet, vous pouvez créer et évaluer un modèle d'invite détaché et promouvoir un modèle d'invite détaché dans un espace de déploiement.

Si vous ne promouvez pas un modèle d'invite détaché dans un espace de déploiement, vous devez créer un modèle d'invite détaché qui connecte votre modèle externe à watsonx.governance avant d'évaluer les modèles d'invite détachés dans les espaces. Vous devez fournir des détails de connexion tels que le nom de votre modèle externe et son URL lorsque vous créez le modèle d'invite détaché. L'exemple suivant montre comment créer un modèle d'invite détaché avec l'API:

{

"name": "prompt name",

"description": "prompt description",

"model_version": {

"number": "2.0.0-rc.7",

"tag": "my prompt tag",

"description": "my description"

},

"prompt_variables": {

"var1": {},

"var2": {}

},

"task_ids": [

"retrieval_augmented_generation"

],

"input_mode": "detached",

"prompt": {

"model_id": "",

"input": [

[

"Some input",

""

]

],

"data": {},

"external_information": {

"external_prompt_id": "external prompt",

"external_model_id": "external model",

"external_model_provider": "external provider",

"external_prompt": {

"url": "https://asdfasdf.com?asd=a&32=1",

"additional_information": [

{

"additional_key": "additional settings"

}

]

},

"external_model": {

"name": "An external model",

"url": "https://asdfasdf.com?asd=a&32=1"

}

}

}

}

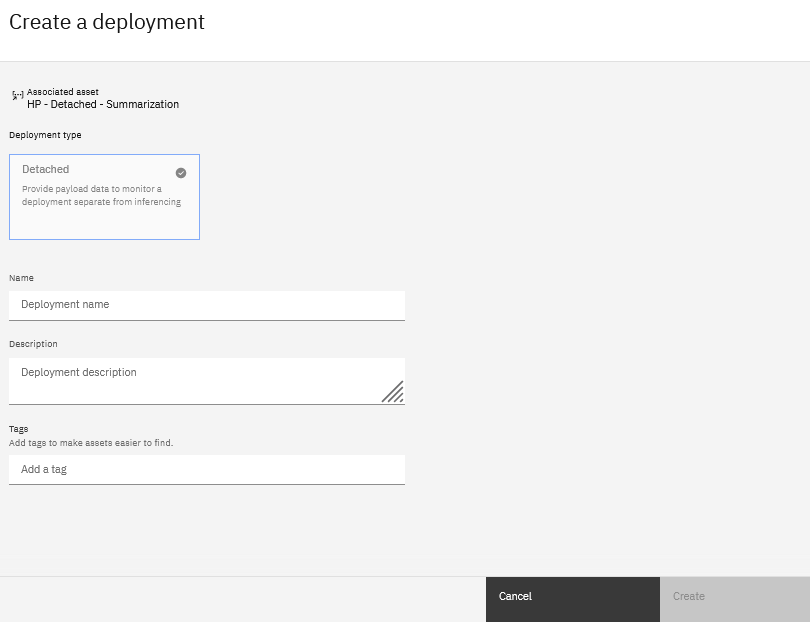

Création d'un déploiement détaché à partir d'un espace

Si vous ne promouvez pas un modèle d'invite détaché vers un espace de déploiement à partir de votre projet, vous devez créer un déploiement détaché à partir d'un espace. Vous pouvez utiliser les étapes suivantes pour créer un déploiement détaché à partir d'un espace de déploiement:

Après avoir créé le modèle d'invite, enregistrez-le dans un espace de déploiement en spécifiant l'ID d'espace.

{ "prompt_template": { "id": "<PT ID>" }, "detached": {}, "base_model_id": "abcabc", "description": "Prompt template deployment description", "name": "Prompt template deployment name", "space_id": "<Space ID>" }Dans l'onglet Actifs de l'espace de déploiement, cliquez sur Nouveau déploiement pour l'actif de modèle d'invite détaché.

Choisissez Détaché comme type de déploiement.

Indiquez un nom et une description facultative pour le déploiement.

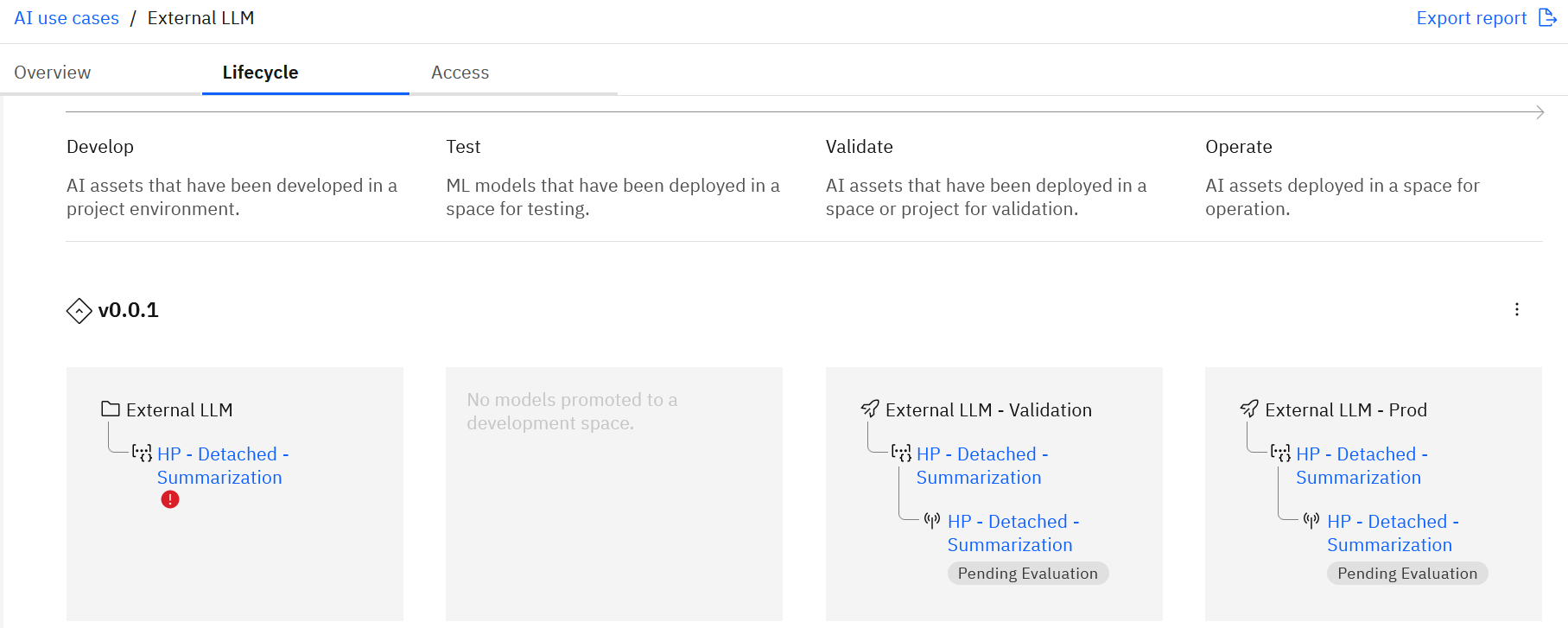

Si vous suivez le modèle d'invite détaché dans un cas d'utilisation d'IA, le déploiement détaché est ajouté au cas d'utilisation.

Evaluation d'un déploiement détaché dans un espace

Les sections suivantes décrivent comment évaluer les déploiements détachés dans les espaces et passer en revue les résultats de votre évaluation:

Evaluation des déploiements détachés dans les espaces de préproduction

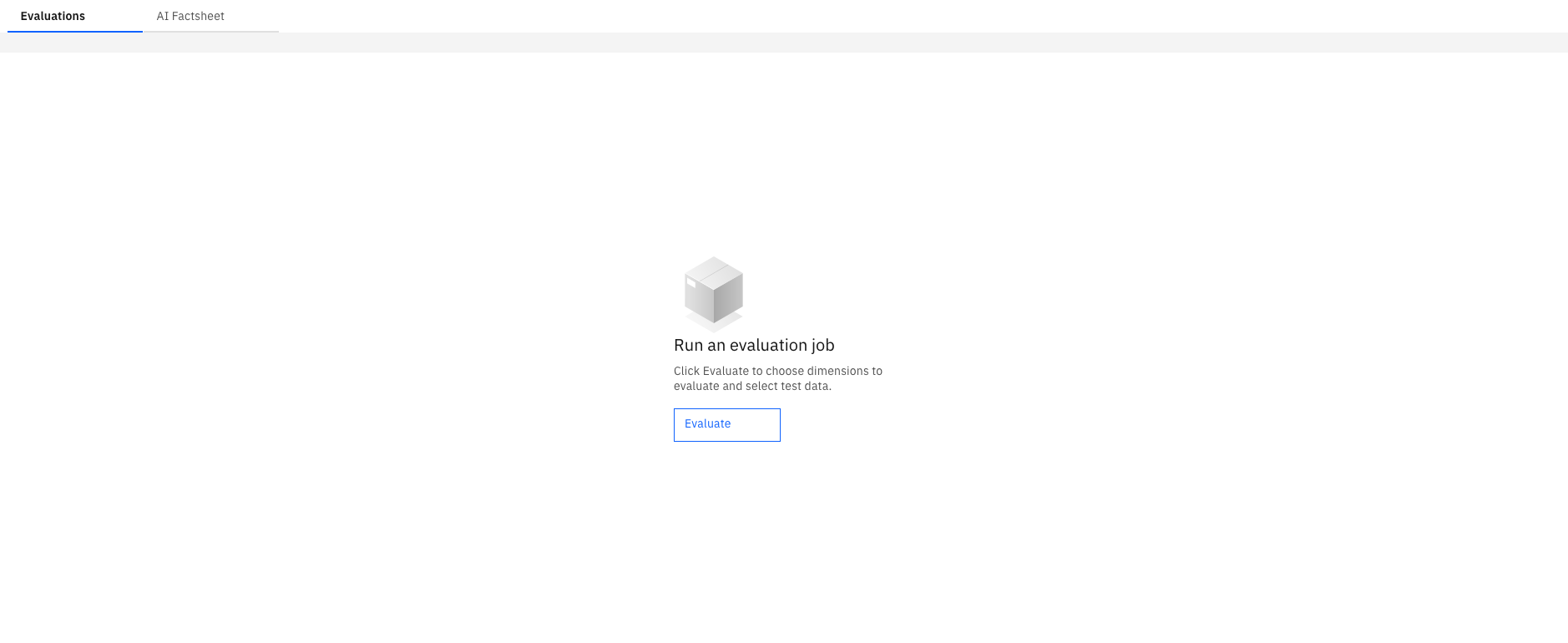

Exécuter une évaluation

Pour exécuter des évaluations de modèle d'invite, vous pouvez cliquer sur Evaluer dans l'onglet Evaluations lorsque vous ouvrez un déploiement pour ouvrir l'assistant Evaluer le modèle d'invite . Vous pouvez exécuter des évaluations uniquement si vous disposez des rôles Admin ou Editeur pour votre espace de déploiement.

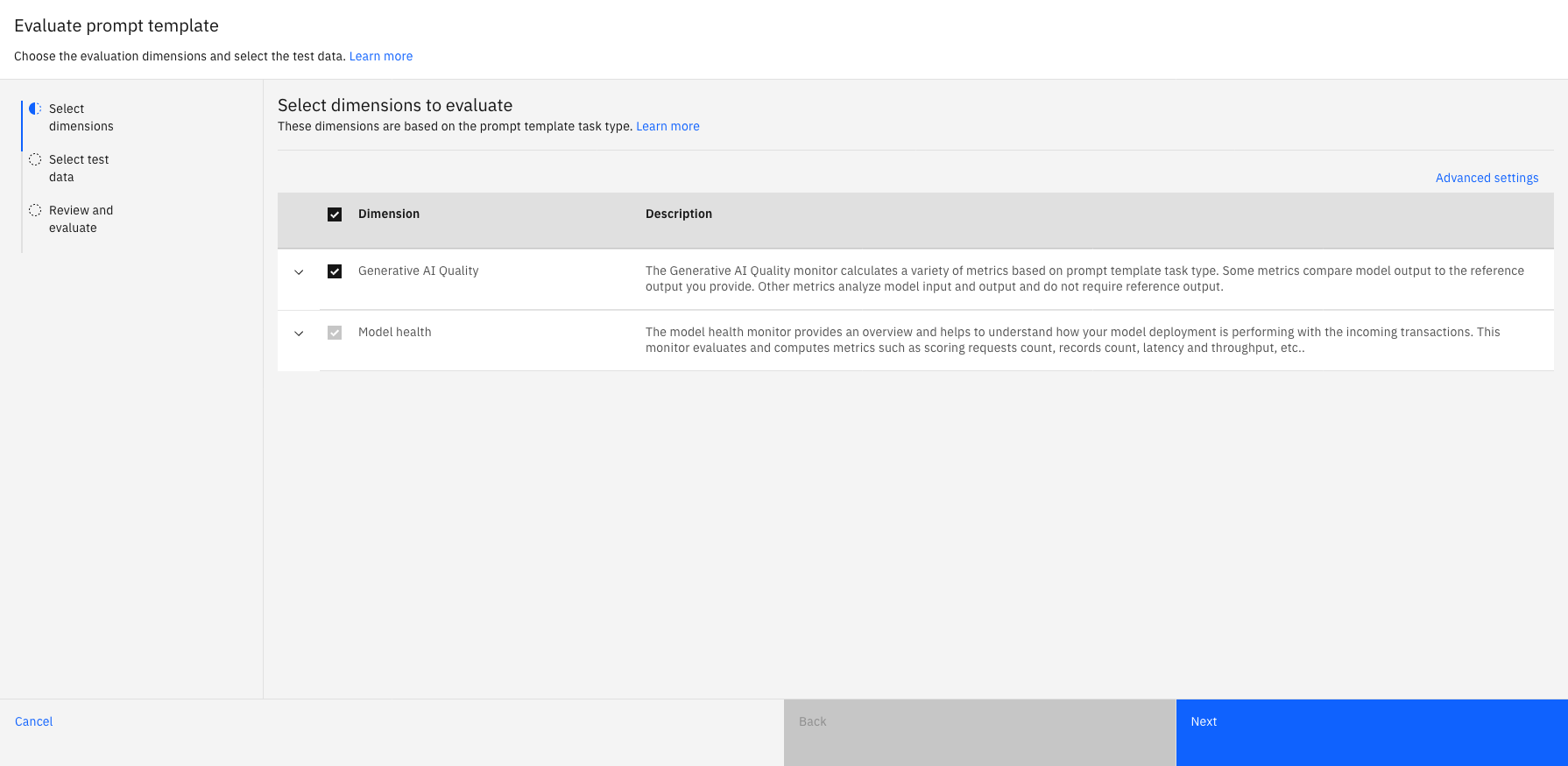

Sélectionner des dimensions

L'assistant Evaluer le modèle d'invite affiche les dimensions disponibles pour l'évaluation du type de tâche associé à votre invite. Vous pouvez développer les dimensions pour afficher la liste des métriques utilisées pour évaluer les dimensions que vous sélectionnez.

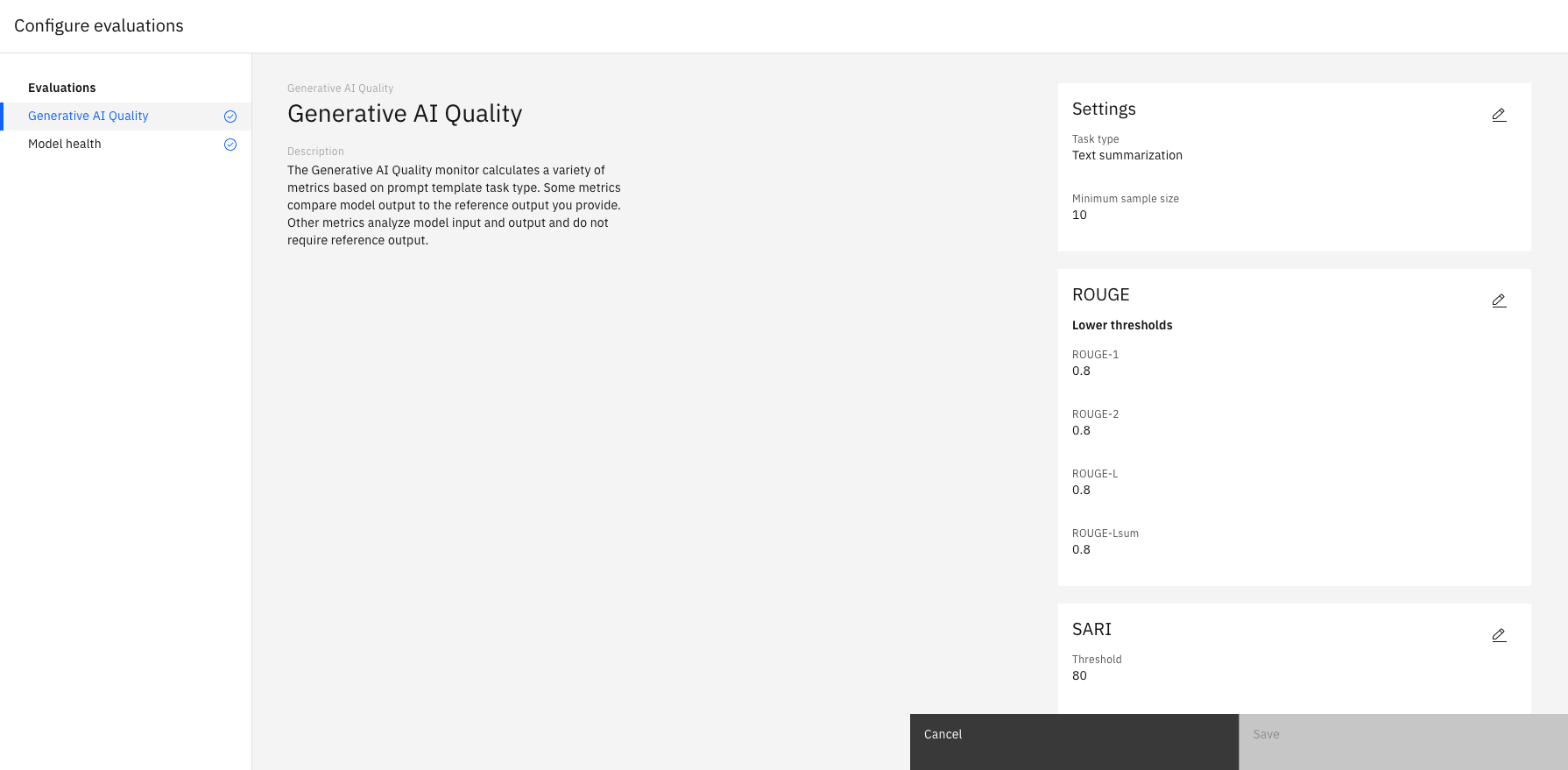

Watsonx.governance configure automatiquement les évaluations pour chaque dimension avec les paramètres par défaut. Pour configurer des évaluations avec des paramètres différents, vous pouvez sélectionner Paramètres avancés afin de définir des tailles d'échantillon et des valeurs de seuil minimales pour chaque métrique, comme illustré dans l'exemple suivant:

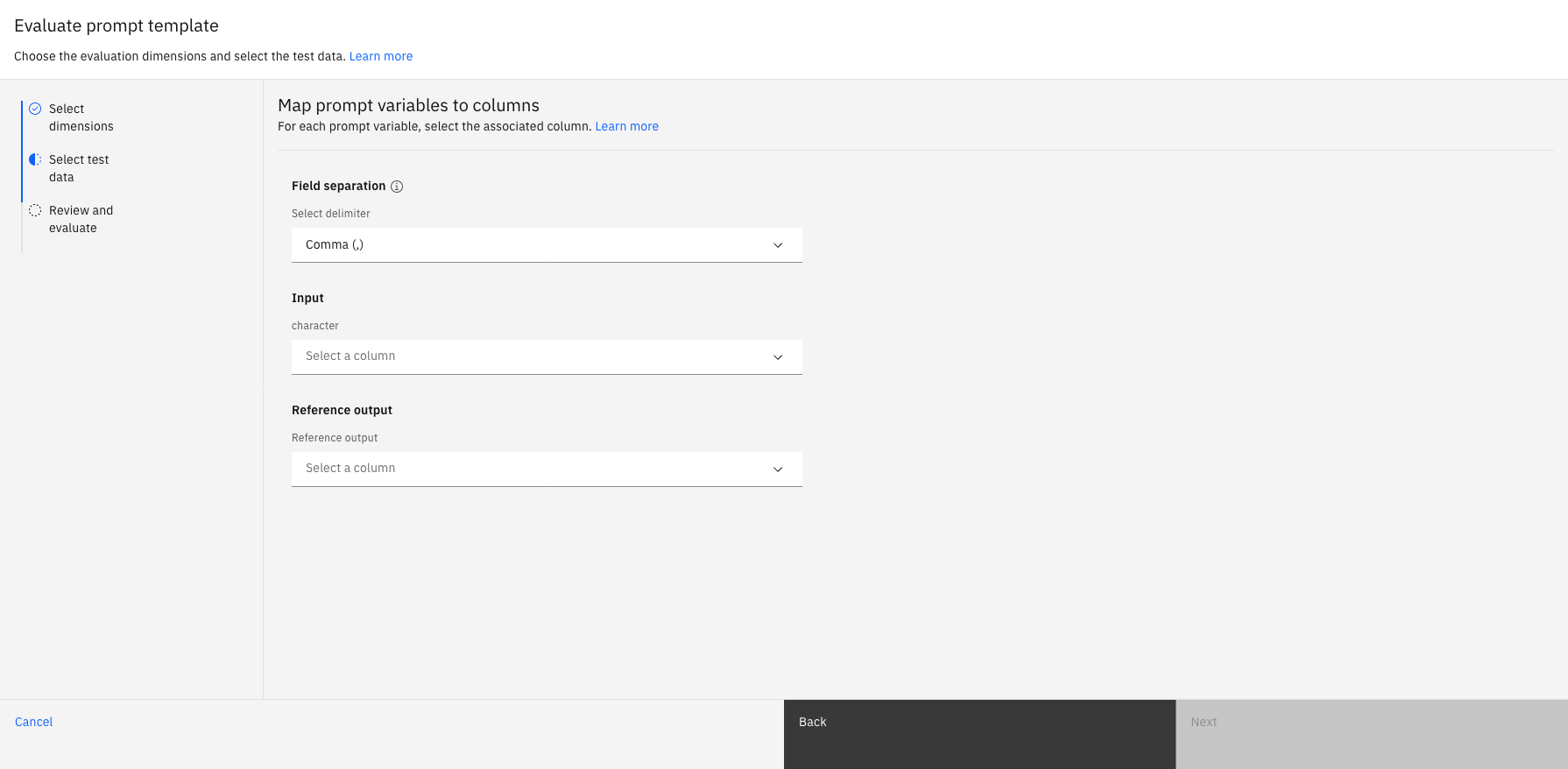

Sélectionner les données de test

Vous devez télécharger un fichier CSV contenant des données de test avec des colonnes de référence qui incluent l'entrée et la sortie de modèle attendue. Les données de test que vous téléchargez doivent contenir la sortie de modèle pour activer les évaluations de déploiement détachées. Lorsque le téléchargement est terminé, vous devez également faire correspondre les variables d'invite aux colonnes associées de vos données de test.

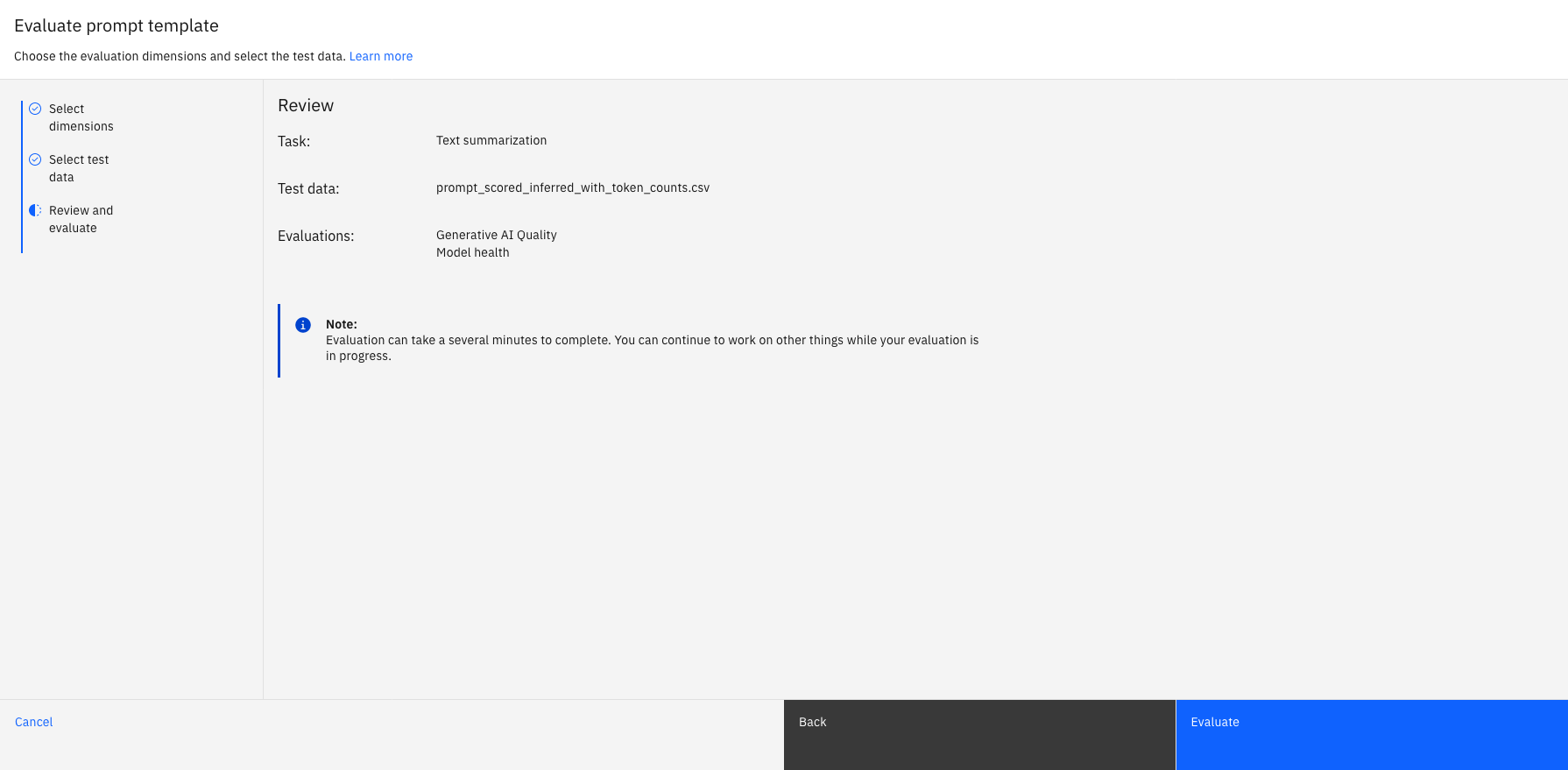

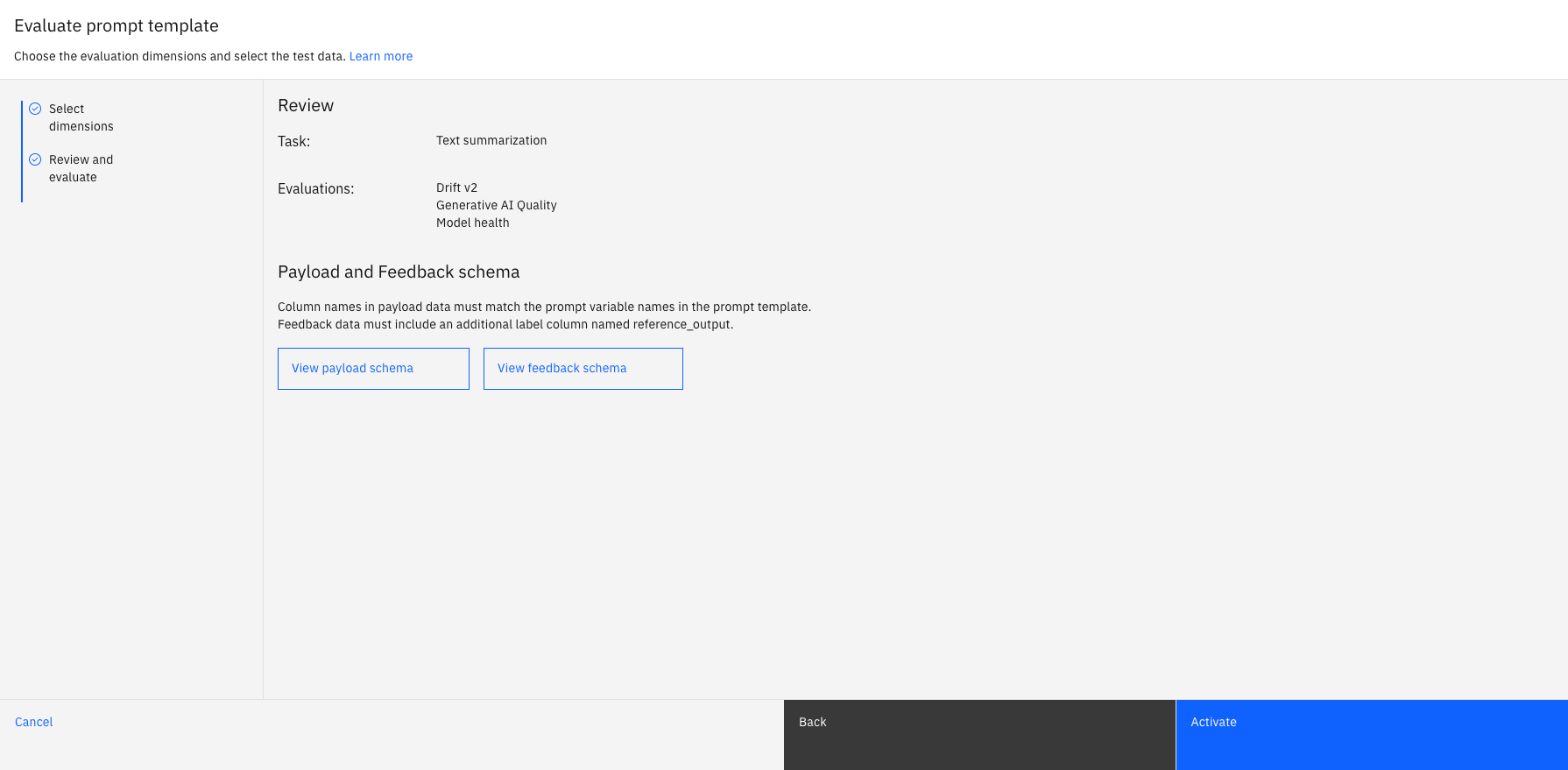

Réviser et évaluer

Vous pouvez passer en revue les sélections pour le type de tâche d'invite, les données de test téléchargées et le type d'évaluation qui s'exécute. Vous devez sélectionner Evaluer pour exécuter l'évaluation.

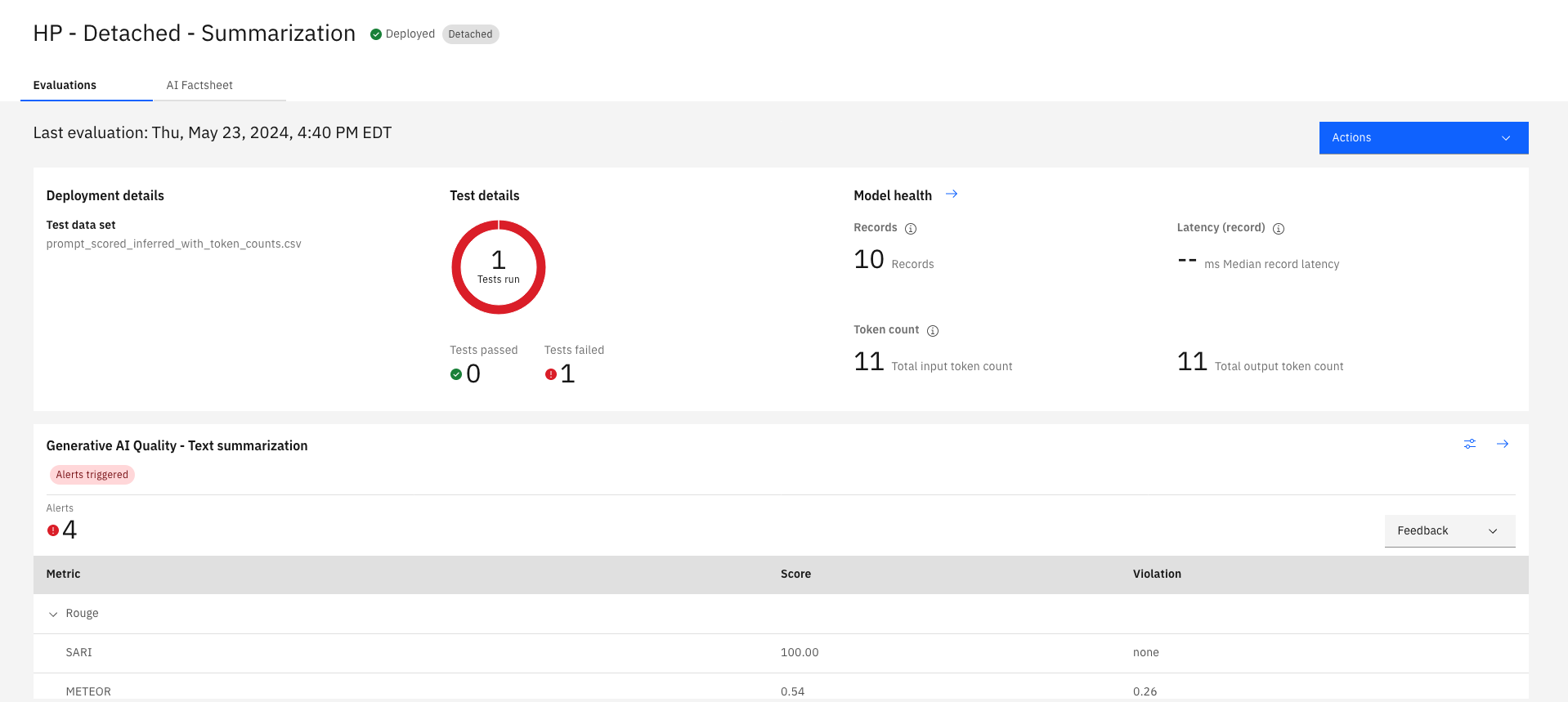

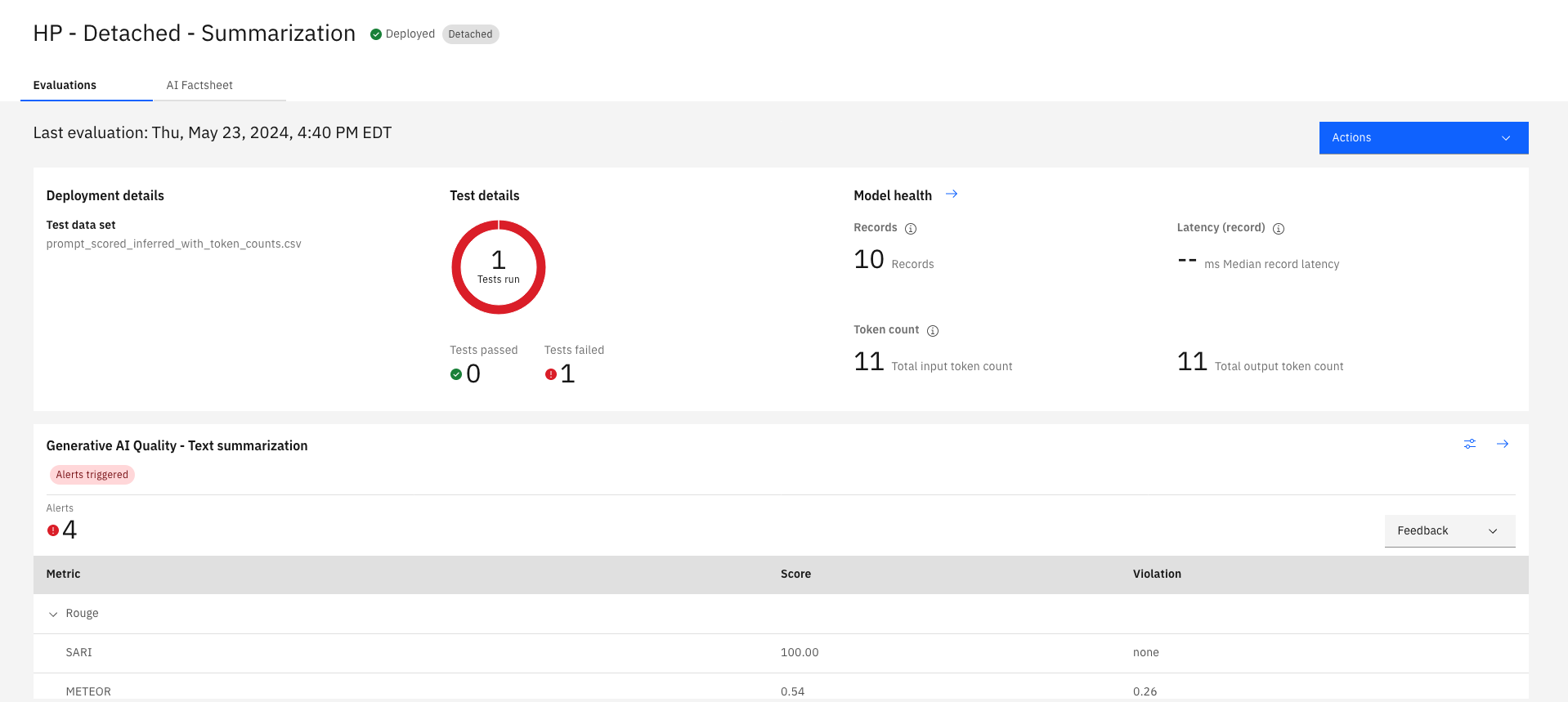

Examen des résultats de l'évaluation

Une fois votre évaluation terminée, vous pouvez consulter un récapitulatif de vos résultats d'évaluation dans l'onglet Evaluations de watsonx.governance pour obtenir des informations sur les performances de votre modèle. Le récapitulatif fournit une vue d'ensemble des scores d'indicateur et des violations des seuils de score par défaut pour vos évaluations de modèle d'invite.

Pour analyser les résultats, vous pouvez cliquer sur la flèche  en regard de l'évaluation de votre modèle d'invite pour afficher les visualisations de données de vos résultats dans le temps. Vous pouvez également analyser les résultats de l'évaluation de la santé du modèle qui est exécutée par défaut lors des évaluations de modèle d'invite afin de comprendre l'efficacité avec laquelle votre modèle traite vos données.

en regard de l'évaluation de votre modèle d'invite pour afficher les visualisations de données de vos résultats dans le temps. Vous pouvez également analyser les résultats de l'évaluation de la santé du modèle qui est exécutée par défaut lors des évaluations de modèle d'invite afin de comprendre l'efficacité avec laquelle votre modèle traite vos données.

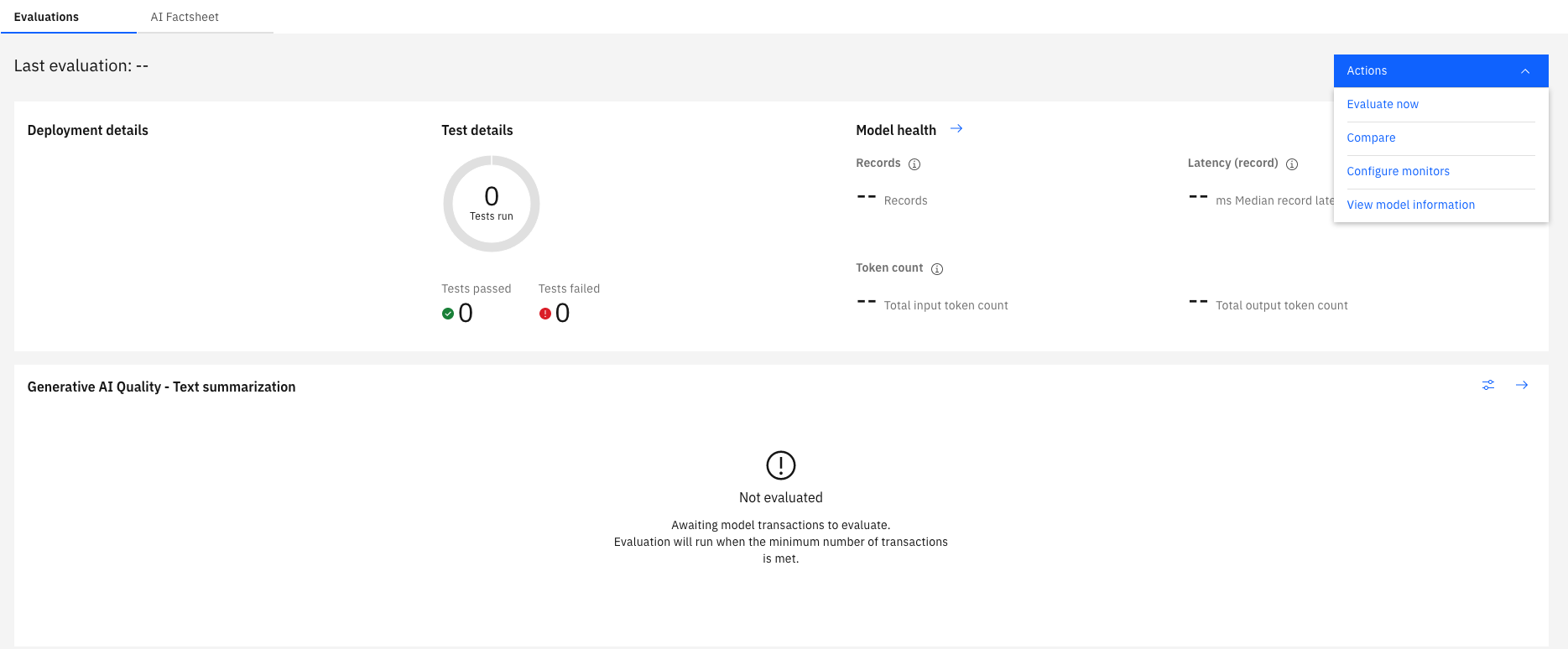

Le menu Actions fournit également les options suivantes pour vous aider à analyser vos résultats:

- Evaluer maintenant: Exécuter l'évaluation avec un autre jeu de données de test

- Toutes les évaluations: affichez un historique de vos évaluations pour comprendre comment vos résultats évoluent au fil du temps.

- Configurer les moniteurs: configurez les seuils d'évaluation et les tailles d'échantillon.

- Afficher les informations sur le modèle: affichez les détails de votre modèle pour comprendre comment votre environnement de déploiement est configuré.

Evaluation des déploiements détachés dans les espaces de production

Activer l'évaluation

Pour exécuter des évaluations de modèle d'invite, vous pouvez cliquer sur Activer dans l'onglet Evaluations lorsque vous ouvrez un déploiement pour ouvrir l'assistant Evaluer le modèle d'invite . Vous pouvez exécuter des évaluations uniquement si vous disposez des rôles Admin ou Editeur pour votre espace de déploiement.

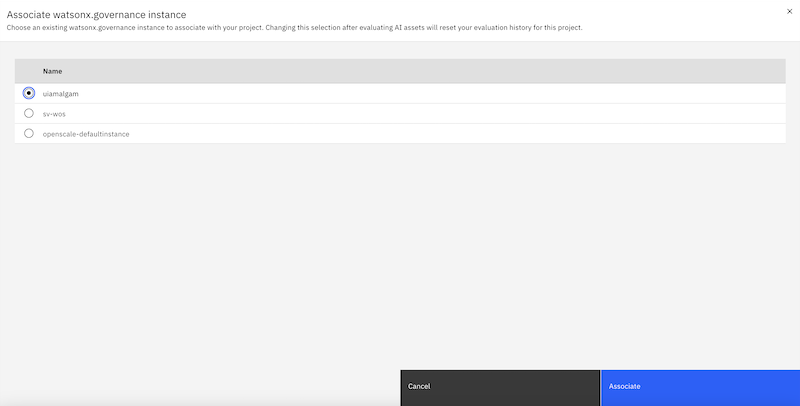

Si vous ne disposez pas d'une instance watsonx.governance associée à votre espace de déploiement, vous devez sélectionner Associer une instance de service dans la boîte de dialogue Associer une instance de service pour pouvoir exécuter des évaluations. Dans la fenêtre Associer une instance pour l'évaluation , vous devez choisir l'instance watsonx.governance que vous souhaitez utiliser et sélectionner Associer une instance de service pour associer une instance à votre espace de déploiement. Vous devez disposer du rôle Admin pour que votre espace de déploiement puisse associer des instances.

Si vous ne disposez pas d'une base de données associée à votre instance watsonx.governance , vous devez également associer une base de données pour pouvoir exécuter des évaluations. Pour associer une base de données, vous devez également cliquer sur Associer une base de données dans la boîte de dialogue Base de données requise pour vous connecter à une base de données. Vous devez disposer du rôle Admin pour votre espace de déploiement et l'instance watsonx.governance pour associer des bases de données.

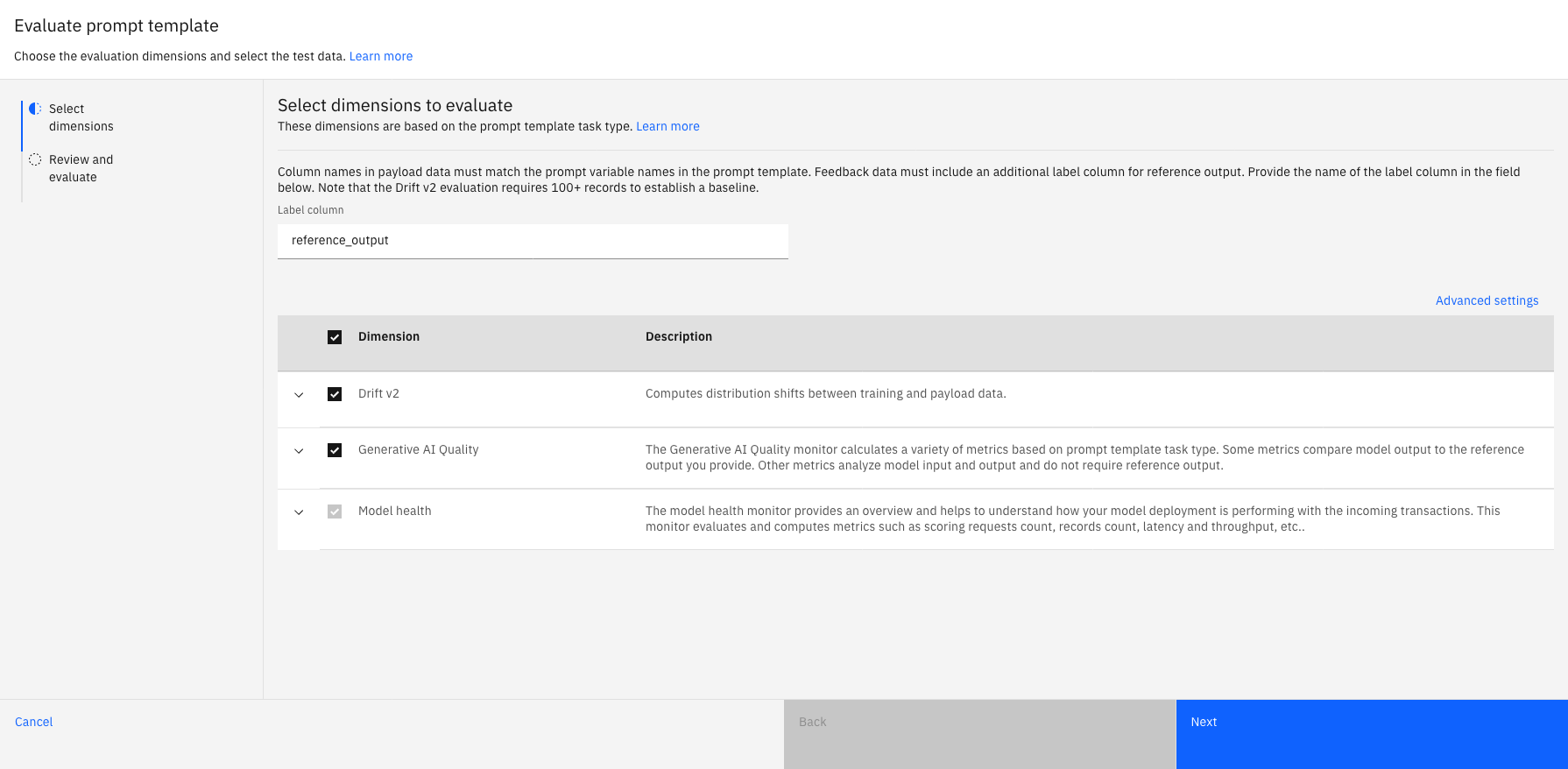

Sélectionner des dimensions

L'assistant Evaluer le modèle d'invite affiche les dimensions disponibles pour l'évaluation du type de tâche associé à votre invite. Vous pouvez indiquer un nom de colonne de libellé pour la sortie de référence que vous spécifiez dans vos données de retour. Vous pouvez également développer les dimensions pour afficher la liste des métriques utilisées pour évaluer les dimensions que vous sélectionnez.

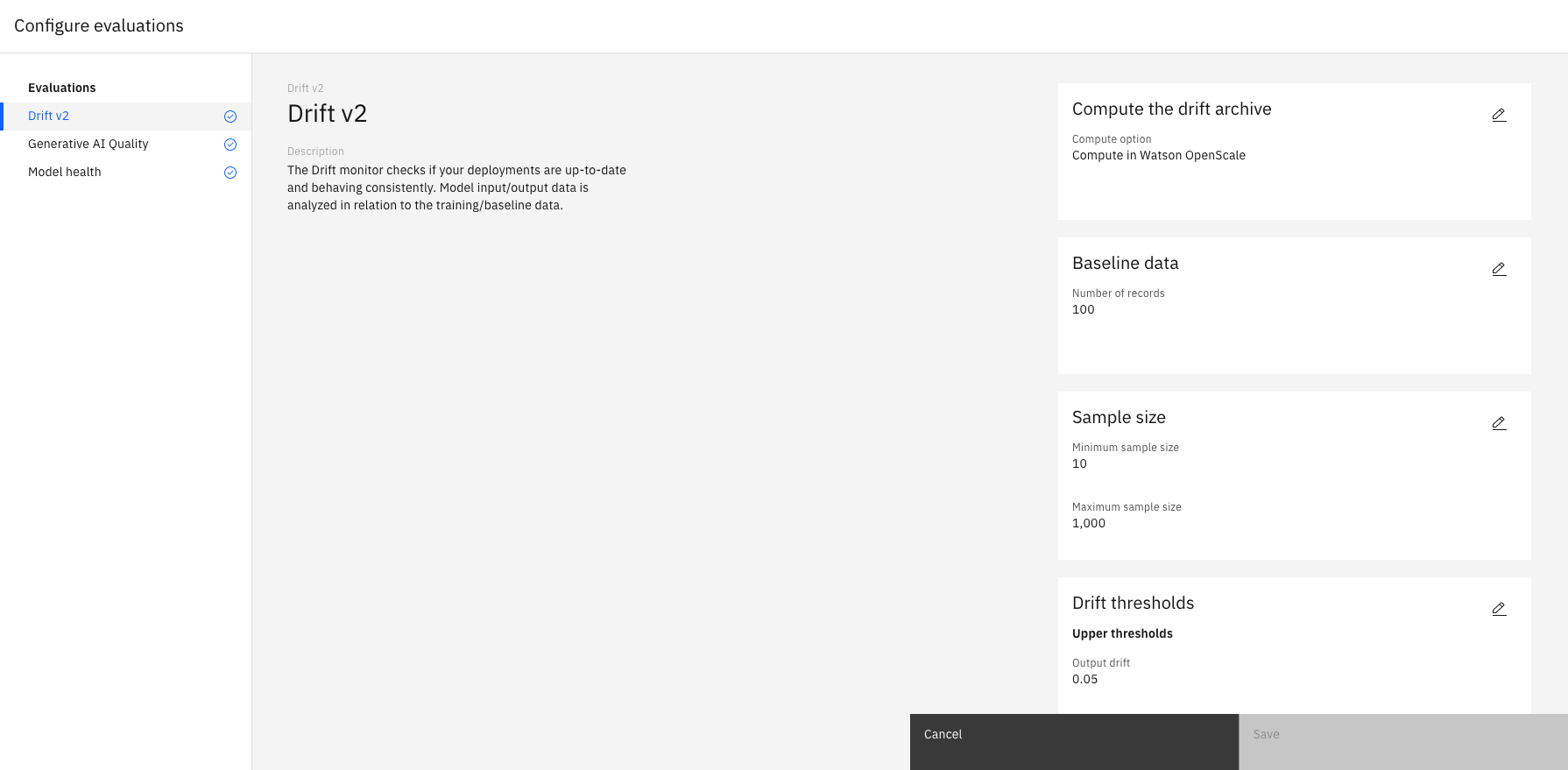

Watsonx.governance configure automatiquement les évaluations pour chaque dimension avec les paramètres par défaut. Pour configurer des évaluations avec des paramètres différents, vous pouvez sélectionner Paramètres avancés afin de définir des tailles d'échantillon et des valeurs de seuil minimales pour chaque métrique, comme illustré dans l'exemple suivant:

Réviser et évaluer

Vous pouvez passer en revue les sélections pour le type de tâche d'invite et le type d'évaluation qui s'exécute. Vous pouvez également sélectionner Afficher le schéma de contenu ou Afficher le schéma de commentaires en retour pour vérifier que les noms de colonne correspondent aux noms de variable d'invite dans le modèle d'invite. Vous devez sélectionner Activer pour exécuter l'évaluation.

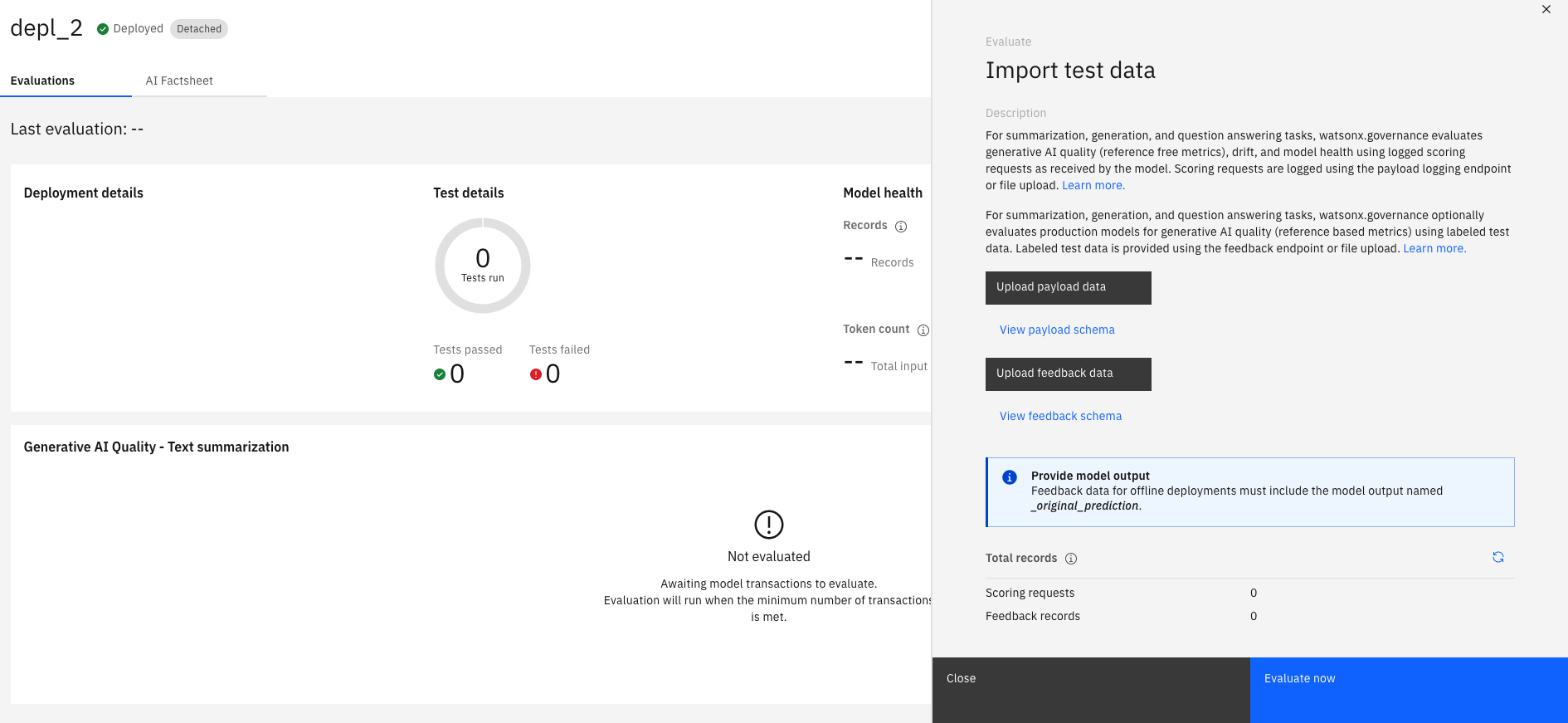

Pour générer des résultats d'évaluation, sélectionnez Evaluer maintenant dans le menu Actions pour ouvrir la fenêtre Importer les données de test lorsque la page récapitulative de l'évaluation s'affiche.

Importer des données de test

Dans la fenêtre Importer des données de test , vous pouvez sélectionner Télécharger des données de contenu ou Télécharger des données de retour pour télécharger un fichier CSV contenant des colonnes libellées qui correspondent aux colonnes de votre contenu et de vos schémas de retour.

Examen des résultats de l'évaluation

Une fois votre évaluation terminée, vous pouvez consulter un récapitulatif de vos résultats d'évaluation dans l'onglet Evaluations de watsonx.governance pour obtenir des informations sur les performances de votre modèle. Le récapitulatif fournit une vue d'ensemble des scores d'indicateur et des violations des seuils de score par défaut pour vos évaluations de modèle d'invite.

Pour analyser les résultats, vous pouvez cliquer sur la flèche  en regard de l'évaluation de votre modèle d'invite pour afficher les visualisations de données de vos résultats dans le temps. Vous pouvez également analyser les résultats de l'évaluation de la santé du modèle qui est exécutée par défaut lors des évaluations de modèle d'invite afin de comprendre l'efficacité avec laquelle votre modèle traite vos données.

en regard de l'évaluation de votre modèle d'invite pour afficher les visualisations de données de vos résultats dans le temps. Vous pouvez également analyser les résultats de l'évaluation de la santé du modèle qui est exécutée par défaut lors des évaluations de modèle d'invite afin de comprendre l'efficacité avec laquelle votre modèle traite vos données.

Le menu Actions fournit également les options suivantes pour vous aider à analyser vos résultats:

- Evaluer maintenant: Exécuter l'évaluation avec un autre jeu de données de test

- Configurer les moniteurs: configurez les seuils d'évaluation et les tailles d'échantillon.

- Afficher les informations sur le modèle: affichez les détails de votre modèle pour comprendre comment votre environnement de déploiement est configuré.

Si vous suivez le déploiement détaché dans un cas d'utilisation de l'IA, les détails du modèle et les résultats de l'évaluation sont enregistrés dans une fiche d'information que vous pouvez consulter.