IBM watsonx.aiとIBM watsonx.governanceonIBM Cloud の新機能とアップデートについては、毎週チェックしてください。

AWS 上のIBM watsonx.governanceについては、 AWS上IBM watsonx.governanceの新機能を/span>のを参照してください。

2025年1月31日までの1週間

新しいエージェントラボ(ベータ版)でAIエージェントを構築し、展開する

2025年1月30日

Agent Labのユーザーインターフェースを使用して、AIエージェントを構築し、デプロイすることで、アプリケーションをより柔軟かつ動的にすることができます。 エージェントのフレームワーク、 foundation model 、およびエージェントの設定で指定する外部ツールを使用して、エージェントに意思決定とタスクの実行を行わせるように設定できます。

詳しくは、 エージェントラボをご覧ください。

Agent Lab を使用してエージェンティックなAIアプリケーションを構築する場合( watsonx.ai )、アプリケーションはAIサービスとしてデプロイされます。 ユーザーインターフェースから直接ソリューションを展開するか、AIサービスを展開する Python で編集可能なノートブック形式でソリューションをエクスポートするかを選択できます。

詳細については、AIサービスの導入を参照してください。

強力な新しい Mistral Large 2 foundation model をオンデマンドで展開できます

2025年1月30日

mistral-large-instruct-2411 foundation model を Mistral AI から、貴社専用のハードウェアに導入し、貴社専用としてご利用ください。 この最新の foundation model は、 Mistral-Large-Instruct-2407 foundation model を改良し、長いプロンプト文脈のより良い処理、システムプロンプトの指示に従うこと、および関数呼び出しを追加しています。

Unlike other deploy on demand foundation models, there is an additional hourly fee for accessing the hosted the mistral-large-instruct-2411 foundation model. 価格の詳細については、 サポートされている基盤モデル をご覧ください。

Resource hubまたはREST APIからのオンデマンドでのfoundation modelのデプロイの詳細については、オンデマンドでの基盤モデルのデプロイを参照してください。

推論 ミスラル スモール 3 foundation model フランクフルト地域

2025年1月30日

Mistral AI からの mistral-small-24b-instruct-2501 foundation model は利用可能で、マルチテナントハードウェアでホスティングされており、すぐに使用できます。 Mistral Small 3 foundation model は、以下の機能により、チャットワークフローに最適です

- ネイティブ関数呼び出しとJSON出力生成機能を備えたエージェント機能。

- 最先端の会話機能と推論機能。

- システムプロンプトへの強い忠誠心と支持を維持する。

- 英語、フランス語、ドイツ語、スペイン語、イタリア語、中国語、日本語、韓国語、ポルトガル語、オランダ語、ポーランド語を含む数十言語に対応。

詳しくは、サポートされているファンデーションモデルをご覧ください。

DeepSeek-R1 で蒸留したモデルを展開および推論する watsonx.ai

2025年1月29日

DeepSeek-R1 の蒸留された派生バージョンである強力なオープンソース推論モデルを使用することで、 DeepSeek-R1 モデルを watsonx.ai で IBM Cloud に安全に展開および推論できるようになりました。これにより、開発者はAI搭載ソリューションの開発を加速することができます。 DeepSeek-R1 モデルは、 を使用してカスタム として展開できます。 watsonx.ai foundation model

詳細については、 カスタム基盤モデルの展開 をご覧ください。

Llama 3.3 70b 推論のための低価格 指示する foundation model

2025年1月29日

Meta から llama-3-3-70b-instruct foundation model を推論する価格は、1,000トークンあたり、 0.0018 ドルから 0.00071 ドルに値下げされました。 この価格変更は、 foundation model が利用可能なすべての地域に適用されます。

詳しくは、サポートされているファンデーションモデルをご覧ください。

2025年1月24日までの1週間

RAG実験における AutoAI の一般利用可能

2025年1月23日

AutoAI for RAG is now fully supported for automating the search for an optimized retrieval-augmented generation pattern for your applications. このアップデートには、以下の新機能が含まれています

- AutoAI のRAGをサンプルデータとガイド付きツアーで探索し、プロセスを学んでください。

- If you create an experiment using a Milvus vector store, you can now deploy a RAG pattern as an AI service so you can access the endpoint from a deployment space for inferencing.

詳細は、 AutoAIによる RAGパターンの自動化を参照。

AutoAI RAG実験の実施には、以下の請求が発生します

- 容量単位時間(CUH)は、実験の実行時間に対する課金単位です。

- リソースユニット(RU)は、実験実行中に発生した埋め込みおよび生成型AIモデル推論呼び出しすべてに対して課金されます。 1リソースユニット(RU)は1,000トークンに相当します。

プラン情報および請求の詳細については watsonx.ai ランタイムプランをご覧ください。

CPDCTLでAIサービスを展開

2024年1月23日

Cloud Pak for Data (CPDCTL)コマンドラインインターフェイスを使用して、AIサービスと連携した生成型AIソリューションをプログラムで展開できるようになりました。 CPDCTLは、 IBM Cloud Pak for Data (CPD)プラットフォーム上でAIサービスを展開および管理するためのコマンドラインツールです。 これは、AIサービスの展開をシンプルかつ合理的に行う方法を提供し、手動での設定を不要にし、エラー発生のリスクを低減します。

詳細は 、 Cloud Pak for Data コマンドラインインターフェイス(CPDCTL)を使用したAIサービスの展開を参照してください。

RAG用 AutoAI でAIサービスを展開

2024年1月23日

AutoAI を使用して RAG パターンを使用するジェネレーティブ AI ソリューションを作成する場合、 AutoAI の実験ビルダーから直接 AI サービスとしてソリューションをデプロイできるようになりました。 詳細は 、「ツールを使用したAIサービスの展開 」を参照してください。

CatBoost と LightGBM からONNX形式に変換したモデルをデプロイする

2024年1月23日

CatBoost と LightGBM をONNX形式に変換した機械学習モデルと生成型AIモデルを展開し、推論用エンドポイントを使用できるようになりました。 これらのモデルはダイナミック軸にも適応できる。 詳細については、 ONNX形式に変換されたモデルのデプロイを参照してください。

Deploy popular foundation models on demand in watsonx.ai

2025年1月22日

ダラスリージョンに専用ハードウェアを配置し、お客様の組織専用として以下の基盤モデルを展開できるようになりました

- llama-3-1-70b-instruct

- granite-7b-lab

これらのモデルに関する詳細情報(価格やサポートされるコンテキストウィンドウの長さなど)については、 オンデマンド基盤モデルを展開 をご覧ください。

Resource hubまたはREST APIからのオンデマンドでのfoundation modelのデプロイの詳細については、オンデマンドでの基盤モデルのデプロイを参照してください。

複数のラマ基盤モデルが、より多くの地域で利用可能になりました

2025年1月22日

The following foundation models from Meta are available in more regions:

- llama-3-3-70b-instruct: 東京とロンドンに加え、ダラスとフランクフルトでもご利用いただけるようになりました。

- llama-3-2-11b-vision-instruct: ダラス、東京、シドニーに加え、フランクフルトとロンドンでもご利用いただけるようになりました。

For more information about the regional availability of foundation models, see 地域ごとの利用可能状況 IBM Cloud.

The Llama 3.1 Instruct 70b and 8b foundation models are deprecated

2025年1月22日

The following foundation models from Meta are deprecated. これらの基礎モデルを使用しているプロンプトを修正する。

llama-3-1-70b-instruct

- 廃止日:2025年1月22日

- 償還期限:2025年5月30日

- 代替モデル: llama-3-3-70b-instruct または llama-3-2-90b-vision-instruct

llama-3-1-8b-instruct

- 廃止日:2025年1月22日

- 償還期限:2025年5月30日

- 代替モデル:llama-3-2-11b-vision-instruct

非推奨と脱退の詳細については、Foundationモデルのライフサイクルを参照してください。 代替モデルの詳細については、サポートされている財団モデルを参照のこと。

基盤モデルを継続して使用したい場合は、必要に応じてモデルを展開し、独占的に使用することができます。 詳細については、 オンデマンド基盤モデルを展開 をご覧ください。

2025年1月17日までの1週間

watsonx.ai で新しい IBM Granite 埋め込みモデルを使用する

2025年1月16日

IBM watsonx.ai: で提供する以下の Granite 埋め込みモデルが利用可能になりました

- granite-embedding-107m-multilingual

- granite-embedding-278m-multilingual

新しい埋め込みモデルを使用して、クエリ、文章、または文書形式の入力として、多言語の高品質なテキスト埋め込みを生成します。 詳細は 、「サポートされているエンコーダモデル 」および 「テキストのベクトル化 」を参照してください。

Graniteに変更が加えられました

2025年1月16日

IBM on watsonx.ai のダラスとシドニーのデータセンターで Granite 基盤モデルの最新バージョンを推論できるようになりました。

3.1では、128,000トークンコンテキストの長さをサポートし、 ハルシネーションや脱獄に関連するリスクのパフォーマンスを向上させるために、追加の合成データでトレーニングされています。 詳しくは、対応ファンデーションモデルをご覧ください。

granite-20b-multilingual codellama-34b-instruct-hf 基盤モデルは非推奨です

2025年1月15日

以下の基礎モデルは非推奨である。 これらの基礎モデルを使用しているプロンプトを修正する。

granite-20b-multilingual

- 廃止日:2025年1月15日

- 償還期限:2025年4月16日

- 代替モデル:granite-3-8b-instruct

codellama-34b-instruct-hf

- 廃止日:2025年1月15日

- 償還期限:2025年3月31日

- 代替モデル llama-3-3-70b-instruct

非推奨と脱退の詳細については、Foundationモデルのライフサイクルを参照してください。 代替モデルの詳細については、サポートされている財団モデルを参照のこと。

基盤モデルを展開するための新しいモデルアーキテクチャが利用可能

2024年1月15日

watsonx.ai:で、以下のアーキテクチャを持つカスタム基盤モデルを展開できるようになりました

exaonegemmagemma2granitemt5nemotronolmopersimmonphiphi3qwenqwen2

詳細については、 カスタム展開を計画中 foundation model をご覧ください。

AutoAI AG実験のベータ版は2025年1月23日に終了

2025年1月13日

ベータ版の終了後 AutoAI の実験を行うと、以下の通り課金が発生します

- 容量単位時間(CUH)は、実験の実行時間に対する課金単位です。

- リソースユニット(RU)は、基礎文書を埋め込み、生成型AIモデルを推論するために課金されます。 1リソースユニット(RU)は1,000トークンに相当します。

プラン情報および請求の詳細については watsonx.ai ランタイムプランをご覧ください。

2024年12月20日までの週

ONNX形式に変換されたモデルをデプロイする

2024年12月20日

ONNX形式に変換された機械学習や生成AIモデルを展開し、推論にエンドポイントを使用できるようになりました。 これらのモデルはダイナミック軸にも適応できる。 詳細については、 ONNX形式に変換されたモデルのデプロイを参照してください。

マルチソース SPSS Modeler フローの展開

2024年12月20日

モデルにデータを提供するために複数の入力ストリームを使用する SPSS Modeler フローの配置を作成できるようになりました。 詳細については、「 マルチソース SPSS Modeler フローの展開 」を参照してください。

2024年12月13日までの週

Granite 3 インストラクター・ファンデーション・モデルの変更点を紹介

2024年12月13日

以下の IBM ファンデーション・モデルに修正を加えた:

- granite-3-2b-instruct

- granite-3-8b-instruct

最新の修正により、 Granite 3.1の基盤モデルは、エージェントのタスクと固有機能のコーディングをより良くサポートするようになった。 これらの基礎モデルでサポートされるコンテキストウィンドウの長さは、4,096トークンから131,072トークンに増加した。 GraniteのモデルIDは変わらないが、モデルの重みは更新される。

詳しくは、サポートされているファンデーションモデルをご覧ください。

AutoAIで RAGパターンを検索するノーコード・ソリューション(ベータ版)

2024年12月12日

AutoAIのユーザーインターフェースから、ユースケースに最適なRAGパターンの検索を自動化できるようになりました。 文書コレクションとテスト問題をロードし、ベクトルデータベースを選択し、RAGパターンを見つけるための高速パスアプローチの実験を実行します。 また、実験のコンフィギュレーション設定を確認し、変更することもできます。 実験によって生成されたパターンを比較し、最良のパターンを自動生成ノートブックまたはプロジェクトに保存されたノートブックとして保存する。

詳細は、 AutoAIによる RAGパターンの自動化を参照。

テンプレートを使ってAIサービスを展開する

2024年12月12日

事前に定義されたテンプレートを使用して、AIサービスを展開することができます。 AIサービステンプレートは、AIモデルをデプロイするための定義済みの構造と構成を提供することで、AIサービスをデプロイする標準化された方法を提供する。 これらのテンプレートは、ジェネレーティブAIアプリケーションのプログラミング・ロジックをカプセル化した、あらかじめ構築された展開可能なコード単位である。

AIサービステンプレートは、デプロイメントの作成、メタデータの生成、エクステンションの構築などのタスクを自動化し、開発者がアプリケーションのコアロジックに集中できるようにする。 AIサービスを展開する柔軟な方法を提供し、複数の入力とカスタマイズをサポートする。

詳しくは、 テンプレートを使ったAIサービスのデプロイをご覧ください。

最新のLlama foundation modelをオンデマンドで導入可能

2024年12月12日

Meta Llama 3.3 70B Instruct多言語foundation modelを、組織専用の専用ハードウェアに導入することができます。 Meta 、最新のfoundation modelは、より大きな llama-3-405b-instruct モデルと同様の機能を持つが、サイズはより小さく、特にコーディング、ステップバイステップの推論、ツール呼び出しに長けている。 フルモデル llama-3-3-70b-instruct-hf ) か、ホストに必要なリソースが少ない量子化バージョン llama-3-3-70b-instruct ) をデプロイできます。

Resource hubまたはREST APIからのオンデマンドでのfoundation modelのデプロイの詳細については、オンデマンドでの基盤モデルのデプロイを参照してください。

Python クライアント・ライブラリによるオンデマンドでの基盤モデルのデプロイ

2024年12月12日

watsonx.ai Python クライアントライブラリを使用することで、ファンデーションモデルをオンデマンドでデプロイできるようになりました。 このアプローチを使用することで、大規模な計算リソースを必要とせずに、これらの強力な基礎モデルの機能にアクセスすることができます。 オンデマンドでデプロイされたFoundationモデルは、専用のデプロイメントスペースにホストされ、推論に使用することができます。

詳しくは、 基礎モデルをオンデマンドで展開するを参照してください。

SPSS Modeler チュートリアルの更新

11 2024年12月

最新の SPSS Modeler チュートリアルを 15回試して、 SPSS Modelerを実際に体験してください。

評価スタジオでAI資産を比較

2024年12月12日

評価スタジオを使用すると、使用ケースに合った定量的な指標とカスタマイズ可能な基準で、ジェネレーティブAI資産を評価および比較できます。 複数の資産のパフォーマンスを同時に評価し、結果の比較分析を見て、最適なソリューションを特定します。

詳しくは、 評価スタジオでAI資産を比較するをご覧ください。

ガバナンス・コンソールの強化

2024年12月12日

- watsonx.governanceモデルリスク・ガバナンス・ソリューションの強化

このリリースには以下の機能強化が含まれている:

- 新しいAI Model Onboarding Risk Identification質問表テンプレートは、モデルのオンボーディングプロセスで使用され、モデルに関連するリスクを特定するのに役立ちます。 このアンケートテンプレートは、ファウンデーションモデル・オンボーディングのワークフローで使用されます。

- 新しい「AIユースケースリスク特定」質問表テンプレートは、AIユースケースに関連するリスクを特定するために使用される。 このアンケートテンプレートは、ユースケースレビューのワークフローで使用されます。 この新しい質問表は、AIリスク識別質問表に代わるものである

- 新しい「AIユースケースとモデルのリスク特定」質問表テンプレートは、AIユースケースとモデルの組み合わせに関連するリスクを特定するのに役立つ。 このアンケートテンプレートは、ユースケースの開発と文書化のワークフローで使用されます。

- AIアセスメントワークフローがデフォルトで無効になりました。 このワークフローは、質問票評価ワークフローに置き換えられます。 ユースケースワークフローでアンケートテンプレートを直接設定できるようになりました。

- ワークフロー、ビュー、ダッシュボードが更新された。

詳細については、Governance コンソールのソリューション コンポーネントを参照してください。

- バグ修正とセキュリティ修正

バグフィックスとセキュリティフィックスが適用された。

詳しくは 9.0.0.5 5の新機能をご覧ください。

IBM watsonx.governanceはシドニー地域でご利用いただけます

2024 年 12 月 9 日

IBMの watsonx.governanceは現在、シドニーのデータセンターで一般的に利用できる。 ご登録の際、ご希望の地域にシドニーをお選びいただけます。

シドニー地域で利用可能な製品機能の詳細については、サービスおよび機能の地域別利用可能性をご覧ください。

2024年12月6日までの週

ファウンデーション・モデルをダラス地域にオンデマンドで展開

6 2024年12月

厳選された基盤モデルのコレクションから選択し、組織専用のハードウェアに導入することができます。 専用の配備は、基礎モデルを推論する際に、より応答性の高いインタラクションを意味する。 オンデマンド基盤モデルのデプロイは、時間単位で課金されます。 詳しくは、対応基盤モデルとジェネレーティブAIアセットの課金詳細をご覧ください。

Resource hubまたはREST APIからのオンデマンドでのfoundation modelのデプロイの詳細については、オンデマンドでの基盤モデルのデプロイを参照してください。

ダラスとフランクフルト地域における「Meta最新のラマfoundation modelの推論

6 2024年12月

Meta Llama 3.370Bインストラクター多言語foundation modelは、ダラスとフランクフルト地域で統合可能です。 llama-3-3-70b-instructの foundation modelは、コーディング、ステップバイステップの推論、ツール呼び出しに長けている。 405bモデルに匹敵する性能を持つLlama 3.3foundation model・アップデートは、開発者にとって素晴らしい選択です。 IBMからの 発表をご覧ください。

詳しくは、サポートされているファンデーションモデルをご覧ください。

財団モデルを比較するためにベンチマークを見直す

5 2024年12月

foundation modelのベンチマークを確認し、利用可能な基礎モデルの能力を試してから学ぶ。 あなたのユースケースにとって最も重要なタスクについて、様々な基盤モデルがどのように機能するかを比較する。 詳細は、財団モデルのベンチマークを参照。

Microsoft Excelファイルは、Decision OptimizationのOPLモデルでは非推奨です

5 2024年12月

Microsoft Excelワークブック(.xlsおよび.xlsx)ファイルは、Decision OptimizationOPLモデルでの直接入力および出力には使用されなくなりました。 Excelファイルに接続するには、代わりにデータ・コネクタを使用します。 データコネクターはExcelファイルを.csvファイルに変換します。 詳しくは参照データを参照。

ONNX形式に変換されたモデルを展開するための新しいサンプルノートブック

3 2024年12月

ONNX形式に変換された機械学習や生成AIモデルを展開し、推論にエンドポイントを使用できるようになりました。 これらのモデルはダイナミック軸にも適応できる。 以下のサンプルノートブックをご覧ください:

詳しくは、watsonx.aiランタイムPythonクライアントのサンプルと例をご覧ください。

llama-3-8b-instructとllama-3-70b-instructの基礎モデルは非推奨です

2024 年 12 月 2 日

以下の基礎モデルは非推奨である。 これらの基礎モデルを使用しているプロンプトを修正する。

llama-3-8b-instruct

- 償却開始日:2024年12月2日

- 脱退日:2025年2月3日

- 代替モデル:llama-3-1-8b-instruct,llama-3-2-11b-vision-instruct

llama-3-70b-instruct

- 償却開始日:2024年12月2日

- 払戻日:2025年2月3日(シドニーでは2025年3月31日)

- 代替モデル:llama-3-1-70b-instruct,llama-3-2-90b-vision-instruct

非推奨と脱退の詳細については、Foundationモデルのライフサイクルを参照してください。 代替モデルの詳細については、サポートされている財団モデルを参照のこと。

2024年11月29日までの週

Data Refineryの書き込みオプションに関するドキュメントの改善

2024年11月28日

データ・フローをエクスポートするための書き込みオプションとテーブル・オプションは、接続によって異なります。 これらのオプションについて説明するので、ターゲット・テーブルのオプションを選択する際の参考にしてほしい。 詳細については、 Data Refineryのターゲット接続オプションを参照してください。

2024年11月22日までの週

新しいwatsonxDeveloper Hub でコーディングを素早く開始

2024年10月21日

新しいデベロッパー・ハブで、ジェネレーティブAIソリューションのコーディングに必要なあらゆるものを見つけてください:

- 最初の API リクエストを行い、watsonx.ai のfoundation modelを推論します。

- AIアプリケーションに最適な基礎モデルとコードライブラリを見つける。

- watsonx.aiの機能を理解し、Curl、Node.js、またはPython でコード・スニペットをコピーする。

- ジェネレーティブAIのアプリケーションとソリューションの構築方法を、詳細なガイドで学びましょう。

- コミュニティに参加して、リソースや回答を見つけたり、他のユーザーと交流したりしましょう。

watsonxDeveloper Hub にアクセスしてください。

IBM watsonx.aiのコンポーネント・サービスの名称が変更された

2024年11月21日

以下のサービスが名称変更された:

- Watson Machine Learningはwatsonx.aiランタイムという名前になった

- Watson Studioはwatsonx.aiStudioという名前になった

ビデオ、ノートブック、コードサンプルの中には、これらのサービスを以前の名前で紹介し続けるものがあるかもしれない。

IBM watsonx.aiはシドニー地域で利用可能です

2024年11月21日

Watsonx.aiは現在、シドニーのデータセンターで一般的に利用可能で、サインアップ時にシドニーを希望地域として選択することができる。

シドニー地域で利用可能な基盤モデルおよび製品機能の詳細については、サービスおよび機能の地域別提供状況をご覧ください。

IBM Granite時系列基礎モデルとwatsonx.aiAPIを使用して将来の値を予測する(ベータ版)

2024年11月21日

時系列APIを使用して、ゼロショット推論で将来の値を予測できるIBM Granite時系列foundation modelモデルに、過去のデータ観測値を渡します。 watsonx.aiAPIの時系列予測メソッドは、ベータ機能として利用可能です。 詳細については、将来のデータ値の予測を参照。

Elasticsearchの推論 API からwatsonx.aiのテキスト埋め込みモデルを利用する

2024年11月21日

Elasticsearchバージョン8.16.0リリースでは、テキスト埋め込みタスクにwatsonx.ai foundation modelを使用する推論エンドポイントの作成がサポートされました。

詳しくはAPIを使ったテキストのベクトル化をご覧ください。

SPSS Modelerフローを展開スペースにプロモートする

2024年11月19日

プロジェクトをエクスポートしてから展開スペースにインポートしなくても、SPSS Modelerフローをプロジェクトから展開スペースに直接プロモートできるようになりました。 詳細については、 SPSS Modelerのフローとモデルのプロモートを参照してください。

2024年11月15日までの週

IBM「watsonx.aiデモチャットアプリは、アカウントをリンクすることで、トライアル制限なしで使用できます

2024年11月15日

IBM「watsonx.aiデモアカウントを「IBM Cloud watsonx.ai有料アカウントにリンクすることで、トークンの使用や時間制限なしにチャットアプリをご利用いただけます。 詳細については、 IBM watsonx.aiデモwatsonx.aiアカウントのリンクを/span>とを参照してください。

watsonx.ai Node.jsパッケージはLangChainから入手可能です

2024年11月11日

watsonx.ai Node.jsパッケージは、LangChain JavaScriptコミュニティ・ライブラリから利用可能です。 この統合は、基礎モデルの推論、テキスト埋め込み生成、画像からテキストへの変換やツール呼び出し機能を含むチャット交換の処理など、watsonx.aiの機能をサポートしている。 LangChainとの統合により、プロバイダー間の交換が容易になり、提供されるサービスを比較し、ニーズに最適なソリューションを見つけることができる一貫したインターフェイスを使用することで、これらのwatsonx.aiの機能を呼び出すことができます。

詳細については、Node.jsSDKを参照してください。

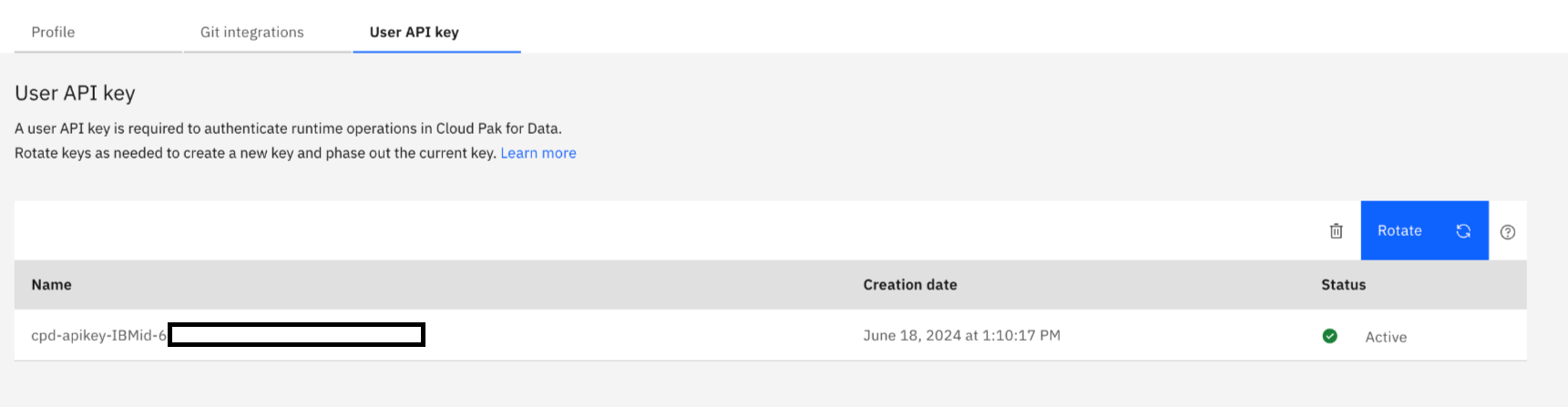

アセットを配置し、配置スペースからジョブを実行するには、タスク認証情報が必要になりました

2024年11月11日

配置ジョブを実行する際のセキュリティを向上させるため、配置スペースから 次のアセットを配置するには、タスクの資格情報を入力する必要があります:

- プロンプト・テンプレート

- AI サービス

- モデル

- Python 関数

- スクリプト

さらに、配置スペースから次の配置を作成するには、タスク資格情報を入力する必要があります:

- オンライン

- バッチ

また、配置スペースから配置ジョブを作成および管理するには、タスク資格情 報を使用する必要があります。

タスクのクレデンシャルを設定して API キーを生成する方法については、タスクのクレデンシャルを追加するを参照してください。

2024年11月8日までの週

AIサービスによる生成的AIアプリケーションの展開

7 2024年11月

watsonx.aiのAIサービスを使ってアプリケーションを展開できるようになりました。 AIサービスは、ジェネレーティブAIのユースケースのロジックをキャプチャするために使用できる、デプロイ可能なコード単位である。 Python関数は機械学習資産をデプロイする伝統的な方法だが、AIサービスはストリーミングのような生成的AIアプリケーションのコードをデプロイする、より柔軟なオプションを提供する。 AIサービスが正常にデプロイされたら、アプリケーションからの推論にエンドポイントを使用できます。

詳細については、AIサービスの導入を参照してください。

granite-13b-chat-v2、llama2-13b-dpo-v7、およびmt0-xxl-13bファンデーションモデルは非推奨です

4 2024年11月

- 以下の基礎モデルは非推奨である。 これらの基礎モデルを使用しているプロンプトを修正する。

granite-13b-chat-v2

- 償却開始日:2024年11月4日

- 脱退日:2025年2月3日

- 代替モデル:granite-3-8b-instruct

llama2-13b-dpo-v7

- 償却開始日:2024年11月4日

- 脱退日:2024年12月4日

- 代替モデル:llama-3-1-8b-instruct

mt0-xxl-13b

- 償却開始日:2024年11月4日

- 脱退日:2024年12月4日

- 代替モデル:llama-3-1-8b-instruct,llama-3-2-11b-vision-instruct

非推奨と脱退の詳細については、Foundationモデルのライフサイクルを参照してください。 代替モデルの詳細については、サポートされている財団モデルを参照のこと。

2024年11月1日までの週

watsonx.aiに新しいサードパーティ製all-minilm-l6-v2エンベッディング・モデルが追加されました

2024年10月29日

オープンソースの自然言語処理(NLP)およびコンピュータビジョン(CV)コミュニティによるall-minilm-l6-v2テキスト埋め込みモデルが、watsonx.aiAPIのテキスト埋め込みメソッドから利用できるようになりました。 このモデルを使用して、テキストをテキストマッチングや検索タスクで使用するのに適したテキスト埋め込みベクトルに変換する。 モデルの詳細については、以下のトピックを参照してください:

Mistral Large foundation modelの推論価格の引き下げ

2024年10月29日

Mistral Large foundation modelモデルに提出するインプットの価格は、1,000トークンあたり00.01米ドルから00.003米ドルに減少しました。 foundation modelによって生成されるアウトプットの価格は変更されず、アウトプットのトークンの価格は00.01 USD/1,000トークンのままです。 この価格変更は、mistral-large foundation modelが使用可能なすべての地域に適用される。

詳しくは、サポートされているファンデーションモデルをご覧ください。

IBMランタイム23.11の廃止について

2024年10月28日

IBMRuntime23.11は非推奨です。 2024年11月21日以降、23.1ランタイムを使用して新しいノートブックやカスタム環境を作成することはできません。 また、23.1ランタイムに基づくソフトウェア仕様で新しいデプロイメントを作成することはできません。 シームレスなエクスペリエンスを保証し、最新の機能と改善を活用するには、IBMRuntime24.11に切り替えてください。

- 環境の変更については、ノートブック環境の変更をご覧ください。

- デプロイメント・フレームワークについて詳しくは、『フレームワークおよびソフトウェア仕様の管理』を参照してください。

テキスト抽出APIで複雑なビジネス文書を簡素化

2024年10月28日

テキスト抽出メソッドは、watsonx.aiREST APIで一般的に利用できるようになった。 IBMが開発した文書理解テクノロジーを活用して、複雑なビジネス文書を簡素化し、生成的AIワークフローの一部として基礎モデルで処理できるようにします。 テキスト抽出APIは、画像、ダイアグラム、表などの文書構造からテキストを抽出する。 詳しくは、文書からテキストを抽出するを参照してください。

APIは、有料プランのユーザーであればすべての地域で利用できる。 料金の詳細については、ドキュメントテキスト抽出料金表をご覧ください。

2024年10月25日までの週

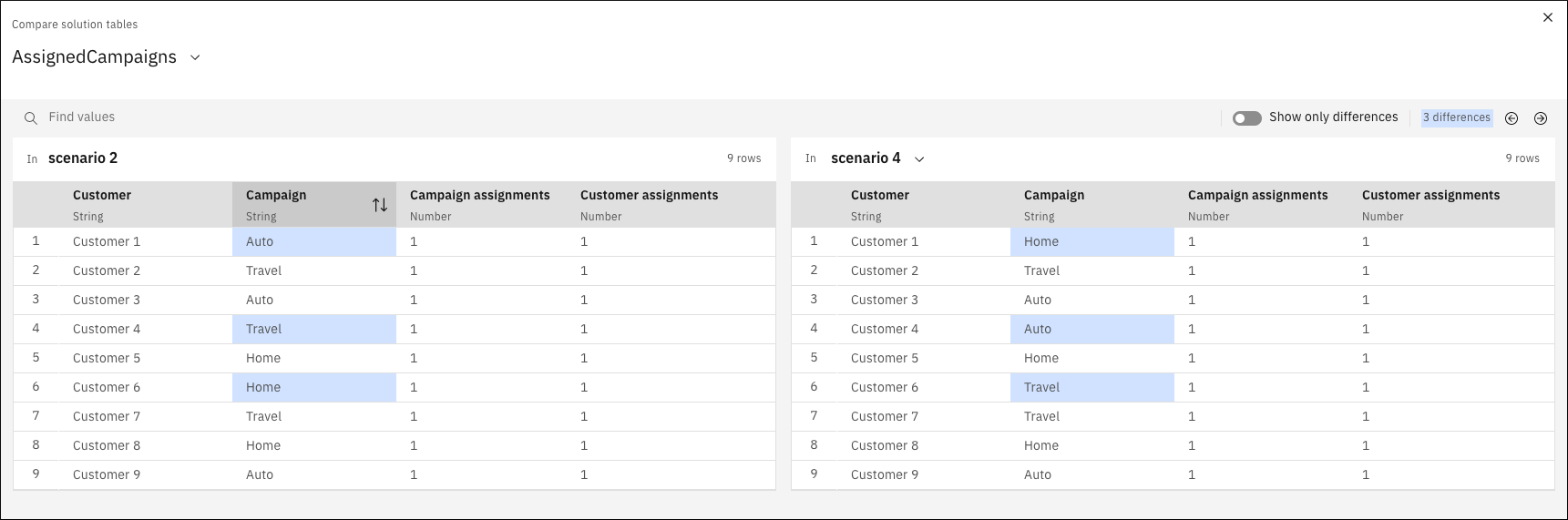

Decision Optimization実験のテーブルを比較して、シナリオ間の違いを見る

2024年10月23日

Prepare dataまたはExplore solutionビューのいずれかで、Decision Optimization実験のテーブルを比較できるようになりました。 この比較は、隣り合わせに表示されたシナリオ間のデータ値の違いを見るのに便利である。

詳細は 、「シナリオテーブルの比較」 を参照してください。

Granite 3.0の新モデルがwatsonx.aiに登場

2024年10月21日

watsonx.ai:から、IBMが提供する以下の3.0世代のGraniteFoundationモデルを推論できるようになった:

- GraniteInstructモデルを全地域で使用:要約、問題解決、テキスト翻訳、推論、コーディング、関数呼び出しタスクなどのタスクに、新しいインストラクトチューニングされた軽量でオープンソースの言語モデルを使用します。 以下のモデルバリエーションに対応:

- granite-3-2b-instruct

- granite-3-8b-instruct

- ダラス地域のGraniteガーディアンモデル:新しい「Graniteガーディアンモデルを使用してください。これは「Graniteインストラクターモデルを微調整したもので、プロンプトと応答におけるリスクを検出するように設計されています。 以下のモデルバリエーションに対応:

- granite-guardian-3-2b

- granite-guardian-3-8b

詳しくは、対応ファンデーションモデルをご覧ください。

テキスト再ランクAPIで検索タスクを強化

2024年10月21日

テキストの再ランクメソッドは、一般的にwatsonx.aiREST API で利用できる。 この新しいAPIメソッドを、新しくサポートされたms-marco-minilm-l-12-v2モデルのようなリランカー基礎モデルと一緒に使って、指定されたクエリに対する類似性に基づいて、一連の文書パッセージを並べ替える。 再ランク付けは、回答検索のワークフローに精度を追加する便利な方法です。 詳しくは、文書のパッセージの再ランク付けを参照のこと。

ピックストラルの新モデル12Bがフランクフルトとロンドン地区で販売開始

2024年10月21日

フランクフルトとロンドンのデータセンターにあるwatsonx.aiで、Mistral AIのPixtral12B foundation modelモデルを使用できるようになりました。

Pixtral12Bは、画像とテキストをインターリーブしたデータで学習された、画像からテキスト、テキストからテキストという機能を持つネイティブのマルチモーダルモデルです。 foundation modelは、可変の画像サイズをサポートし、指示に従う作業を得意とする。 詳しくは、対応ファンデーションモデルをご覧ください。

2024年10月18日までの週

アカウント・リソース・スコープはデフォルトで有効

2024年10月17日

アカウントの'Resource scope設定は、デフォルトで'ONに設定されています。 ただし、以前にリソーススコープの設定値を「ONまたは「OFFいずれかに設定した場合は、現在の設定は変更されない。

リソース・スコープが有効な場合、現在選択されているIBM Cloudアカウントにないプロジェクトにはアクセスできません。 複数のIBM Cloudアカウントに所属している場合、すべてのプロジェクトが一緒に表示されないことがあります。 例えば、「すべてのプロジェクト」ページにすべてのプロジェクトが表示されないことがあります。 他のアカウントのプロジェクトを見るには、アカウントを切り替える必要があります。

フランクフルト地域ではGraniteの foundation modelが利用可能

2024年10月15日

IBMの granite-20b-code-instruct foundation modelは、コーディング関連の指示に対応するように設計されている。 フランクフルトのデータセンターでホスティングされているプロジェクトでは、コーディング作業やコーディングアシスタントの構築に役立つfoundation modelを使用できます。 モデルの詳細については、サポートされる財団モデルを参照のこと。

2024年10月11日までの週

新しいライセンス特典

2024年10月10日

IBM watsonx.aiとIBM watsonx.governance にオンプレミス・ライセンスのメリットを適用するために、BYOL (Bring Your Own License) が可能になりました。

詳細については、 SaaSへのBYOL(Bring Your Own License)のアクティベーションを参照してください。

SPSS ModelerのText Analyticsで日本語テキストデータを分析する

9 2024年10月

テキストリンク分析ノードやテキストマイニングノードなど、SPSS Modelerのテキスト分析ノードを使用して、日本語で書かれたテキストデータを分析できるようになりました。

watsonx.aiチャット API で会話型ワークフローを構築する

2024年10月8日

watsonx.aiチャット API を使用して、サードパーティのツールやサービスへのエージェント主導の呼び出しを含むジェネレーティブ AI 機能をアプリケーションに追加します。

詳しくは、以下のトピックを参照してください。

カスタム・ファンデーション・モデルのための新しいソフトウェア仕様

2024年10月7日

foundation modelのデプロイメントで、新しいソフトウェア仕様「watsonx-cfm-caikit-1.1」を使用できるようになりました。 この仕様はvLLMライブラリに基づいており、最新のデコーダのみの大規模言語モデルに適している。 vLLMライブラリの詳細については、「vLLM」を参照してください。カスタム・foundation modelでの仕様の使用については、「カスタム・foundation modelの展開計画」を参照してください。

granite-7b-labおよびllama3-llava-next-8b-hf基盤モデルは非推奨です

2024年10月7日

granite-7b-lab foundation modelは非推奨であり、2025年1月7日に廃止されます。 このfoundation modelを使用しているすべてのプロンプトを修正する。

- 償却開始日:2024年10月7日

- 脱退日:2025年1月7日

- 代替モデル:granite-3-8b-instruct

llama3-llava-next-8b-hfマルチモーダルfoundation modelも非推奨であり、2024年11月7日に廃止される。 新しくリリースされたLlama 3.2ビジョンモデルのいずれかを、画像からテキストへの生成タスクに使用できるようになりました。

- 償却開始日:2024年10月7日

- 脱退日:2024年11月7日

- 代替モデル:llama-3-2-11b-vision-instruct

非推奨と脱退の詳細については、Foundationモデルのライフサイクルを参照してください。 代替モデルの詳細については、サポートされている財団モデルを参照のこと。

2024年10月4日までの週

環境とソフトウェア仕様の更新

3 2024年10月

IBMRuntime23.11に含まれるTensorflowと Kerasのライブラリーが新しいバージョンに更新されました。 これは、ノートブックでのコードの実行方法に影響を与えるかもしれない。 詳細は、watsonx.aiStudio(旧Watson Studio)ランタイムに含まれるライブラリ・パッケージを参照。

ランタイム23.11は、今年後半にIBMランタイム24.11に取って代わられる予定だ。 度重なる混乱を避けるため、今すぐIBMRuntime24.11に切り替え、デプロイメントには関連するソフトウェア仕様を使用することをお勧めします。

- 環境の変更については、ノートブック環境の変更をご覧ください。

- デプロイメント・フレームワークについて詳しくは、『フレームワークおよびソフトウェア仕様の管理』を参照してください。

フランクフルト地域におけるwatsonx.governanceプランの提供とOpenScaleレガシープランの廃止

3 2024年10月

フランクフルト地域でWatson OpenScaleをプロビジョニングするためのwatsonx.governanceレガシー・プランは廃止されます。 IBM Watson OpenScaleは、新規サブスクリプションや新規インスタンスのプロビジョニングができなくなります。 OpenScaleの機能については、watsonx.governanceEssentialsプランにご加入ください。

- プランの詳細は、watsonx.governanceplansをご覧ください。

- まずは、 watsonx.governanceのセットアップをご覧ください。

注記:

- 既存のレガシープランのインスタンスは、サポート終了日(未定)まで引き続き運用され、サポートされます。

- IBM Watson OpenScaleの既存のお客様は、引き続きIBM Watson OpenScaleを使用してサポート・チケットを開くことができます。

2024年9月27日までの週

マルチモーダル11Bおよび90Bモデルを含むLlama 3.2ファンデーションモデルが利用可能

2024年9月25日

本日のリリースにより、MetaAIの以下のファウンデーションモデルがダラス地域から利用可能となる:

- Llama 3.2指導モデル

- 大きな入力(128,000トークンのコンテキストウィンドウ長)をサポートし、1Bと 3Bのパラメータサイズでモバイルデバイスに収まるほど軽量で効率的な、汎用性の高い大規模言語モデル。 これらのモデルを使用して、高度にパーソナライズされたオンデバイス・エージェントを構築することができます。

- Llama 3.2ビジョンモデル

- 文書レベルの理解、図表の解釈、画像のキャプション付けなど、画像イン、テキストアウトのユースケースのために構築された、微調整されたモデル。

- ラマガードビジョンモデル

- 有害なコンテンツをフィルタリングするために設計された強力なガードレールモデル。

詳しくは、サポートされているファンデーションモデルをご覧ください。

ガバナンス・コンソールの強化

2024年9月25日

このリリースには機能強化とバグ修正が含まれています。

- ダッシュボードのカスタムタブ

ダッシュボードにカスタムタブを3つまで表示できるようになりました。

- 積み重ね棒グラフ

ダッシュボードおよびビュー デザイナーで積み上げ棒グラフを設定できるようになりました。

- アンケート回答者の回答に基づいてフィールド値を設定する式の使用

フィールドの値に式を入力できるようになった。 For example, you can enter

[$TODAY$]for the current date,[$END_USER$]for the name of the signed on user, or[$System Fields:Description$]to set the field to the value of the Description field of the object.- watsonx.governanceモデルリスク・ガバナンス・ソリューションの強化

このリリースには以下の機能強化が含まれている:

- 新しいモデルグループオブジェクトタイプは、類似したモデルをグループ化する方法を提供します。 例えば、ビジネス上の問題を解決するために同じようなアプローチを使用するモデルのバージョンは、モデルグループに属するかもしれません。

- 新しいユースケース・リスク・スコアリングの計算では、ユースケースの基本的なモデルがどのように機能しているかを全体的に把握するために、違反ステータスごとのメトリクスをリスク・スコアに集約します。

- 新しいDiscovered AIライブラリ・ビジネス・エンティティは、組織内で公認されたガバナンス・プラクティスに従っていないAI(「シャドーAI」とも呼ばれる)のデプロイメントを保存するデフォルトの場所を提供する。

- ワークフロー、ビュー、ダッシュボードが更新された。

詳細については、Governance コンソールのソリューション コンポーネントを参照してください。

- バグ修正とセキュリティ修正

バグフィックスとセキュリティフィックスが適用された。

詳しくは 9.0.0.44の新機能をご覧ください。

AutoAISDK(ベータ版)でRAGパターンを自動化する

2024年9月23日

AutoAI PythonSDKを使用して、データとユースケースに基づいて最適化されたRAG(Retrieval-augmented Generation)パターンの設計と展開を自動化し、高速化します。 RAGには、どの大規模言語モデルを選択するか、接地文書をどのようにチャンクするか、どれだけの文書を検索するかなど、多くの設定パラメータが用意されている。 AutoAIは、制約のある設定オプションの完全な探索と評価を自動化し、最適化メトリックに対する性能でランク付けされたパターンパイプラインのセットを生成します。

機能の詳細とAutoAIRAG実験のコーディングに関する使用上の注意については、「 AutoAISDK(ベータ版)によるRAGパターンの自動化」を参照してください。

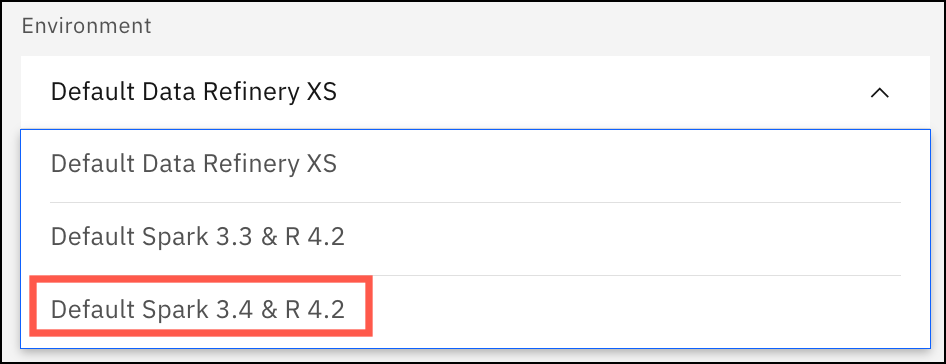

Spark3.3ランタイムの削除

2024年9月23日

IBM Analytics EngineのSpark3.3ランタイムのサポートは2024年10月29日までに終了し、デフォルトのバージョンはSpark3.4ランタイムに変更されます。 シームレスなエクスペリエンスを保証し、最新の機能と改善を活用するには、Spark3.44に切り替えてください。

2024年10月29日以降、Spark3.3のランタイムを使用してノートブックやカスタム環境を作成、実行することはできません。 また、Spark3.3ランタイムに基づくソフトウェア仕様でデプロイメントを作成または実行することはできません。

- インスタンスをSpark3.44にアップグレードするには、インスタンスのデフォルトランタイムの置き換えを参照してください。

- 利用可能なノートブック環境の詳細については、ノートブックの環境を変更するを参照してください。

- デプロイメント・フレームワークについて詳しくは、『フレームワークおよびソフトウェア仕様の管理』を参照してください。

2024年9月20日までの週

Prompt Labのマルチモーダルfoundation modelの推論

2024年9月19日

Prompt Labで画像を追加し、チャットモードでマルチモーダルfoundation modelをプロンプトして画像についてチャットできるようになりました。 ドキュメントのグラウンディングに加えて、画像をアップロードし、画像のビジュアルコンテンツについて、画像からテキストへのタスクをサポートするfoundation modelモデルに質問できるようになりました。 詳しくは、文書や画像を使ったチャットをご覧ください。

新モデルllama3-llava-next-8b-hfがダラス地区で販売開始

2024年9月19日

IBM watsonx.aiの新しいllama3-llava-next-8b-hfマルチモーダルfoundation modelを使用して、画像からテキストへのタスクを支援できるようになりました。

Large Language and Vision AssistantLLaVa)は、マルチモーダル・チャットボットのユースケースのために、事前学習された大規模言語モデルと事前学習された視覚エンコーダを組み合わせたものです。 LLaVA NeXT Llama3は、より多様で高品質な画像およびテキストデータで学習されます。 詳しくは、対応ファンデーションモデルをご覧ください。

watsonx.ai Node.jsSDKを使ってジェネレーティブAIアプリケーションをコーディングする

2024年9月18日

watsonx.ai Node.jsパッケージを使用して、IBM watsonx as a Serviceの基礎モデルをプログラムで推論し、調整します。 詳細については、Node.jsSDKを参照してください。

財団モデルの知的財産補償方針を理解する

2024年9月18日

IBMの知的財産補償ポリシーをよりよく理解し、watsonx.ai でどの基盤モデルに知的財産補償が適用されているかを確認できるようになりました。 詳しくは、モデルタイプと知財補償を参照のこと。

2024年9月13日までの週

配置スペースでSPSS Modelerフロー用のバッチジョブを作成する

2024年9月10日

展開スペースでSPSS Modelerフローのバッチジョブを作成できるようになりました。 フローでは、フローからバッチジョブを作成するたびに、実行するターミナルノードを柔軟に決定できます。 フローにバッチジョブをスケジュールすると、バッチジョブはフローで指定したデータソースと出力ターゲットを使用します。 これらのデータ ソースとデータ出力のマッピングは、データ ソースとデータ ターゲットが配置スペースにもあれば自動的に行われます。 フローからバッチジョブを作成する方法の詳細については、 SPSS Modelerフローの展開ジョブを作成するを参照してください。

展開スペースのフローとモデルの詳細については、「 SPSS Modelerのフローとモデルを展開する」を参照してください。

2024年9月6日までの週

ダラス地域のwatsonx.aiから推論に独自のfoundation modelを持ち込む

3 2024年9月

IBMが監修した基盤モデルで作業するだけでなく、独自の基盤モデルをアップロードしてデプロイすることもできるようになりました。 モデルが配備され、watsonx.ai に登録されたら、カスタムモデルを推論するプロンプトをプログラムまたはPrompt Labから作成します。 この機能はダラス地区でのみ利用可能。

カスタム基盤モデルのアップロードの詳細については、カスタム基盤モデルのデプロイを参照してください。 カスタム・ファンデーション・モデルのプラン情報と請求の詳細については、watsonx.aiRuntime プランをご覧ください。

文書テキスト抽出APIで複雑なビジネス文書を簡素化

3 2024年9月

IBMが開発した文書理解テクノロジーを適用して、複雑なビジネス文書を簡素化し、生成的AIワークフローの一部として基礎モデルで処理できるようにします。 文書テキスト抽出APIは、画像、ダイアグラム、表などの文書構造からテキストを抽出する。 watsonx.aiREST APIのテキスト抽出方法はベータ機能です。

詳しくは、文書からテキストを抽出するを参照してください。

Granite foundation modelの修正とアップデートが可能

3 2024年9月

granite-20b-code-instruct foundation modelをバージョン1.1.0に修正。 最新の改良版は、コードと自然言語ドメインからの高品質なデータを混合して学習させ、モデルの推論能力と命令追従能力を向上させている。

以下の基礎モデルが更新され、プロンプトでサポートされるコンテキストウィンドウの長さ(入力+出力)のサイズが8192から128000に増加した:

- granite-3b-code-instruct

- granite-8b-code-instruct

詳しくは、サポートされているファンデーションモデルをご覧ください。

2024年8月30日までの週

llama-2-13b-chatとllama-2-70b-chatは非推奨です

2024年8月26日

llama-2-13b-chatと llama-2-70b-chatのファンデーションモデルは非推奨であり、2024年9月25日に廃止されます。 これらの基礎モデルを使用しているプロンプトを修正する。

- llama-2-13b-chat

- 廃止日:2024年8月26日

- 脱退日:2024年9月25日

- 代替モデル:llama-3.1-8b-instruct

- llama-2-70b-chat

- 廃止日:2024年8月26日

- 脱退日:2024年9月25日

- 代替モデル:llama-3.1-70b-instruct

APIを使ってllama-2-13b-chatと llama-2-70b-chatモデルに送信された推論リクエストは、出力を生成し続けますが、近々モデルが取り下げられるという警告メッセージが含まれます。 2024年9月25日以降、モデルを推論するためのAPIリクエストは出力を生成しません。

非推奨と脱退の詳細については、Foundationモデルのライフサイクルを参照してください。

2024年8月23日までの週

プロジェクトやスペースの共同作業者としてユーザーグループを追加する

2024年8月22日

IBM Cloudアカウントに IAM アクセス・グループが含まれている場合、プロジェクトとスペースにユーザー・グループを追加できるようになりました。 IBM Cloudアカウント管理者は、アクセス・グループを作成することができます。 詳細については、「IAMアクセス・グループの操作」を参照してください。

AutoAI時系列実験のための異常予測機能のサポート終了

2024年8月19日

AutoAIの時系列モデル予測における異常値(外れ値)を予測する機能(現在ベータ版)は非推奨となり、2024年9月23日に削除される予定です。 標準的なAutoAIの時系列実験は、現在も完全にサポートされている。 詳細は時系列実験の構築を参照。

2024年8月16日までの週

IBMのスレート埋め込み型新モデルが全地域で利用可能に

2024年8月15日

IBMSlateエンベッディング・モデルは、クエリー、パッセージ、ドキュメントなどのさまざまな入力に対してエンベッディングを生成する機能を企業に提供します。 新モデルのslate-125m-english-rtrvr-v22とslate-30m-english-rtrvr-v22は、v1モデルよりも大幅に改善されている。 現在、slate-125m-english-rtrvrおよびslate-30m-english-rtrvrモデルをご使用の場合は、新しいv2Slateモデルに切り替えて、モデルの改良をご利用ください。

詳しくは、対応エンコーダ基盤モデルをご覧ください。

Prompt Labで、ユーザー入力とfoundation model出力のAIガードレールを別々に設定する

2024年8月15日

Prompt Labで foundation modelのプロンプトを試す際に、有害なコンテンツを発見して削除するAIのガードレールの感度を調整します。 ユーザー入力とモデル出力のテキストに対して異なるフィルター感度レベルを設定でき、効果的なAIガードレール設定をプロンプトテンプレートに保存できる。

詳しくは、有害コンテンツの削除をご覧ください。

2024年8月9日までの週

プロンプト・テンプレート評価のためにプロジェクトからテスト・データを選択する

2024年8月8日

プロジェクトでプロンプトテンプレートを評価する際に、プロジェクトアセットを選択して評価用のテストデータを選択できるようになりました。 詳細については、「プロジェクトでのプロンプトテンプレートの評価」を参照してください。

新しいllama-3-1-70b-instructモデルがIBM watsonx.aiで利用可能になりました

2024年8月7日

You can now use the latest Llama 3.1 foundation models from Meta in the 70 billion parameter size on IBM watsonx.ai.

Llama 3.1シリーズの基礎モデルは、トップクラスの推論機能を備えた高性能な大規模言語モデルです。 このモデルは、テキスト理解、変換、コード生成などの複雑な多言語推論タスクに使用できる。 英語、ドイツ語、フランス語、イタリア語、ポルトガル語、ヒンディー語、スペイン語、タイ語に対応している。 詳しくは、対応ファンデーションモデルをご覧ください。

RAGアクセラレーターとのQ&Aを更新

6 2024年8月

Q&A with RAG accelerator1.2サンプル・プロジェクトには、以下の改良が含まれています:

検索支援型ジェネレーション(RAG)実装の次の段階である、ユーザーフィードバックの収集と回答品質の分析にお役立てください。 人気のあるトピックを表示する教師なしトピック検出による分析、トピック別に生成された回答に対するユーザーの満足度、トピック別の検索スコアを含む。

New prompt templates that are optimized for the IBM granite-7b-lab and Meta Llama 3.1 foundation models.

watsonx.ai PythonライブラリのRAGユーティリティと、製品、エリアなどで検索するターゲットベクター検索フィルターを使用する合理化されたコード。

2024年8月2日までの週

新しいllama-3-1-8b-instructモデルがIBM watsonx.aiで利用可能になりました

1 2024年8月

You can now use the latest Llama 3.1 foundation models from Meta in the 8 billion parameter size on IBM watsonx.ai.

Llama 3.1シリーズの基礎モデルは、トップクラスの推論機能を備えた高性能な大規模言語モデルです。 このモデルは、テキスト理解、変換、コード生成などの複雑な多言語推論タスクに使用できる。 英語、ドイツ語、フランス語、イタリア語、ポルトガル語、ヒンディー語、スペイン語、タイ語に対応している。 詳しくは、対応ファンデーションモデルをご覧ください。

ワークスペースとAIのユースケースを関連付ける

1 2024年8月

AIユースケースの作成フローは、AIのライフサイクルとより密接に連携するように変更されている。 AIのユースケースの要点を定義したら、ワークスペースを関連付け、AIソリューションのフェーズに合わせて資産を整理する。 例えば、開発または検証フェーズのアセットにはプロジェクトまたはスペースを関連付け、運用フェーズのアセットにはスペースを関連付ける。

詳細は、ワークスペースとAIユースケースの関連付けを参照。

2024年7月26日までの週

ランタイム24.1における Python 3.11およびR4.3フレームワークとソフトウェア仕様のサポートを発表

2024年7月25日

Python 3.11とR4.33に基づく最新のデータサイエンス・フレームワークを含むIBMRuntime24.11を使用して、JupyterノートブックとRスクリプトを実行し、モデルをトレーニングできるようになりました。 7月29日からは、デプロイメントを実行することもできる。 IBMRuntime24.1フレームワークとソフトウェア仕様を使用するように、アセットとデプロイメントを更新してください。

- IBMRuntime24.1リリースと、Python 3.10およびR4.2用の付属環境については、ノートブック環境を参照してください。

- デプロイメント・フレームワークについて詳しくは、『フレームワークおよびソフトウェア仕様の管理』を参照してください。

Jupyter Notebookエディターの拡張版が利用可能に

2024年7月25日

Runtime24.1ベースの環境でノートブックを実行している場合、これらの機能拡張を使ってコードを操作することができます:

- コードを自動的にデバッグ

- ノートブックの目次を自動生成する

- コードの横の行番号を切り替える

- セルの内容を折りたたみ、コードと出力を並べて表示することで、生産性を向上

詳細はJupyterノートブックエディタを参照。

Runtime24.11でサポートされるNatural Language Processorトランスフォーマ埋め込みモデル

2024年7月25日

新しいRuntime24.1環境では、自然言語処理(NLP)変換埋め込みモデルを使用して、文章や一節の意味を捕捉するテキスト埋め込みを作成し、検索を補助する生成タスクに役立てることができるようになりました。 詳細はエンベッディングを参照。

Runtime24.1では、新しい特殊なNLPモデルが利用可能です

2024年7月25日

Runtime24.1環境には、新たに以下の特殊なNLPモデルが追加されました:

- テキストコンテンツに含まれる憎悪的、罵倒的、または冒涜的なコンテンツ(HAP)を検出・識別できるモデル。 詳細はHAP検出を参照。

- 金融、サイバーセキュリティ、生物医学に関連するトピックに対応できる3つの事前学習済みモデル。 詳細については、カスタム分類モデルによるテキストの分類を参照してください。

キーポイント要約を使用して、大量のテキストから詳細な洞察を引き出す

2024年7月25日

ノートブックでKey Point Summarizationを使用すると、人々の意見を表す大量のテキスト(製品レビュー、アンケート回答、ソーシャルメディア上のコメントなど)から、詳細で実用的な洞察を抽出できるようになりました。 その結果は、処理しやすい組織的で階層的な方法で提供される。 詳しくは、キーポイント要約をご覧ください

RStudioバージョン更新

2024年7月25日

プライベート・クラウドとパブリック・クラウドで一貫したユーザー・エクスペリエンスを提供するため、IBM watsonx用RStudioIDE は、2024 年 7 月 29 日にRStudioServer2024.04.1および R4.3.1に更新されます。 RStudioの新バージョンでは、多くの機能強化やセキュリティ修正が行われています。 詳細は、RStudioServer2024.04.1リリースノートを参照してください。 大きな互換性の問題は予想されないが、ユーザーは以下の表に記載されているいくつかのパッケージのバージョン変更に注意する必要がある。

アップグレード後にプロジェクトからRStudioIDE を起動する場合は、RStudioワークスペースをリセットして、R4.3.1パッケージのライブラリパスがRStudioServer によってピックアップされるようにします。

ダラス、フランクフルト、ロンドンのIBM watsonx.aiで Mistral Largeモデルの新バージョンが利用可能になりました

2024年7月24日

現在、ダラス、フランクフルト、ロンドンのデータセンターで、IBM watsonx.ai上のMistral AIからMistral Large 2 foundation modelを使用することができます。

Mistral Large 2モデルは11の言語をサポートし、テキスト理解、コード生成、高度な推論に精通しています。 詳しくは、対応ファンデーションモデルをご覧ください。

新モデルllama-3-405b-instructがダラス地区で販売開始

2024年7月23日

ダラスデータセンターの IBM watsonx.ai で、 Meta から llama-3-405b-instruct foundation model を使用できるようになりました。

llama-3-405B-instructv3.1)モデルは、トップクラスの推論機能を備えた高性能な大規模言語モデルを企業に提供し、これまでにリリースされたオープンソースモデルとしては最大規模です。 このfoundation modelは、テキスト理解、変換、コード生成などの複雑な多言語推論タスクに使用できる。 詳しくは、対応ファンデーションモデルをご覧ください。

merlinite-7bモデルは非推奨

2024年7月22日

merlinite-7b foundation modelは非推奨であり、2024年8月22日に廃止される。 このfoundation modelを使用しているすべてのプロンプトを修正する。

- 廃止日:2024年7月22日

- 脱退日:2024年8月22日

- 代替モデル:mixtral-8x7b-instruct-v01

APIを使用してmerlinite-7bモデルに提出された推論リクエストは、出力を生成し続けるが、近日中のモデル廃止についての警告メッセージが含まれる。 2024年8月22日以降、モデルを推論するためのAPIリクエストは出力を生成しません。

非推奨と脱退の詳細については、Foundation モデルのライフサイクルを参照してください。

2024年7月12日までの週

フランクフルトとダラスで新モデル「Mistral Large」を発表

9 2024年7月

フランクフルトとダラスのデータセンターで、IBM watsonx.ai上のMistral AIからMistral Large foundation modelを使用できるようになりました。

Mistral Largeは、トップクラスの推論機能を備えた高性能な大規模言語モデルを企業に提供します。 このfoundation modelは、テキスト理解、変換、コード生成などの複雑な多言語推論タスクに使用できる。 詳しくは、対応ファンデーションモデルをご覧ください。

2024年7月5日までの週

データ・ソース・タイプ別に分類されたコネクタ

05 2024年7月

接続の作成時に、コネクタがデータ・ソース・タイプ別にグループ化され、コネクタを見つけやすく、選択しやすくなりました。 たとえば、MongoDBデータ・ソース・タイプには、IBM Cloud Databases for MongoDBと MongoDBコネクターが含まれます。

さらに、新しいRecentsカテゴリーには、接続の作成に使用した最新の6つのコネクターが表示されます。

手順については、プロジェクトにデータ・ソースへの接続を追加するを参照してください。

Prompt Labで foundation modelのプロンプトに文脈情報を追加する

4 2024年7月

プロンプトに関連するコンテキスト情報を根拠データとして追加することで、「foundation model」が検索機能付き生成(RAG)の使用例において事実に基づいた最新の回答を生成できるようにします。 関連文書を素早くアップロードしたり、関連データのあるサードパーティのベクターストアに接続したりできる。 新しい質問が提出されると、その質問は、関連する事実の根拠データを照会するために使用されます。 上位の検索結果と元の質問は、foundation modelがその出力に関連する事実を組み込むのを助けるために、モデル入力として提出される。

詳細については、 foundation modelのプロンプトを文脈情報に基づかせるを参照してください。

Cloud Object StorageLiteプランの変更

2024 年 7 月 1 日

2024年7月1日から、watsonx.aiと watsonx.governanceの30日間トライアルにサインアップすると自動的にプロビジョニングされるCloud Object StorageLiteプランは、トライアル終了後に失効する。 30日間のトライアル期間中であれば、いつでもCloud Object StorageLiteインスタンスをFree Tierオプション付きのStandardプランにアップグレードできます。

2024年7月1日以前にプロビジョニングしたライトプラン付きの既存のCloud Object Storageサービスインスタンスは、2024年12月15日まで保持されます。 2024年12月15日までにCloud Object StorageサービスをStandardプランにアップグレードする必要があります。

Cloud Object Storageのサービスプランをご覧ください。

2024年6月21日までの週

外部の大規模言語モデル(LLM)用のプロンプトを管理するための分離されたデプロイメントを作成する

21 2024年6月

切り離されたプロンプトテンプレートは、GoogleVertex AI、Azure OpenAI,、AWSBedrockなどのサードパーティプロバイダーによってホストされているLLMのプロンプトテンプレートを評価するための新しいアセットである。 プロンプト・テンプレートの出力を生成する推論はリモート・モデル上で行われるが、watsonx.governanceメトリクスを使用することで、プロンプト・テンプレートの出力を評価することができる。 また、ガバナンス・ソリューションの一環として、AIのユースケースにおいて、切り離されたデプロイメントと切り離されたプロンプト・テンプレートを追跡することもできる。

詳しくは、以下を参照してください。

デプロイジョブのリクエストには、タスク認証情報が必要です

2024年6月19日

デプロイジョブを実行する際のセキュリティを向上させるため、ジョブを要求するユーザは、APIキーの形式でタスク認証情報を提供する必要があります。 この条件は2024年8月15日から施行される。 APIキーの生成の詳細については、タスク認証情報の追加を参照。

EUのAI法適用のためのユースケースの評価

2024年6月19日

新しいEU AI法適用性評価を利用すれば、簡単なアンケートに答えて、自社のAIユースケースを評価し、それがEU AI法の適用範囲内かどうかを判断することができます。 アセスメントは、ユースケースが該当するリスクカテゴリー(禁止、高、限定、最小)を特定するのにも役立つ。 詳細については、ガバナンス・コンソールのソリューション・コンポーネントの適用性評価を参照してください。

2024年6月7日までの週

ガバナンス・コンソールIBM OpenPages)を使用してリスクとコンプライアンス活動を管理する

7 2024年6月

Watsonx.governanceは、ガバナンス・コンソールとオプションで統合できるようになった。 IBM OpenPages,の Model Risk Governance モジュールをインストールしている場合、AI ユースケースを構成して Governance コンソールとガバナンス事実を同期させることができます。 Governance コンソールでは、ガバナンスおよびコンプライアンスプロセスの一環として、ユースケースの作成、ガバナンスアクティビティの表示、タスクの管理、ワークフローの実装を行うことができます。 詳しくは、以下を参照してください。

2024年5月31日までの週

IBM Watson Pipelinesは IBMOrchestration Pipelinesになりました

2024年5月30日

新しいサービス名は、AIのライフサイクルの一部を反復可能なフローに編成する機能を反映している。

プロジェクトをタグ付けして簡単に検索

2024 年 5 月 31 日

プロジェクトにタグを付けて、グループ分けや検索を簡単にできるようになりました。 新しいプロジェクトを作成するとき、またはすべてのプロジェクトのリストからタグを割り当てます。 タグでプロジェクトのリストをフィルタリングして、関連するプロジェクトのセットを取得します。 詳しくは、プロジェクトの作成をご覧ください。

新しいデータソースに接続するMilvus

2024 年 5 月 31 日

Milvus 接続を使用して、 Milvus ベクターストアにアクセスするための認証情報と接続の詳細を保存し、その正確性を確認します。 詳しくは Milvusの接続を参照。

2024年5月24日までの週

新しいチュートリアルとビデオ

2024年5月23日

新しいチュートリアルで、Watson OpenScaleの機能を使用してモデルのデプロイメントを評価する方法をご覧ください。

| チュートリアル | 説明 | チュートリアルの専門知識 |

|---|---|---|

| スペースでの展開を評価する | モデルをデプロイし、デプロイされたモデルのモニターを設定し、デプロイメントスペースでモデルを評価する。 | Configure the monitors and evaluate a model in a deployment space. |

allam-1-13b-instructの foundation modelはフランクフルト地域で利用可能です

2024年5月21日

サウジアラビアのデータ・人工知能庁が提供し、IBMが提供するアラビア語のfoundation model allam-1-13b-instructは、フランクフルトのデータセンターにあるwatsonx.aiから入手できる。 allam-1-13b-instruct foundation modelは、アラビア語のQ&A、要約、分類、生成、抽出、翻訳などの汎用タスクに使用できます。 詳しくは、サポートされているファンデーションモデルをご覧ください。

watsonx.ai Pythonクライアント・ライブラリを使って、従来のAIアセットとジェネレーティブAIアセットをデプロイする

2024年5月21日

Watson Machine Learning Pythonクライアント・ライブラリは現在、拡張ライブラリであるwatsonx.ai Pythonクライアント・ライブラリの一部となっている。 watsonx.ai Pythonライブラリを使って、従来の機械学習や生成 AI 資産を扱うことができます。 Watson Machine Learningライブラリーは存続するが、新機能がアップデートされることはない。 詳細はPythonライブラリを参照。

2024年5月17日までの週

サードパーティのテキスト埋め込みモデルは、watsonx.aiで利用可能です

16 2024年5月

テキスト・マッチングと検索を強化するために、IBMSlateモデルに加えて、以下のサードパーティ製テキスト埋め込みモデルが利用できるようになった:

- all-minilm-l12-v2

- multilingual-e5-large

watsonx.ai Pythonライブラリまたは REST API を使用して、サポートされている埋め込みモデルのいずれかに文章または文章を送信し、入力テキストをベクトルに変換して、類似のテキストをより正確に比較・検索します。

これらのモデルの詳細については、サポートされるエンコーダ基礎モデルを参照してください。

テキスト変換の詳細については、テキスト埋め込み生成を参照してください。

2024年5月10日までの週

ダラス地区で新しいGranite基礎モデルが利用可能

9 2024年5月

watsonx.ai:から、IBMが提供する以下のGraniteCode Foundationモデルを推論できるようになりました:

- granite-3b-code-instruct

- granite-8b-code-instruct

- granite-20b-code-instruct

- granite-34b-code-instruct

プログラム・コーディング・タスクには、新しいGraniteを使用する。 基礎モデルは、論理的推論や問題解決を含む指示追従能力を高めるために、指示データの組み合わせで微調整される。

詳しくは、サポートされているファンデーションモデルをご覧ください。

InstructLabの基礎モデルは、watsonx.aiで利用可能です

7 2024年5月

InstructLabは、Red Hatと IBMによるオープンソースのイニシアチブで、foundation modelモデルの能力を増強するためのプラットフォームを提供する。 以下の基礎モデルは、InstructLab:から提供される知識とスキルをサポートします:

- granite-7b-lab

- granite-13-chat-v2

- granite-20b-multilingual

- merlinite-7b

foundation modelのタクソノミーのページから、オープンソースコミュニティへの貢献を調べることができる。

詳しくはInstructLab-compatible基盤モデルをご覧ください。

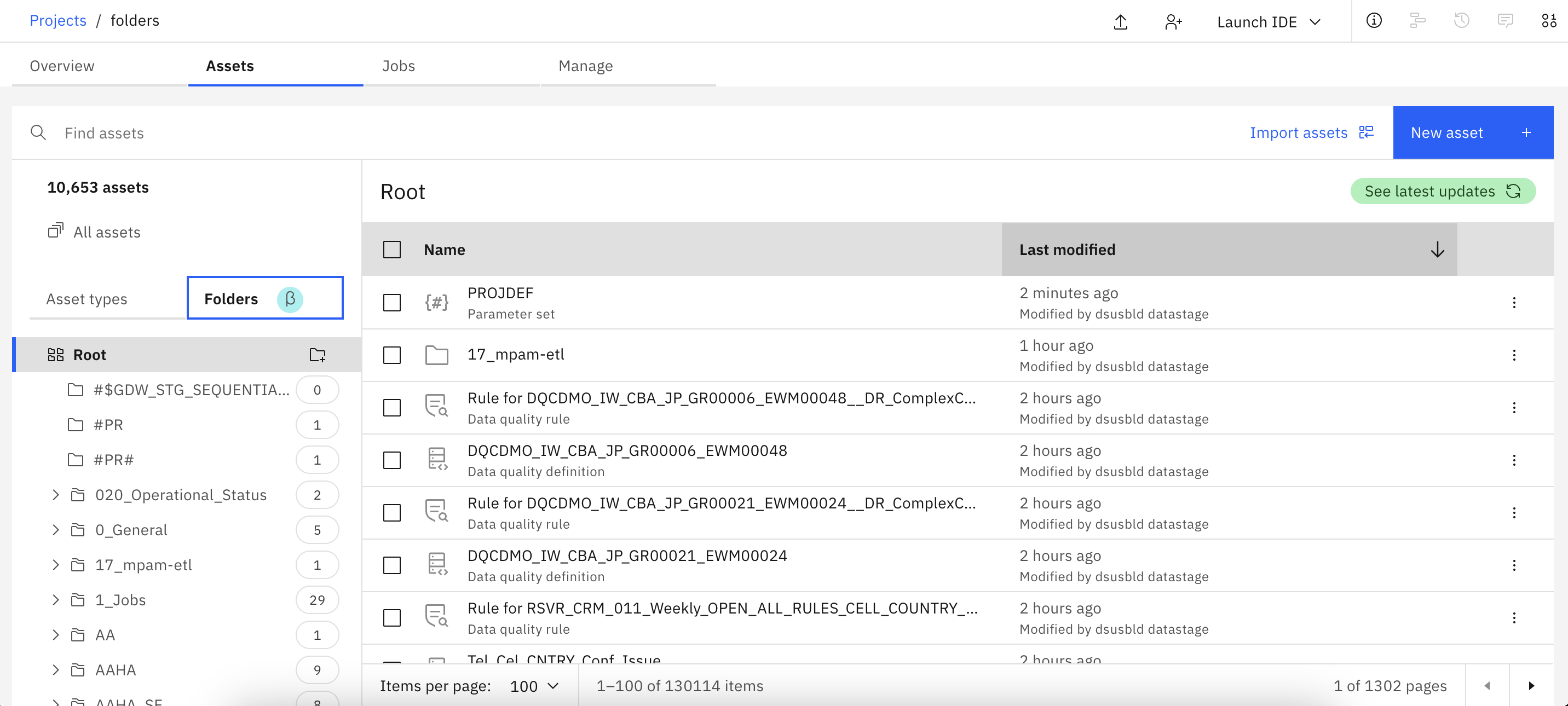

2024年5月3日までの週

プロジェクト資産をフォルダに整理する

2 2024年5月

プロジェクト内にフォルダを作成して、アセットを整理できるようになりました。 プロジェクトの管理者はフォルダを有効にする必要があり、管理者と編集者はフォルダを作成・管理することができます。 フォルダはベータ版であり、本番環境での使用はまだサポートされていません。 詳しくは、フォルダによるアセットの整理(ベータ版)をご覧ください。

2024年4月26日までの週

IBM watsonx.aiはロンドン地域でご利用いただけます

2023年4月25日

Watsonx.aiは現在、ロンドンのデータセンターで一般的に利用可能で、サインアップの際に希望地域としてロンドンを選択することができる。

- ダラスで完全にサポートされている基礎モデルは、ロンドンのデータセンターでも、Prompt Labから、あるいはAPIを使って推論することができる。 例外はmt0-xxl-13bと llama-2-70b-chat foundation modelで、現在販売されているllama-3-70b-instruct foundation modelモデルに取って代わられている。

- Tuning Studioから、またはAPIを使用して、3つのチューニング可能な基礎モデルをプロンプトチューニングします。

- 2つのIBMエンベッディングモデルとエンベッディングAPIがサポートされています。

詳しくは、サービスおよび機能の地域別利用可能性をご覧ください。

ホームページから直接Prompt Labでチャットを開始する

2023年4月25日

IBM watsonx.aiのホームページから、foundation modelモデルと会話を始めることができる。 チャットモードでfoundation modelモデルに送信する質問を入力するか、「OpenPrompt Lab」をクリックして、モデル入力を送信する前にfoundation modelモデルとモデルパラメータを選択します。

2024年4月19日までの週

New Meta Llama 3 foundation models are now available

18 2024年4月

The following Llama 3 foundation models provided by Meta are available for inferencing from watsonx.ai:

- llama-3-8b-instruct

- llama-3-70b-instruct

新しいLlama 3の基礎モデルは、様々なユースケースをサポートできるように細かく調整された言語モデルです。

この最新リリースのラマは、より多くのトークンを使ってトレーニングされ、新しいトレーニング後の手順が適用されている。 その結果、より優れた言語理解、推論、コード生成、命令追従能力を備えた基礎モデルが生まれた。

詳しくは、サポートされているファンデーションモデルをご覧ください。

テキストマッチングと検索を強化するIBMエンベッディングサポートの導入

18 2024年4月

IBMembeddeddings API とIBMembedding models を使用して、入力テキストをベクトルに変換し、類似のテキストをより正確に比較・検索できるようになりました。

以下のIBMSlate埋め込みモデルが利用可能です:

- slate.125m.english.rtrvr

- slate.30m.english.rtrvr

詳しくは、テキスト埋め込み生成をご覧ください。

料金の詳細については、watsonx.aiランタイムプランをご覧ください。

IBM watsonx.governance is included when you sign up for IBM watsonx.ai

18 2024年4月

ダラス地域でwatsonx.aiにサインアップすると、watsonx.governanceが自動的に含まれるようになりました。 IBM watsonx as a Serviceのサインアップを参照してください。

スペースにおける機械学習の導入を評価する

18 2024年4月

watsonx.governance評価をデプロイメントスペースに設定することで、機械学習モデルのパフォーマンスに関する洞察を得ることができます。 例えば、配備の偏りを評価したり、配備のドリフトを監視したりする。 評価を設定すると、評価結果やトランザクションレコードのモデルをスペース内で直接分析できます。

詳しくは、スペースでの配備を評価するを参照。

東京地区には韓国語のfoundation modelがある

18 2024年4月

Minds & Companyが提供する llama2-13b-dpo-v7 foundation model は、 Llama 2 foundation model の Meta を基に、東京地域で利用可能です。

llama2-13b-dpo-v7の foundation modelは、韓国語と英語の会話タスクに特化している。 また、llama2-13b-dpo-v7 foundation modelを韓国語の一般的なタスクに使用することもできます。

詳しくは、サポートされているファンデーションモデルをご覧ください。

mixtral-8x7b-instruct-v01 foundation modelが推論に利用できます

18 2024年4月

Mistral AI のmixtral-8x7b-instruct-v01 foundation modelは、watsonx.ai から推論が可能です。 mixtral-8x7b-instruct-v01 foundation modelは、より効率的にテキストを生成するために疎な専門家混合ネットワークを使用する事前学習済み生成モデルです。

mixtral-8x7b-instruct-v01モデルは、分類、要約、コード生成、言語翻訳などの汎用タスクに使用できます。 詳しくは、サポートされているファンデーションモデルをご覧ください。

mixtral-8x7b-instruct-v01-q foundation modelは非推奨であり、2024年6月20日に廃止されます。 このfoundation modelを使用しているすべてのプロンプトを修正する。

- 廃止日:2024年4月19日

- 脱退日:2024年6月20日

- 代替モデル:mixtral-8x7b-instruct-v01

APIを使用してmixtral-8x7b-instruct-v01-qモデルに提出された推論リクエストは、出力を生成し続けますが、近日中のモデルの取り下げに関する警告メッセージが含まれます。 2024年6月20日以降、モデルを推論するためのAPIリクエストは出力を生成しません。

非推奨と脱退の詳細については、Foundation モデルのライフサイクルを参照してください。

granite-20b-multilingual foundation modelモデルに修正を加える

18 2024年4月

granite-20b-multilingualの最新バージョンは1.1.0です。 この修正には、バージョン1.0のモデルに新しいAIアライメント技術を適用することで得られた改良が含まれている。 AIの調整には、微調整と強化学習のテクニックを使って、できるだけ有益で、真実で、透明性のある出力を返すようにモデルを導くことが含まれる。

このfoundation modelの詳細については、サポートされている基礎モデルを参照のこと。

2024年4月12日までの週

granite-13b-instruct-v2 foundation modelの迅速な調整

11 2024年4月

Tuning Studioは、flan-t5-xl-3bと llama-2-13b-chat基礎モデルに加えて、granite-13b-instruct-v2 foundation modelのチューニングをサポートするようになりました。 詳しくは、 foundation modelのチューニングをご覧ください。

granite-13b-instruct-v2の foundation modelをチューニングするための実験構成設定は、タスクに応じて最適なデフォルト値を適用するように変更されます。 チューニング評価ガイドラインは、実験結果を分析し、その結果に基づいて実験構成設定を調整するのに役立ちます。 詳しくは、チューニング実験の結果を評価するをご覧ください。

フランクフルト地域にはアラビア語のfoundation modelがある

11 2024年4月

Inception、Mohamed bin Zayed University of Artificial Intelligence、Cerebras Systemsが提供するjais-13b-chat foundation modelは、フランクフルト地域で利用できる。

jais-13b-chatの foundation modelは、アラビア語と英語の会話タスクに特化している。 また、jais-13b-chat foundation modelは、アラビア語と英語間の言語翻訳を含むアラビア語の一般的な目的のタスクに使用することができます。

詳しくは、サポートされているファンデーションモデルをご覧ください。

Prompt Labでプロンプトの全文を見る

11 2024年4月

foundation modelにプロンプト変数が含まれている場合や、構造化モードまたはチャットモードで作業している場合に便利です。

詳細はPrompt Labを参照。

非推奨のGraniteバージョン1モデルは廃止された

11 2024年4月

以下のファンデーションモデルは現在販売中止となっている:

- granite-13b-chat-v1

- granite-13b-instruct-v1

これらの基盤モデルを使用しているプロンプトは、IBM Granite v2基盤モデルを使用するように修正してください。 foundation modelの非推奨と廃止の詳細については、Foundationモデルのライフサイクルを参照してください。

2024年4月5日までの週

ピボットテーブルを使用して、Decision Optimization実験で集計されたデータを表示する

5 2024年4月

ピボットテーブルを使用して,Decision Optimization実験のVisualizationビューに集約された入力データと出力データの両方を表示できるようになった. 詳細については、 Decision Optimizationexperimentsの可視化ウィジェットを参照。

新しい watsonx.ai チュートリアルと動画

2024年4月4日

watsonx.ai をデータ準備からプロンプトエンジニアリングまで、エンドツーエンドのユースケースで使用する方法を、新しいチュートリアルで試してみましょう。

| チュートリアル | 説明 | チュートリアルの専門知識 |

|---|---|---|

| watsonx.ai のエンドツーエンドのユースケースをお試しください。 | データ準備から迅速なエンジニアリングまでのユースケースを追う。 | ノートブックや Prompt Lab などのさまざまなツールを使用します。 |

2024年3月15日までの週

watsonx.aiAPI が利用可能です

14 2024年3月

watsonx.aiのAPIは一般に公開されている。 watsonx.aiAPI を使用して、プログラムでファンデーションモデルを操作します。 詳細はAPIリファレンスを参照。

APIのバージョンは2024-03-14です。

ノートブックから基礎モデルを操作するために利用可能なPythonライブラリを引き続き使用することができます。 詳細はPythonライブラリを参照。

ダラス、フランクフルト、東京で新しいファンデーション・モデルを発表

14 2024年3月

現在、watsonx.ai:から推論に利用できる基礎モデルは以下の通りです:

granite-20b-multilingual: IBM Graniteファミリーのfoundation modelで、英語、ドイツ語、スペイン語、フランス語、ポルトガル語の様々な生成タスクに使用できます。

codellama-34b-instruct-hf: Code Llama からのプログラムコード生成モデルは、 ( )に基づいています。 Llama 2 Meta codellama-34b-instruct-hf を使用して、自然言語の入力に基づくコード生成用のプロンプトを作成したり、コードの補完やデバッグを行うことができます。

詳しくは、サポートされているファンデーションモデルをご覧ください。

2024年3月8日までの週

Tuning Studioはフランクフルトにあります

2024年3月7日

Tuning Studioは、フランクフルト地域の有料プランのユーザーが利用できるようになった。 Tuning Studioは、foundation modelが有用な出力を返すように導くのに役立ちます。 フランクフルトのTuning Studioを使用すれば、flan-t5-xl-3bと llama-2-70b-chatの両基礎モデルをチューニングできます。

詳しくはTuning Studioをご覧ください。

首都圏におけるllama-2-13b-chat foundation modelの迅速な調整

2024年3月7日

Tuning Studioが東京リージョンでllama-2-13b-chatの foundation modelのチューニングをサポートしました。 まず、Prompt Labで大きなllama-2-70b-chatモデルのプロンプトを作成し、ユースケースに効果的なプロンプト入力を探します。 その後、Llama 2モデルの小型版をチューニングして、ゼロショットプロンプトで同等、いやそれ以上の出力を生成する。

詳しくはTuning Studioをご覧ください。

Mixtral8x7bモデルの低価格化

5 2024年3月

foundation model mixtral-8x7b-instruct-v01-qは、クラス2:$0.0018/Resourceユニットからクラス1:$0.0006/Resourceユニットに再分類され、このモデルに対して推論タスクを実行することがよりコスト効率的になりました。 この再分類はmixtral-8x7b-instruct-v01-qが利用可能なすべての地域に適用される。

詳しくは、サポートされているファンデーションモデルをご覧ください。

料金の詳細については、watsonx.aiランタイムプランをご覧ください。

AIリスクアトラスの更新と強化

5 2024年3月

AIリスクアトラスでは、以下の新コンテンツや強化されたコンテンツをご覧いただけます:

- ガバナンス、法令遵守、社会的影響リスクにまたがる非技術的リスクの新しいカテゴリー

- リスクに関する新しい例

- リスクの定義の明確化

AIリスクアトラスを参照。

watsonxの新しい使用例

5 2024年3月

watsonxのユースケースは、お客様が弊社の製品、サービス、ツールをどのように使用できるかを確認するのに役立ちます:

- watsonx.aiのユースケース:このユースケースは、機械学習とジェネレーティブ AI をオペレーションのフレームワークに統合することで、AI 駆動のソリューションでビジネスプロセスをどのように変革できるかについて説明します。

- watsonx.governanceのユースケース:このユースケースは、AIモデルを追跡、監視、再トレーニングするための統合システムによって、責任ある透明性の高い説明可能なAIワークフローを実現する方法を説明します。

watsonxの使用例をご覧ください。

2024年3月1日までの週

チャットモードはPrompt Labで利用可能

2024年2月29日

Prompt Labのチャット・モードは、基礎モデルの実験を容易にするシンプルなチャット・インターフェースです。 チャットモードは、すでに利用可能な構造化モードと自由形式モードを補強するもので、抽出、要約、分類などのタスクのために数ショットまたは多ショットのプロンプトを作成するときに便利です。 チャットモードを使用して、チャットボットやバーチャルアシスタントのユースケースのための質問応答や会話のやりとりをシミュレートします。

詳細はPrompt Labを参照。

東京地区には日本語版Graniteが用意されている

2024年2月29日

IBMが提供するgranite-8b-japanese foundation modelは、東京リージョンではwatsonx.aiから入手できる。 granite-8b-japanese foundation modelは、IBM GraniteInstructモデルをベースにしており、日本語テキストを理解し、生成するように訓練されている。

granite-8b-japanese foundation modelは、分類、抽出、質問応答、日英間の言語翻訳など、日本語の汎用タスクに使用できます。

詳しくは、サポートされているファンデーションモデルをご覧ください。

2024年2月23日までの週

Granite-13bモデルの低価格化

2024年2月21日

Granite-13bモデルは、クラス2:$0.0018/Resourceユニットからクラス1:$0.0006/Resourceユニットに再分類され、これらのモデルに対して推論タスクを実行する際の費用対効果が高くなった。 この再分類は、以下のモデルが販売されているすべての地域で適用される:

- granite-13b-chat-v2

- granite-13b-chat-v1

- granite-13b-instruct-v2

- granite-13b-instruct-v1

これらのモデルの詳細については、対応するファンデーションモデルを参照のこと。

料金の詳細については、watsonx.aiランタイムプランをご覧ください。

2024年2月16日までの週

一般的な作業を開始するための新しいショートカット

2024年2月15日

概要タブの作業開始セクションのタイルをクリックすることで、プロジェクトの共通タスクを開始できるようになりました。 これらのショートカットを使って、共同作業者とデータの追加を開始し、モデルを実験・構築する。 View allをクリックすると、ツールの選択にジャンプします。

汎用タスク用foundation model mixtral-8x7b-instruct-v01-q

2024年2月15日

Mistral AIが提供し、IBMが量子化したmixtral-8x7b-instruct-v01-q foundation modelモデルは、watsonx.aiから入手できる。 mixtral-8x7b-instruct-v01-q ファ基盤モデルは、Mistral AI の Mixtral 8x7B インストラクション・ファ基盤モデルの量子化されたバージョンです。

この新しいモデルは、分類、要約、コード生成、言語翻訳などの汎用タスクに使用できる。 詳しくは、サポートされているファンデーションモデルをご覧ください。

以下のモデルは非推奨であり、間もなく廃止される予定である。 これらの基礎モデルを使用しているプロンプトは、mixtral-8x7b-instruct-v01-qのような別のfoundation modelを使用するように修正してください。

| 非推奨モデル | 非推奨日付 | 退会日 | 代替モデル |

|---|---|---|---|

| gpt-neox-20b | 2024年2月15日 | 2024年3月21日 | mixtral-8x7b-instruct-v01-q |

| mpt-7b-instruct2 | 2024年2月15日 | 2024年3月21日 | mixtral-8x7b-instruct-v01-q |

| starcoder-15.5b | 2024年2月15日 | 11 2024年4月 | mixtral-8x7b-instruct-v01-q |

APIを使用してこれらのモデルに送信された推論リクエストは、出力を生成し続けるが、近日中のモデルの取り下げに関する警告メッセージが含まれる。 退会日に達すると、モデルを推論するためのAPIリクエストは出力を生成しなくなる。

非推奨と脱退の詳細については、Foundation モデルのライフサイクルを参照してください。

granite-13b-chat-v2 foundation modelの修正が可能です

2024年2月15日

granite-13b-chat-v22の最新バージョンは2.1.0です。 この修正には、バージョン2.0.0のモデルに新しいAIアライメント技術を適用することで得られた改良が含まれている。 AIの調整には、微調整と強化学習のテクニックを使って、できるだけ有益で、真実で、透明性のある出力を返すようにモデルを導くことが含まれる。 詳しくは、AIアライメントとは? IBMResearchのブログ記事。

新しいwatsonxのチュートリアルとビデオ

2024年2月15日

新しいwatsonx.governanceチュートリアルをお試しください。Watson OpenScale を使用して、公正さ、正確さ、ドリフト、説明可能性について機械学習モデルを評価する方法を学ぶことができます。

| チュートリアル | 説明 | チュートリアルの専門知識 |

|---|---|---|

| 機械学習モデルを評価する | モデルをデプロイし、デプロイされたモデルにモニターを設定し、モデルを評価する。 | Run a notebook to configure the models and use Watson OpenScale to evaluate. |

2024年2月9日までの週

タスク指向のDecision Optimizationドキュメント

9 2024年2月

Decision Optimization実験の作成と設定に必要な情報を、より簡単に見つけることができるようになりました。 Decision Optimization実験とそのサブセクションを参照。

IBM Cloud Data Engineの接続は非推奨です

2022年2月8日

IBM Cloud Data Engine接続は非推奨であり、将来のリリースで廃止される予定です。 重要な日付と詳細については、データエンジンの廃止をご覧ください。

Data Refineryフロー・ジョブを実行するための新しいSpark3.4環境

9 2024年2月

Data Refineryフロージョブの環境を選択する際に、Sparkの機能強化を含むDefault Spark3.4& R4.22を選択できるようになりました。

デフォルトのSpark3.3& R4.2環境は非推奨であり、将来のアップデートで削除される予定です。

Data Refineryのフロー・ジョブを更新して、新しいDefault Spark3.4& R4.2環境を使用するようにします。 詳細は、プロジェクトData Refineryのオプションを参照してください。

2024年2月2日までの週

サンプルコレクションはリソースハブに名称変更

2024年2月2日

Samplesコレクションは、より内容を反映するためにResource hubに改名されました。 リソースハブには、基礎モデル、サンプルプロジェクト、データセット、ノートブックがあります。 リソースハブを参照。

IBM Cloud Databases for DataStaxの接続は終了しました

2024年2月2日

IBM Cloud Databases for DataStax接続はIBM watsonx.aiから削除されました。

Dremio接続にはアップデートが必要

2024年2月2日

以前のDremio接続はJDBCドライバを使っていた。 現在、接続にはArrow Flightベースのドライバーを使用している。

重要:接続プロパティを更新する。 DremioSoftware(オンプレミス)インスタンスまたはDremioCloud インスタンスの接続には、異なる変更が適用されます。

Dremioソフトウェア:ポート番号を更新してください。

Flightが使用する新しいデフォルトのポート番号は32010です。 ポート番号はdremio.confファイルで確認できる。 詳しくは dremio.confによる設定を参照してください。

さらに、Dremioは IBM Cloud Satelliteとの接続をサポートしなくなった。

DremioCloudです:認証方法とホスト名を更新します。

- Dremioにログインし、個人アクセストークンを生成する。 手順については、パーソナル・アクセストークンを参照してください。

- IBM watsonxの[接続の作成]にある:Dremioフォームで、認証タイプをPersonal Access Tokenに変更し、トークン情報を追加します。 (ユーザー名とパスワードによる認証は、Dremioクラウドインスタンスへの接続に使用できなくなりました)

- ポートがSSL対応であることを選択します。

DremioCloud インスタンスにデフォルトのホスト名を使用している場合は、変更する必要があります:

sql.dremio.clouddata.dremio.cloudに変更sql.eu.dremio.clouddata.eu.dremio.cloudに変更

llama-2-13b-chat foundation modelのプロンプトチューン

2024年2月1日

Tuning Studioが llama-2-13b-chat foundation modelのチューニングに対応しました。 まず、Prompt Labで大きなllama-2-70b-chatモデルのプロンプトを作成し、ユースケースに効果的なプロンプト入力を探します。 その後、Llama 2モデルの小型版をチューニングして、ゼロショットプロンプトで同等、いやそれ以上の出力を生成する。 llama-2-13b-modelは、ダラス地域で迅速なチューニングが可能です。 詳しくはTuning Studioをご覧ください。

2024年1月26日までの週

AutoAIはすべての実験で順序データをサポートする

2024年1月25日

時系列実験だけでなく、すべてのAutoAI実験で順序付きデータを指定できるようになりました。 行索引に従って、トレーニング・データを順次に配列するかどうかを指定します。 入力データがシーケンシャルである場合、モデルの性能はランダムサンプリングではなく最新のレコードで評価され、ホールドアウトデータはn個のランダムレコードではなくセットの最後のn個のレコードを使用する。 時系列実験では連続データが必要だが、分類実験や回帰実験では任意である。

RAGアクセラレーターとのQ&A

2024年1月26日

サンプルプロジェクトをインポートすることで、検索拡張生成を使用した質疑応答ソリューションを実装できるようになりました。 サンプル・プロジェクトには、ドキュメントをHTMLやPDFからプレーン・テキストに変換し、ドキュメント・セグメントをElasticsearchのベクトル・インデックスにインポートし、ベクトル・インデックスにクエリするPython関数をデプロイし、トップNの結果を取得し、LLM推論を実行して質問に対する答えを生成し、答えが幻覚でないかチェックするノートブックやその他のアセットが含まれている。

ダークテーマに設定

2024年1月25日

watsonxのユーザーインターフェイスをダークテーマに設定できるようになりました。 アバターをクリックし、プロフィールと設定を選択してアカウントプロフィールを開きます。 次に、ダークテーマのスイッチをオンに設定する。 ダークテーマはRStudioとJupyterノートブックではサポートされていません。 プロフィールの管理については、設定の管理をご覧ください。

IBM watsonx.aiは東京リージョンで利用可能です

2024年1月25日

Watsonx.aiは現在、東京のデータセンターで一般的に利用可能であり、契約時に希望する地域として選択することができる。 Prompt Labと foundation modelの推論は、東京地区ではこれらのモデルでサポートされている:

- elyza-japanese-llama-2-7b-instruct

- flan-t5-xl-3b

- flan-t5-xxl-11b

- flan-ul2-20b

- granite-13b-chat-v2

- granite-13b-instruct-v2

- llama-2-70b-chat

- llama-2-13b-chat

東京地区からも購入可能:

- Tuning Studioを使用したflan-t5-xl-3b foundation modelの迅速なチューニング

- Synthetic Data Generatorで表形式のデータを生成し、モデルのトレーニングに使用する

サポートされているモデルの詳細については、 watsonx.aiで利用可能なサポートされている基礎モデルをご覧ください。

東京地区には日本語モデルのLlama 2がある

2024年1月25日

株式会社ELYZAが提供する elyza-japanese-llama-2-7b-instruct foundation model は、東京データセンターの watsonx.ai インスタンスから利用可能です。 elyza-japanese-llama-2-7b-instruct モデルは、 Llama 2 モデルを日本語のテキストを理解し生成するように訓練したものです。 Meta

この新しいモデルは、一般的な作業に使用できる。 日本語の分類や抽出、日英間の翻訳に威力を発揮する。

2024年1月12日までの週

watsonx.aiRuntime(Watson Machine Learning)でIBMRuntime22.2のサポートが非推奨となりました

2024年1月11日

IBMRuntime22.22は非推奨であり、2024年4月11日に削除される予定です。 2024年3月7日以降、22.2ランタイムを使用してノートブックやカスタム環境を作成することはできません。 また、22.2ランタイムに基づくソフトウェア仕様で新しいモデルをトレーニングすることはできません。 2024年3月7日以前にIBMRuntime23.11を使用するように、資産とデプロイメントを更新してください。

- 資産をサポートされているフレームワークやソフトウェア仕様に移行する方法については、「古いソフトウェア仕様やフレームワークの管理」を参照してください。

- ノートブック環境の詳細については、プロジェクトのノートブック・エディタのリソース・オプションを計算してください。

- 環境の変更について詳しくは、ノートブックの環境を変更するをご覧ください。

IBM Granite v1ファンデーション・モデルは廃止されました

2024年1月11日

IBM Granite130億パラメータv1基礎モデルは、非推奨であり、2024年4月11日に廃止される。 バージョン1のモデルを使用している場合は、バージョン2のモデルに切り替えてください。

| 非推奨モデル | 非推奨日付 | 退会日 | 代替モデル |

|---|---|---|---|

| granite-13b-chat-v1 | 2024年1月11日 | 11 2024年4月 | granite-13b-chat-v2 |

| granite-13b-instruct-v1 | 2024年1月11日 | 11 2024年4月 | granite-13b-instruct-v2 |

APIを使用してバージョン1モデルに送信された推論リクエストは、出力を生成し続けるが、近日中のモデル廃止に関する警告メッセージが含まれる。 2024年4月11日以降、モデルを推論するためのAPIリクエストは出力を生成しません。

IBM Graniteファンデーション・モデルの詳細については、 IBMが構築したファンデーション・モデルを参照してください。 非推奨と脱退の詳細については、Foundation モデルのライフサイクルを参照してください。