Evaluation des déploiements dans les espaces

Configurez les évaluations watsonx.governance dans vos espaces de déploiement pour obtenir des informations sur les performances de votre modèle. Lorsque vous configurez des évaluations, vous pouvez analyser les résultats d'évaluation et modéliser les enregistrements de transaction directement dans vos espaces.

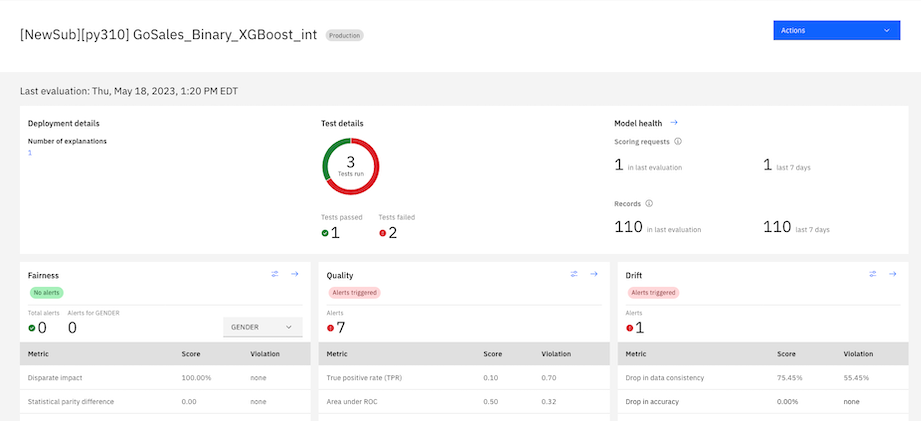

watsonx.governance évalue vos déploiements de modèle pour vous aider à mesurer les performances et à comprendre les prévisions de votre modèle. Lorsque vous configurez des évaluations de modèle, watsonx.governance génère des métriques pour chaque évaluation qui fournissent des informations différentes que vous pouvez examiner. watsonx.governance consigne également les transactions qui sont traitées lors des évaluations pour vous aider à comprendre comment les prévisions de votre modèle sont déterminées. Pour plus d'informations, voir Evaluation des modèles d'IA avec Watson OpenScale.

Si vous disposez d'une instance de watsonx.governance mise à disposition, vous pouvez créer en toute transparence un déploiement en ligne, puis surveiller les résultats de déploiement pour l'équité, la qualité, la dérive et l'explicabilité.

Un scénario typique suit cette séquence:

- Créez un espace de déploiement et associez une instance watsonx.governance à l'espace pour activer toutes les fonctions de surveillance. Vous pouvez choisir le type d'espace, par exemple en production ou en préproduction, en fonction de vos besoins.

- Promouvez un modèle d'apprentissage automatique entraîné et des données d'entrée (contenu) dans l'espace de déploiement et créez un déploiement en ligne pour le modèle.

- Dans l'onglet Test de déploiement, fournissez les données d'entrée et obtenez les prévisions.

- Dans l'onglet Evaluations, configurez l'évaluation pour surveiller la qualité, l'équité et l'explicabilité de votre déploiement. Fournissez tous les détails de modèle requis afin que Watson OpenScale puisse se connecter au modèle, aux données d'entraînement et de contenu et à un référentiel pour stocker les résultats d'évaluation.

- Configurez un moniteur d'équité pour vous assurer que votre modèle génère des résultats non biaisés. Sélectionnez les champs à surveiller pour l'équité, puis définissez des seuils pour mesurer les prévisions d'un groupe surveillé par rapport à un groupe de référence. Par exemple, vous pouvez évaluer votre modèle pour vous assurer qu'il fournit des prévisions non biaisées basées sur le sexe.

- Configurez un moniteur de qualité pour déterminer les performances du modèle en fonction du nombre de résultats corrects générés par le modèle en fonction des données de test étiquetées appelées données de retour. Définissez des seuils de qualité pour effectuer le suivi lorsqu'une valeur de métrique se trouve en dehors d'une plage acceptable.

- Configurez un moniteur pour la dérive afin de vous assurer que vos déploiements sont à jour et cohérents. Utilisez l'importance des fonctions pour déterminer l'impact de la dérive des fonctions sur votre modèle. Par exemple, une petite quantité de dérive dans une fonction importante peut avoir un impact plus important sur votre modèle qu'une quantité modérée de dérive dans une fonction moins importante.

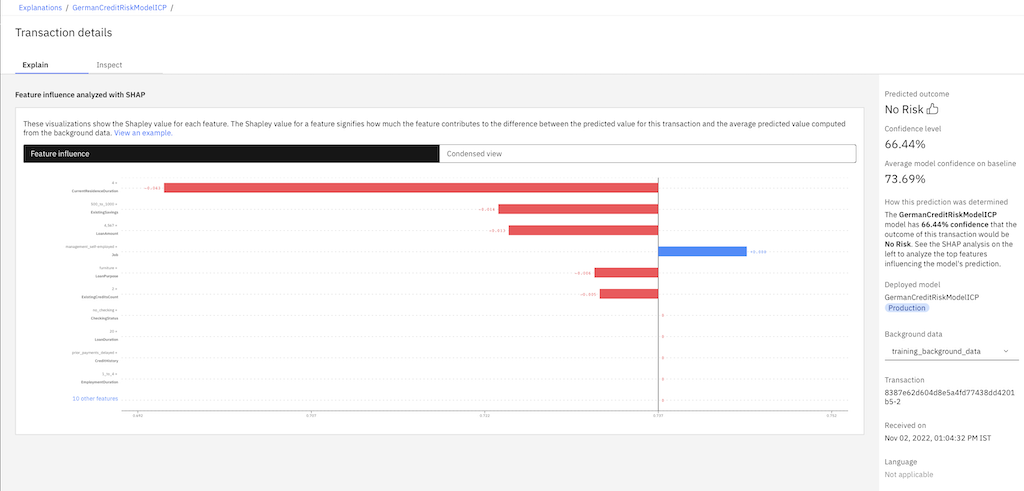

- Vous pouvez surveiller les résultats de votre déploiement pour l'explicabilité afin de comprendre les facteurs qui ont conduit le modèle à déterminer une prévision. Choisissez la méthode d'explication la mieux adaptée à vos besoins. Par exemple, vous pouvez choisir la méthode SHAP (Shapley Additive EXplanations) pour des explications approfondies ou la méthode LIME (Local Interpretable Model-Agnostic Explications) pour des explications plus rapides.

- Enfin, vous pouvez inspecter vos évaluations de modèle pour trouver les zones où de petits changements apportés à quelques entrées pourraient entraîner une décision différente. Testez les scénarios pour déterminer si la modification des entrées peut améliorer les performances du modèle.

Les sections suivantes expliquent comment configurer les évaluations watsonx.governance et passer en revue les informations sur les modèles dans vos espaces de déploiement:

Préparation de l'évaluation des modèles dans les espaces

Si vous ne disposez pas d'une base de données associée à votre instance watsonx.governance , vous devez associer une base de données avant de pouvoir exécuter des évaluations. Pour associer une base de données, vous devez également cliquer sur Associer une base de données dans la boîte de dialogue Base de données requise pour vous connecter à une base de données. Vous devez disposer du rôle Admin pour votre projet et de l'instance watsonx.governance pour associer des bases de données.

Configuration des évaluations Watson OpenScale dans les espaces

Une fois que vous avez associé votre instance Watson OpenScale , vous pouvez sélectionner des déploiements pour afficher les onglets Evaluations et Transactions que vous pouvez utiliser pour configurer des évaluations et examiner les connaissances du modèle. Pour commencer à configurer les évaluations de modèle dans votre espace, vous pouvez sélectionner Configurer les paramètres d'évaluation OpenScale pour ouvrir un assistant qui fournit une série d'étapes guidées.

Vous pouvez évaluer les déploiements en ligne uniquement dans votre espace de déploiement.

Fourniture des détails du modèle

Pour configurer les évaluations de modèle, vous devez fournir des détails sur le modèle afin de permettre à watsonx.governance de comprendre comment votre modèle est configuré. Vous devez fournir des détails sur vos données d'entraînement et votre sortie de modèle.

Pour plus d'informations, voir Indication des détails du modèle.

Configuration de l'explicabilité

Vous pouvez configurer l'explicabilité dans watsonx.governance afin de révéler les caractéristiques qui contribuent au résultat prévu par votre modèle pour une transaction et de prévoir les changements qui résulteraient en un résultat différent. Vous pouvez choisir de configurer des explications locales pour analyser l'impact des facteurs pour des transactions de modèle spécifiques et de configurer des explications globales pour analyser les facteurs généraux qui ont un impact sur les résultats du modèle.

Pour plus d'informations, voir Configuration de l'explicabilité.

Configuration des évaluations d'équité

Vous pouvez configurer des évaluations d'équité pour déterminer si votre modèle génère des résultats biaisés pour différents groupes. Pour configurer des évaluations d'équité, vous pouvez spécifier le groupe de référence que vous prévoyez de représenter les résultats favorables et les métriques d'équité que vous souhaitez utiliser. Vous pouvez également sélectionner des fonctions qui sont comparées au groupe de référence afin de les évaluer pour le biais.

Pour plus d'informations, voir Configuration des évaluations d'équité.

Configuration des évaluations de qualité

Vous pouvez configurer des évaluations de la qualité pour comprendre dans quelle mesure votre modèle prévoit des résultats précis. Pour configurer les évaluations de la qualité, vous devez spécifier des seuils pour chaque métrique afin de permettre à watsonx.governance d'identifier le moment où la qualité du modèle diminue.

Pour plus d'informations, voir Configuration des évaluations de qualité.

Configuration des évaluations de dérive v2

Vous pouvez configurer des évaluations de dérive v2 pour mesurer les changements dans vos données au fil du temps afin d'obtenir des résultats cohérents pour votre modèle. Pour configurer les évaluations de dérive v2 , vous devez définir des seuils qui permettent à watsonx.governance d'identifier les modifications apportées à la sortie de votre modèle, la précision de vos prévisions et la distribution de vos données d'entrée. Vous devez également sélectionner des fonctions importantes pour permettre à watsonx.governance de mesurer la modification de la distribution des valeurs.

Pour plus d'informations, voir Configuration des évaluations v2 de dérive.

Configuration des évaluations de dérive

Vous pouvez configurer des évaluations de dérive pour permettre à watsonx.governance de détecter les baisses de précision et de cohérence des données dans votre modèle. Pour configurer les évaluations de dérive, vous devez définir des seuils pour permettre à watsonx.governance d'établir une base de référence de précision et de cohérence pour votre modèle.

Pour plus d'informations, voir Configuration des évaluations de dérive.

Exécution d'évaluations

Après avoir configuré les évaluations, vous pouvez fermer l'assistant pour exécuter les évaluations. Pour exécuter les évaluations, vous devez sélectionner Evaluer maintenant dans le menu Actions de l'onglet Evaluations pour envoyer des transactions de modèle.

Examen des résultats de l'évaluation

Vous pouvez analyser les résultats d'évaluation dans l'onglet Evaluations pour obtenir des informations sur les performances de votre modèle. Pour analyser les résultats d'évaluation, vous pouvez cliquer sur la flèche  dans une section d'évaluation ou utiliser le menu Actions pour afficher les détails de votre modèle.

dans une section d'évaluation ou utiliser le menu Actions pour afficher les détails de votre modèle.

Pour plus d'informations, voir Examen des résultats d'évaluation.

Examen des transactions de modèle

Vous pouvez analyser les transactions de modèle dans l'onglet Transactions pour comprendre comment votre modèle prévoit les résultats et prévoir les changements qui peuvent entraîner des résultats différents. Pour analyser les transactions, vous pouvez choisir d'afficher des explications qui fournissent des détails sur la façon dont les prévisions de votre modèle sont déterminées.

Pour plus d'informations, voir Exploration des transactions de modèle.

Rubrique parent: Gestion des déploiements prédictifs