watsonx.ai で推論を行うためのカスタムfoundation modelを導入する際の考慮事項と要件を確認する。

カスタム・foundation modelの配備を準備する際には、以下の計画上の注意点を確認してください:

- カスタム基盤モデルの要件と使用上の注意点を確認する

- Supported architectures for custom foundation models を確認して、あなたのモデルが互換性があることを確認してください。

- カスタムfoundation modelを展開するための前提条件として必要な詳細を収集する。

- カスタム・foundation modelのハードウェア仕様を選択します。

- 配備の制限を確認する

- カスタム基盤モデルをデプロイできるように、タスク認証情報を有効にします。

カスタム・ファンデーション・モデルの要件と使用上の注意

配備可能なカスタムモデルは、これらの要件を満たさなければならない:

独自のカスタムモデルをアップロードして使用できるのは、watsonx.ai のスタンダードプランのみです。

モデルは、Text Generation Inference(TGI)標準と互換性があり、サポートされているモデル・アーキテクチャ・タイプで構築されていなければならない。

モデルのファイルリストには、

config.jsonファイルが含まれていなければなりません。モデルは、サポートされているトランスフォーマーライブラリを使った

safetensors形式で、tokenizer.jsonファイルを含んでいなければなりません。重要:- foundation modelがサポートされている'

transformersライブラリで保存されていることを確認する必要があります。 カスタムfoundation modelの model.safetensorsファイルが、メタデータヘッダでサポートされていないデータ形式を使用している場合、デプロイが失敗する可能性があります。 詳しくは、 watsonx.aiランタイムのトラブルシューティングをご覧ください。 - foundation modelをデプロイするプロジェクトまたはスペースに、関連するwatsonx.aiランタイムインスタンスがあることを確認します。 プロジェクトまたはスペースの「管理」タブを開いて確認してください。

- foundation modelがサポートされている'

対応モデル・アーキテクチャ

次の表は、watsonx.ai で推論を行うためのカスタムモデルとして配置できるモデルアーキテクチャの一覧です。 モデルのアーキテクチャは、サポートされている量子化方法、並列テンソル、配置構成サイズ、ソフトウェア仕様に関する情報とともにリストアップされている。

Two software specifications are available for your deployments: watsonx-cfm-caikit-1.0, watsonx-cfm-caikit-1.1. The watsonx-cfm-caikit-1.1 specification is better in terms of performance, but it's not available with every model architecture.

| モデル・アーキテクチャ・タイプ | 量子化法 | 並列テンソルmultiGpu | 導入の構成 | ソフトウェア仕様 |

|---|---|---|---|---|

bloom |

該当なし | はい | スモール、ミディアム、ラージ | watsonx-cfm-caikit-1.0, watsonx-cfm-caikit-1.1 |

codegen |

該当なし | いいえ | 小 | watsonx-cfm-caikit-1.0 |

exaone |

該当なし | いいえ | 小 | watsonx-cfm-caikit-1.1 |

falcon |

該当なし | はい | スモール、ミディアム、ラージ | watsonx-cfm-caikit-1.0, watsonx-cfm-caikit-1.1 |

gemma |

該当なし | はい | 小・中・大 | watsonx-cfm-caikit-1.1 |

gemma2 |

該当なし | はい | 小・中・大 | watsonx-cfm-caikit-1.1 |

gpt_bigcode |

gptq |

はい | スモール、ミディアム、ラージ | watsonx-cfm-caikit-1.0, watsonx-cfm-caikit-1.1 |

gpt-neox |

該当なし | はい | スモール、ミディアム、ラージ | watsonx-cfm-caikit-1.0, watsonx-cfm-caikit-1.1 |

gptj |

該当なし | いいえ | 小 | watsonx-cfm-caikit-1.0, watsonx-cfm-caikit-1.1 |

granite |

該当なし | いいえ | 小 | watsonx-cfm-caikit-1.1 |

llama |

gptq |

はい | スモール、ミディアム、ラージ | watsonx-cfm-caikit-1.0, watsonx-cfm-caikit-1.1 |

mistral |

該当なし | いいえ | 小 | watsonx-cfm-caikit-1.0, watsonx-cfm-caikit-1.1 |

mixtral |

gptq |

いいえ | 小 | watsonx-cfm-caikit-1.0, watsonx-cfm-caikit-1.1 |

mpt |

該当なし | いいえ | 小 | watsonx-cfm-caikit-1.0, watsonx-cfm-caikit-1.1 |

mt5 |

該当なし | いいえ | 小 | watsonx-cfm-caikit-1.0 |

nemotron |

該当なし | はい | 小・中・大 | watsonx-cfm-caikit-1.1 |

olmo |

該当なし | はい | 小・中・大 | watsonx-cfm-caikit-1.1 |

persimmon |

該当なし | はい | 小・中・大 | watsonx-cfm-caikit-1.1 |

phi |

該当なし | はい | 小・中・大 | watsonx-cfm-caikit-1.1 |

phi3 |

該当なし | はい | 小・中・大 | watsonx-cfm-caikit-1.1 |

qwen |

該当なし | はい | 小・中・大 | watsonx-cfm-caikit-1.1 |

qwen2 |

AWQ |

はい | 小・中・大 | watsonx-cfm-caikit-1.1 |

t5 |

該当なし | はい | スモール、ミディアム、ラージ | watsonx-cfm-caikit-1.0 |

- IBM は、サポートされていないアーキテクチャで基盤モデルを展開したことによる展開の失敗をサポートしません。

llama 3.1モデルのデプロイが失敗する可能性があります。 この問題に対処するには、トラブルシューティングに記載されている手順を参照してください。- It is not possible to deploy

codegen,mt5, andt5type models with thewatsonx-cfm-caikit-1.1software specification. - モデルが並列テンソルをサポートしていない場合、使用できる設定は

Smallだけです。Smallがサポートする設定よりも多くのパラメータを使ってモデルをトレーニングした場合は、失敗します。 これは、カスタムモデルのいくつかをデプロイできないことを意味する。 制限の詳細については、リソース利用ガイドラインをご覧ください。

カスタムfoundation modelの前提条件の詳細を収集する

foundation model内のファイル「

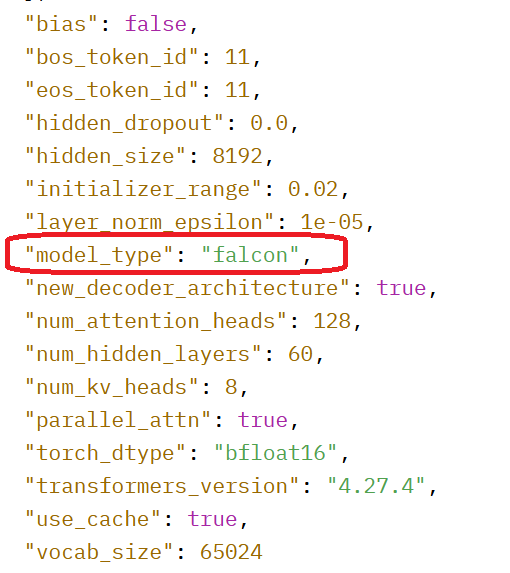

config.json存在を確認する。 デプロイメントサービスは、クラウドストレージにアップロードされた後、foundation modelのコンテンツフォルダ内のファイル'config.jsonの存在を義務付ける。config.jsonファイルを開いて、foundation modelが サポートされているアーキテクチャを使用していることを確認する。tokenizer.jsonファイルがあるかどうか、モデルの内容が'.safetensors形式であるかどうかを確認するために、foundation modelのファイルリストを表示します。重要:foundation modelがサポートされている'

transformersライブラリで保存されていることを確認する必要があります。 カスタムfoundation modelの model.safetensorsファイルが、メタデータヘッダでサポートされていないデータ形式を使用している場合、デプロイが失敗する可能性があります。 詳しくは、 watsonx.aiランタイムのトラブルシューティングをご覧ください。

例を見てみよう:

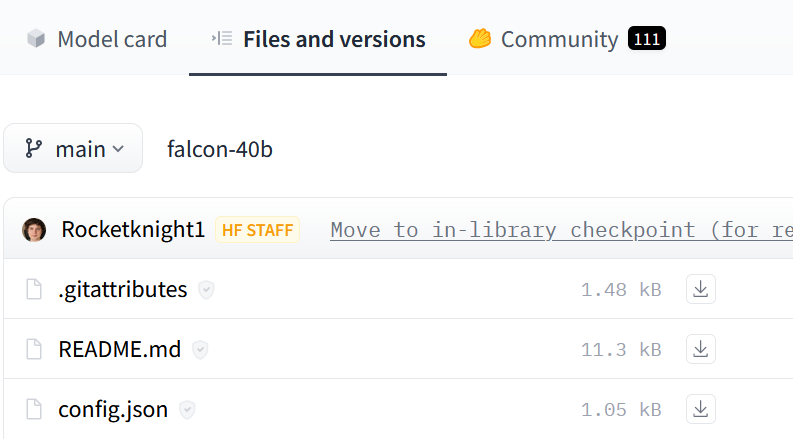

Hugging Faceに保存されているfalcon-40bモデルの場合、Files and versionsをクリックしてファイル構造を表示し、'config.jsonをチェックする:

サンプルモデルは、サポートされているfalconアーキテクチャのバージョンを使用しています。

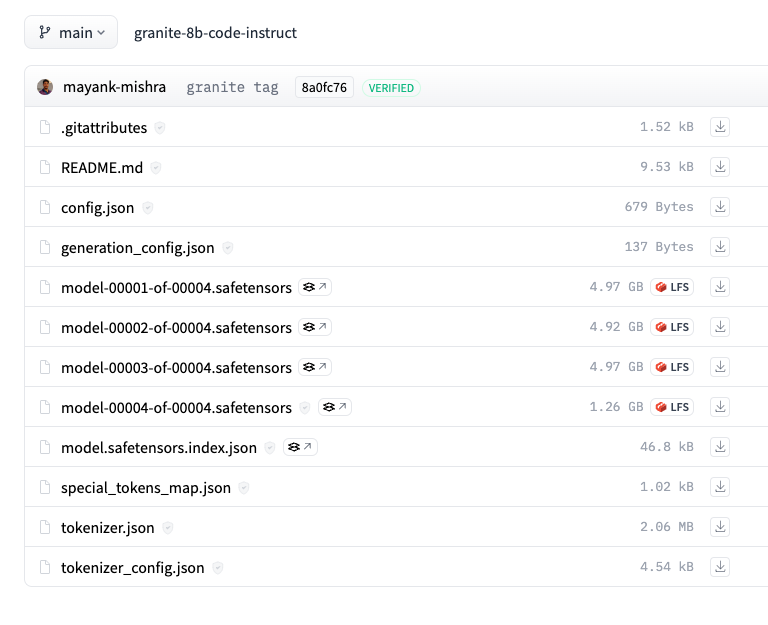

このサンプルモデルはtokenizer.jsonファイルを含み、.safetensorsフォーマットになっています:

モデルがこれらの要件を満たしていない場合、モデル資産を作成してモデルをデプロイすることはできません。

資源利用ガイドライン

カスタム・foundation modelをサポートするために、3つのコンフィギュレーションが用意されている: Small 、'Medium 、'Large 。 カスタム・foundation modelモデルに最適な構成を決定するには、以下のガイドラインを参照してください:

- 26B パラメータの下で、

Smallコンフィギュレーションを任意のダブルバイト精度モデルに割り当て、テストと検証を行う。 - 27B と 53B のパラメータの間の任意のダブルバイト精度モデルに

Mediumコンフィギュレーションを割り当て、テストと検証を行う。 - 54B から 106B パラメータ間の任意のダブルバイト精度モデルに

Largeコンフィギュレーションを割り当て、テストと検証を行う。

選択したコンフィギュレーションがテストと検証の段階で失敗した場合、次に利用可能な上位コンフィギュレーションを検討する。 例えば、Smallの設定が失敗したら、Mediumの設定を試してください。 現在のところ、Largeのコンフィギュレーションが最も高いコンフィギュレーションです。

| 構成 | 適切なモデルの例 |

|---|---|

| 小 | llama-3-8bllama-2-13bstarcoder-15.5bmt0-xxl-13bjais-13bgpt-neox-20bflan-t5-xxl-11bflan-ul2-20ballam-1-13b |

| 中間 | codellama-34b |

| 大 | llama-3-70b llama-2-70b |

カスタム・ファンデーション・モデルの制限と制約

watsonx.aiでカスタム基礎モデルをデプロイして使用する方法について、これらの制限に注意してください。

カスタム・ファウンデーション・モデルの展開における制限事項

カスタム・foundation modelのデプロイに対する需要が高く、それに対応するためのリソースが限られているため、watsonx.aiは、IBM Cloudアカウントごとに、4つの小規模モデル、2つの中規模モデル、または1つの大規模モデルのいずれかのデプロイ制限を設けています。 これらの制限を超えてカスタム・foundation modelをインポートしようとすると、その旨が通知され、アンケートを通じてご意見をお聞かせいただくことになります。 これは、お客様のニーズを理解し、将来の容量アップグレードを計画するのに役立ちます。

カスタム・foundation modelのデプロイメントを使用する際の制限事項

watsonx.ai:でデプロイされた後、カスタム基盤モデルを使用するための以下の制限に注意してください

- カスタム・foundation modelをチューニングすることはできない。

- watsonx.governanceを使用して、カスタムfoundation modelモデルのプロンプトテンプレートを評価または追跡することはできません。

- foundation modelのプロンプトを表示することはできますが、カスタムモデルのプロンプトテンプレートを保存することはできません。

この体験の改善にご協力ください

ご意見をお聞きになりたい方は、このリンクをクリックしてください。 皆様からのフィードバックは、今後のキャパシティアップグレードの計画や、foundation modelのデプロイメントエクスペリエンス全体の向上に欠かせません。 ご協力ありがとう!

今後のステップ

カスタムfoundation modelのダウンロードとストレージの設定

親トピック foundation modelのデプロイ