Translation not up to date

Sonuçlarınızın bir grup için diğerinden daha önyargılı olmadığından emin olmak için bir deneyi adil olarak değerlendirin.

Sınırlamalar

Zaman serisi deneylerinde adalet değerlendirmeleri desteklenmez.

Deneylerin ve modellerin adalet için değerlendirilmesi

Bir deney tanımlayıp bir makine öğrenimi modeli ürettiğinizde, sonuçlarınızın güvenilir ve tarafsız olduğundan emin olmak istersiniz. Bir makine öğrenimi modelinde önyargı, model eğitim sırasında yanlış dersleri öğrendiğinde ortaya çıkabilir. Bu senaryo, model tahminler oluşturduğunda yetersiz veri ya da zayıf veri toplama ya da yönetim sonucu kötü bir sonuç ortaya çıktığında ortaya çıkabilir. Gerektiğinde onları düzeltmek ve model sonuçlarına güven oluşturmak için önyargı işaretleri için bir deneyi değerlendirmek önemlidir.

AutoAI , önyargı için bir deneyi değerlendirmenize ve düzeltmenize yardımcı olacak aşağıdaki araçları, teknikleri ve özellikleri içerir.

Tanımlar ve terimler

Adalet Özniteliği -Bias ya da Fairness genellikle cinsiyet, etnik köken ya da yaş gibi bir adalet özniteliği kullanılarak ölçülür.

İzlenen/Başvuru Grubu -İzlenen grup, önyargıyı ölçmek istediğiniz adalet özniteliği değerleridir. İzlenen gruptaki değerler, başvuru grubundaki değerlerle karşılaştırılır. Örneğin, Fairness Attribute=Gender dişilere karşı önyargıyı ölçmek için kullanılırsa, izlenen grup değeri "Kadın" ve başvuru grubu değeri "Erkek" olur.

Olumlu/Olumsuz Sonuç -Yöneltme algılamasında önemli bir kavram, modelin olumlu ve olumsuz sonucudur. Örneğin, Claim approved olumlu bir sonuç olarak kabul edilebilir ve Claim denied olumsuz bir sonuç olarak kabul edilebilir.

Ayrık etki -önyargıyı ölçmek için kullanılan ölçüm (izlenen gruba ilişkin olumlu sonuç yüzdesinin başvuru grubu için olumlu sonuç yüzdesine oranı olarak hesaplanır). Farklı etki değeri belirtilen bir eşikten küçükse sapma olduğu söyilir.

Örneğin, erkekler tarafından yapılan sigorta taleplerinin %80 'i onaylanırsa, ancak kadınlar tarafından yapılan taleplerin yalnızca %60 'ı onaylanırsa, farklı etki: 60/80 = 0.75olur. Genellikle yöneltme eşiği değeri 0.8' dir. Bu farklı etki oranı 0.8' den düşük olduğundan, modelin önyargılı olduğu kabul edilir.

Farklı etki oranı 1.25 ' den büyük olduğunda [ ters değer (1/disparate etki) 0.8] eşiği altında olduğunda da yanlı olarak kabul edilir.

Adaleti değerlendirmeye ve geliştirmeye ilişkin bir video izleyin

Sonuçlarınızın önyargılı olmadığından emin olmak amacıyla bir makine öğrenimi modelinin nasıl adil olarak değerlendirileceğini görmek için bu videoyu izleyin.

Bu video, bu belgedeki kavramları ve görevleri öğrenmek için görsel bir yöntem sağlar.

Kullanıcı arabiriminde AutoAI deneyi için adalet testi uygulanması

Deney Ayarları' nı açın.

Fairness (Adalet) sekmesini tıklatın.

Adil olmak için seçenekleri etkinleştirin. Seçenekler şunlardır:

- Adalet değerlendirmesi: Ayrık etki payını hesaplayarak her bir ardışık düzende yanlılık olup olmadığını denetlemek için bu seçeneği etkinleştirin. Bu yöntem, bir boru hattının bir grup için diğerinden daha sık olumlu (tercih edilen) bir sonuç sağlama eğilimi olup olmadığını izler.

- Adalet eşiği: Ayrık etki payının değerine dayalı olarak bir ardışık düzende sapma olup olmadığını belirlemek için bir adalet eşiği belirleyin. Varsayılan değer, 0.80değerinden daha düşük bir etki oranını temsil eden 80 'dir.

- Olumlu sonuçlar: Öngörü sütununuzda olumlu olarak değerlendirilecek değeri belirtin. Örneğin, değer "onaylandı", "kabul edildi" ya da öngörü tipinize uyan herhangi bir değer olabilir.

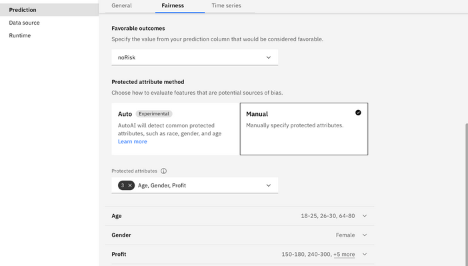

- Otomatik korumalı öznitelik yöntemi: Olası bir yöneltme kaynağı olan özelliklerin nasıl değerlendirileceğini seçin. Otomatik algılamayı belirtebilirsiniz; bu durumda AutoAI , cinsiyet, etnik köken, medeni durum, yaş ve posta kodu gibi yaygın olarak korunan öznitelikleri algılar. Her kategori içinde, AutoAI korumalı bir grup belirlemeye çalışır. Örneğin,

sexkategorisi için izlenen grupfemaleolur.

Not: Otomatik kipte, bir özelliğin tipik olmayan değerleri varsa (örneğin, İngilizce dışında bir dilde olması), özellik korunan bir öznitelik olarak doğru olarak tanımlanmamış olabilir. Otomatik algılama yalnızca İngilizce için desteklenir.- El ile korunan öznitelik yöntemi: Bir sonucu el ile belirtin ve öznitelik listesinden seçim yaparak korunan özniteliği belirtin. Öznitelikleri el ile sağladığınızda, bir grup tanımlamanız ve beklenen sonuçlara (başvuru grubu) sahip olma olasılığını belirtmeniz ya da beklenen sonuçlardan (izlenen grup) sapmayı saptamak için gözden geçirilmeniz gerektiğini unutmayın.

Örneğin, bu resim izleme için el ile belirtilen öznitelik grupları kümesini gösterir.

Deneyi uygulamak için ayarları kaydedin ve boru hatlarınıza adil değerlendirme uygulamak için deneyi çalıştırın.

Notlar:

- Çok yönlü modeller için, olumlu ya da değil olarak sınıflandırmak üzere öngörü sütununda birden çok değer seçebilirsiniz.

- Regresyon modelleri için, olumlu kabul edilen ya da edilmeyen bir sonuç aralığı belirtebilirsiniz.

- Zaman serisi deneyleri için adalet değerlendirmeleri şu anda mevcut değildir.

Adaleti ölçmek için otomatik olarak saptanan özniteliklerin listesi

Otomatik algılama etkinleştirildiğinde, eğitim verilerinde varsa AutoAI aşağıdaki öznitelikleri otomatik olarak algılar. Öznitelikler İngilizce olmalıdır.

- age

- vatandaş_durumu

- renk

- engellilik

- etnik köken

- gender

- genetik_bilgisi

- handicap

- dil

- evlilik

- politika_inancı

- hamilelik

- din

- gazi_durumu

Not defterinde AutoAI deneyi için adalet testi uygulanması

Bir dizüstü bilgisayarda eğitilmiş bir AutoAI deneyinde adalet testi gerçekleştirebilir ve kullanıcı arabiriminde sağlanan yeteneklerin ötesine geçebilirsiniz.

Sapma saptama örneği

Bu örnekte, Watson Machine Learning Python API (ibm-watson-machine-learning) kullanılarak, yöneltme algılaması için eniyileyici yapılandırması aşağıdaki girişle yapılandırılır:

- ad-deneyi adı

- tahmin_tipi-sorunun tipi

- tahmin_kolonu-hedef kolon adı

- fairness_info-bias algılama yapılandırması

fairness_info = {

"protected_attributes": [

{

"feature": "personal_status",

"reference_group": ["male div/sep", "male mar/wid", "male single"],

"monitored_group": ["female div/dep/mar"]

},

{

"feature": "age",

"reference_group": [[26, 100]],

"monitored_group": [[1, 25]]}

],

"favorable_labels": ["good"],

"unfavorable_labels": ["bad"],

}

from ibm_watson_machine_learning.experiment import AutoAI

experiment = AutoAI(wml_credentials, space_id=space_id)

pipeline_optimizer = experiment.optimizer(

name='Credit Risk Prediction and bias detection - AutoAI',

prediction_type=AutoAI.PredictionType.BINARY,

prediction_column='class',

scoring='accuracy',

fairness_info=fairness_info,

retrain_on_holdout=False

)

Sonuçlar değerlendiriliyor

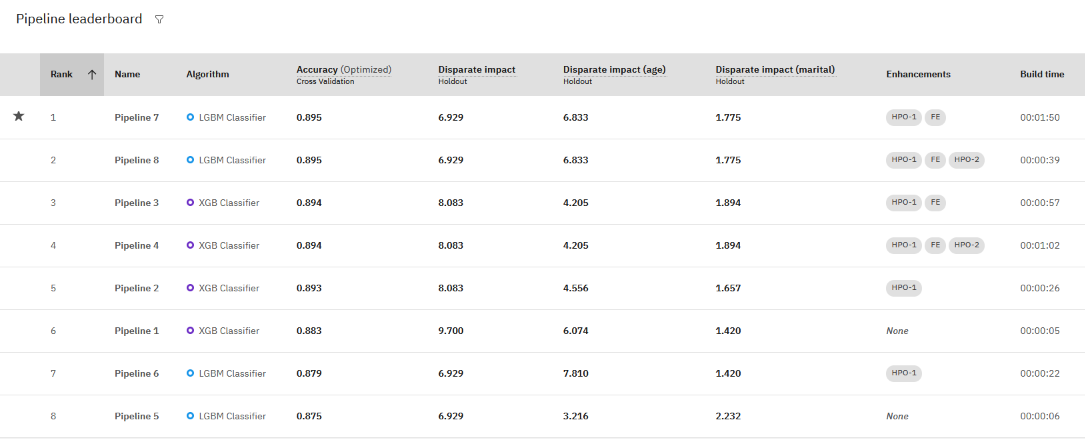

Her bir ardışık işlem için değerlendirme sonuçlarını görüntüleyebilirsiniz.

- Deney özeti sayfasından, Ardışık Düzen lider kartına ilişkin süzgeç simgesini tıklatın.

- Denemeniz için farklı etki metriklerini seçin. Bu seçenek, izlenen her grup için bir genel ölçümü ve bir ölçümü değerlendirir.

- Sapmayla ilgili bir sorununuz olup olmadığını belirlemek için ya da yalnızca hangi boru hattının adil değerlendirme için daha iyi performans gösterdiğini belirlemek için ardışık işlem ölçümlerini inceleyin.

Bu örnekte, doğruluk için birinci sırada yer alan ardışık işlem hattı da kabul edilebilir sınırlar içinde farklı bir gelir puanına sahiptir.

Sapma azaltma

Bir deneyde sapma algılanırsa, deneyinizi "birleşik skorlayıcılar" kullanarak eniyileyebilirsiniz: accuracy_and_disparate_impact ya da r2_and_disparate_impact, her ikisi de açık kaynak LALE paketitarafından tanımlanır.

Birleşik puan verenler, adil ve doğru modeller döndürmek için arama ve optimizasyon sürecinde kullanılır.

Örneğin, bir sınıflandırma deneyinde sapma algılamasını optimize etmek için:

- Deney Ayarları' nı açın.

- Tahminler sayfasında deneyde Doğruluk ve farklı etki ' yi optimize etmeyi seçin.

- Deneyi yeniden çalıştırın.

Doğruluk ve farklı etki metriği, sınıflandırma deneyleri için doğruluk ve adalet için birleşik bir puan oluşturur. Daha yüksek bir puan, daha iyi performans ve adalet ölçülerini gösterir. Farklı etki puanı 0.9 ile 1.11 (kabul edilebilir bir düzey) arasındaysa, doğruluk puanı döndürülür. Tersi durumda, doğruluk puanından daha düşük bir etki değeri döndürülür; bu değer, eşitlik boşluğunu gösteren daha düşük (negatif) bir değerle birlikte döndürülür.

Gelişmiş kullanıcılar, bir not defterini adalet algılama yöntemlerini uygulamak ya da gözden geçirmek içinkullanabilir. Varsayılan olarak AutoAI ile sağlananın ötesinde adalet ve önyargı algılama yeteneklerini genişletmek için lale, AIF360 gibi üçüncü kişi paketlerini kullanarak eğitimli bir AutoAI modelini daha da iyileştirebilirsiniz.

boru hatlarını adalet için değerlendiren örnek bir not defterinigözden geçirin.

Bu AutoAIiçinde Bias algılanmasıyla ilgili Orta düzey web günlüğü gönderisini okuyun.

Sonraki adımlar

AutoAI deneylerinde sorun giderme

Üst konu: AutoAI genel bakış